Тратите часы на ручной сбор цен конкурентов, копирование контактов потенциальных клиентов или анализ отзывов о продукции? Парсинг данных с сайта решает эту проблему, автоматизируя процесс сбора информации и экономя десятки часов работы каждую неделю. Этот мощный инструмент позволяет извлекать нужные данные с веб-страниц без участия человека, обрабатывая за минуты то, на что вручную ушли бы дни.

Тратите часы на ручной сбор цен конкурентов, копирование контактов потенциальных клиентов или анализ отзывов о продукции? Парсинг данных с сайта решает эту проблему, автоматизируя процесс сбора информации и экономя десятки часов работы каждую неделю. Этот мощный инструмент позволяет извлекать нужные данные с веб-страниц без участия человека, обрабатывая за минуты то, на что вручную ушли бы дни.

Подходит ли вам парсинг, если вы не программист? Современные решения делают автоматический сбор данных доступным каждому - от простых функций в Excel до готовых сервисов, не требующих написания кода. В статье разберем все способы парсинга: от базовых инструментов для новичков до продвинутых Python-скриптов, покажем реальные кейсы экономии времени и расскажем о правовых нюансах.

Подходит ли вам парсинг, если вы не программист? Современные решения делают автоматический сбор данных доступным каждому - от простых функций в Excel до готовых сервисов, не требующих написания кода. В статье разберем все способы парсинга: от базовых инструментов для новичков до продвинутых Python-скриптов, покажем реальные кейсы экономии времени и расскажем о правовых нюансах.

В этой статье:

- Что такое парсинг данных с сайта и зачем он нужен бизнесу

- Какие инструменты выбрать для парсинга: от Excel до Python

- Пошаговая инструкция: как создать свой первый парсер

- Как парсить сложные сайты с защитой и JavaScript

- Правовые аспекты: что можно парсить без нарушения закона

- Реальные кейсы и результаты парсинга данных

- Часто задаваемые вопросы о парсинге данных

-

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Что такое парсинг данных с сайта и зачем он нужен бизнесу

Парсинг данных с сайта — это автоматический процесс извлечения структурированной информации с веб-страниц. Представьте библиотекаря, который способен за секунды просмотреть тысячи книг и выбрать именно те сведения, которые вам нужны. Парсер работает аналогично: он "читает" HTML-код страниц, находит нужные элементы и сохраняет данные в удобном формате.

Источник: shutterstock.com

Этот инструмент анализирует структуру веб-страницы, определяет, где находится искомая информация, и извлекает её согласно заданным правилам. Парсер может собирать заголовки статей, цены товаров, контактные данные, описания или любую другую информацию, размещенную на сайте.

Парсинг простыми словами: как это работает

Процесс парсинга напоминает работу опытного аналитика, который изучает множество источников по определенной схеме. Сначала парсер отправляет запрос на веб-страницу, получает её HTML-код, затем ищет в нём нужные теги и элементы. Например, если требуется собрать названия товаров, программа найдет все теги с классом "product-title" и извлечет текст из них.

Современные парсеры умеют работать с динамическим контентом, который загружается через JavaScript. Они имитируют поведение браузера, ждут полной загрузки страницы и только потом начинают сбор данных. Такой подход позволяет получать информацию даже с самых сложных интернет-ресурсов.

Важно понимать, что парсинг - это не хакерство или взлом. Инструмент просто читает публично доступную информацию, которую видит любой посетитель сайта. Разница лишь в скорости и объеме обработки данных.

Читайте также!

Практические задачи: мониторинг цен, анализ конкурентов, сбор контактов

Мониторинг цен конкурентов становится ключевой задачей для интернет-магазинов. Парсинг позволяет ежедневно отслеживать изменения стоимости товаров у десятков конкурентов, автоматически формируя отчеты и уведомления о критических изменениях. Розничные сети используют такие данные для корректировки собственной ценовой политики.

Анализ контента конкурентов помогает маркетологам изучать стратегии продвижения. Автоматический сбор заголовков статей, описаний товаров и рекламных материалов дает понимание трендов в отрасли. SEO-специалисты парсят ключевые слова и мета-теги для анализа поисковой оптимизации.

Сбор контактных данных для B2B-продаж значительно ускоряется благодаря парсингу каталогов компаний. Вместо ручного поиска email-адресов и телефонов парсер обрабатывает справочники за несколько часов. Исследовательские агентства используют такие методы для формирования баз данных потенциальных респондентов.

Экономия времени и денег: сравнение с ручным сбором данных

Ручной сбор данных требует огромных временных затрат. Аналитик может обработать 50-100 товарных карточек за рабочий день, тогда как парсер справляется с тысячами позиций за час. При мониторинге цен на 1000 товаров ручная работа займет две недели, автоматический сбор - несколько часов.

Источник: shutterstock.com

Стоимость ручной обработки растет пропорционально объему данных. Привлечение дополнительных сотрудников для крупных проектов увеличивает расходы на зарплаты, обучение и контроль качества. Парсинг требует разовых затрат на настройку и периодического обслуживания.

Качество автоматического сбора превосходит человеческие возможности. Парсер не устает, не делает ошибок при копировании и не пропускает позиции. Данные поступают в структурированном виде, готовом для анализа. Регулярное обновление информации происходит по расписанию без участия персонала.

Какие инструменты выбрать для парсинга: от Excel до Python

Выбор инструмента для парсинга зависит от сложности задач, технических навыков и бюджета проекта. Новички могут начать с встроенных функций Excel, продвинутые пользователи выберут специализированные программы, а разработчики предпочтут написать собственный код на Python. Каждый подход имеет свои преимущества и ограничения.

Простые инструменты подходят для разовых задач и небольших объемов данных. Профессиональные решения справляются с масштабными проектами, сложными сайтами и регулярным обновлением информации. Готовые сервисы экономят время на разработку, но ограничивают возможности настройки.

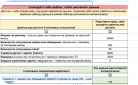

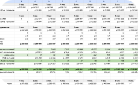

Таблица 1. Сравнение инструментов парсинга

| Инструмент | Сложность освоения | Стоимость | Возможности | Лучше всего подходит для |

| Excel/Google Таблицы | Низкая | Бесплатно | Простые статичные сайты | Разовые задачи, малые объемы |

| Готовые программы | Средняя | От $50/месяц | Визуальная настройка | Бизнес без технических навыков |

| Python + библиотеки | Высокая | Бесплатно | Неограниченные | Сложные проекты, разработчики |

| Облачные сервисы | Низкая | От $30/месяц | Масштабируемость | Регулярный сбор больших данных |

Парсинг в Excel и Google Таблицах без программирования

Excel предлагает несколько встроенных функций для импорта данных с веб-страниц. Функция WEBSERVICE() загружает содержимое по URL, а FILTERXML() помогает извлечь нужные элементы из HTML. Google Таблицы используют функцию IMPORTHTML() для импорта таблиц и списков с сайтов.

Эти методы работают только со статичными страницами, где данные присутствуют в исходном HTML-коде. Динамический контент, загружающийся через JavaScript, остается недоступным. Функции подходят для парсинга простых каталогов, таблиц курсов валют или новостных лент.

Настройка требует базовых знаний HTML-структуры. Необходимо найти нужные теги на странице и правильно составить запрос. Автоматическое обновление данных настраивается через планировщик пересчета формул. Такой подход подойдет для мониторинга небольшого количества источников.

Читайте также!

Python для новичков: BeautifulSoup и готовые скрипты

Python стал стандартом для парсинга благодаря богатой экосистеме библиотек и простому синтаксису. BeautifulSoup упрощает работу с HTML, позволяя находить элементы по тегам, классам и атрибутам. Библиотека requests отправляет HTTP-запросы и получает содержимое страниц.

Готовые скрипты экономят время на начальной настройке. В интернете доступны тысячи примеров для популярных сайтов и типовых задач. Модификация готового кода требует минимальных знаний программирования. Новички могут изучить основы парсинга, экспериментируя с рабочими примерами.

Установка Python и необходимых библиотек выполняется через команду pip install. Разработка начинается с простых скриптов для парсинга одной страницы. Постепенно добавляются функции сохранения данных, обработки ошибок и многопоточности. Такой подход позволяет изучить парсинг на практике.

Готовые сервисы и программы для парсинга

Специализированные программы предлагают визуальный интерфейс для создания парсеров. Пользователь указывает на элементы страницы мышкой, программа автоматически определяет селекторы и создает правила извлечения. Такой подход не требует знания программирования или HTML.

Источник: shutterstock.com

Облачные платформы обеспечивают высокую производительность и масштабируемость. Парсинг выполняется на удаленных серверах, что снимает нагрузку с локального компьютера. Встроенные функции ротации IP-адресов и обхода защиты упрощают работу со сложными сайтами.

Готовые решения включают шаблоны для популярных интернет-площадок. База готовых парсеров покрывает основные категории сайтов: интернет-магазины, социальные сети, новостные порталы. Пользователь получает рабочий инструмент за несколько минут без настройки.

Пошаговая инструкция: как создать свой первый парсер

Создание парсера начинается с анализа целевого сайта и определения структуры данных. Первый проект лучше выбрать простым - статичную страницу с четкой HTML-разметкой. Пошаговый подход поможет избежать типичных ошибок и постепенно освоить все аспекты парсинга.

Подготовительный этап включает установку необходимого программного обеспечения и изучение структуры целевой страницы. Инструменты разработчика браузера покажут HTML-код и помогут найти нужные элементы. Планирование структуры выходных данных упростит последующую обработку результатов.

Настройка окружения и установка библиотек

Установка Python начинается с загрузки официального дистрибутива с сайта python.org. Рекомендуется выбрать последнюю стабильную версию для вашей операционной системы. При установке важно отметить опцию добавления Python в системный PATH для доступа из командной строки.

Менеджер пакетов pip устанавливается автоматически с современными версиями Python. Основные библиотеки для парсинга устанавливаются командами в терминале. Requests обеспечивает HTTP-запросы, BeautifulSoup парсит HTML, pandas работает с данными в табличном формате.

pip install requests beautifulsoup4 pandas lxml

Выбор среды разработки зависит от личных предпочтений. Начинающим подойдет IDLE, входящий в стандартную поставку Python. Более опытные разработчики предпочтут PyCharm, Visual Studio Code или Jupyter Notebook. Важно настроить подсветку синтаксиса и автодополнение для комфортной работы.

Парсинг простого сайта: от кода до результата

Первый скрипт начинается с импорта необходимых библиотек и отправки запроса на целевую страницу. Функция requests.get() загружает HTML-содержимое, которое передается в BeautifulSoup для парсинга. Важно проверить статус ответа сервера перед началом обработки.

import requests

from bs4 import BeautifulSoup

url = "https://example-store.com/catalog"

response = requests.get(url)

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

products = soup.find_all('div', class_='product-item')

for product in products:

title = product.find('h3', class_='product-title').text.strip()

price = product.find('span', class_='price').text.strip()

print(f"{title}: {price}")

Поиск элементов выполняется методами find() и find_all(). Первый возвращает один элемент, второй - список всех совпадений. Селекторы указывают тег и атрибуты для точного поиска. Метод .text извлекает текстовое содержимое без HTML-тегов, .strip() убирает лишние пробелы.

Обработка ошибок предотвращает остановку скрипта при проблемах с сетью или изменениях структуры сайта. Конструкция try-except перехватывает исключения и позволяет продолжить работу. Логирование ошибок помогает выявить проблемные элементы и улучшить надежность парсера.

Увеличим продажи вашего бизнеса с помощью комплексного продвижения сайта. Наша команда экспертов разработает для вас индивидуальную стратегию, которая позволит в разы увеличить трафик, количество заявок и лидов, снизить стоимость привлечения клиентов и создать стабильный поток новых покупателей.

Сохранение данных в удобном формате

CSV формат подходит для большинства задач анализа данных. Библиотека pandas упрощает создание таблиц и сохранение результатов. DataFrame позволяет структурировать данные в строки и столбцы, добавлять новую информацию и выполнять базовую обработку.

import pandas as pd

data = []

for product in products:

title = product.find('h3', class_='product-title').text.strip()

price = product.find('span', class_='price').text.strip()

data.append({'название': title, 'цена': price})

df = pd.DataFrame(data)

df.to_csv('products.csv', index=False, encoding='utf-8')

Excel формат удобен для просмотра и редактирования данных в офисных приложениях. Pandas поддерживает сохранение в XLSX с настройкой форматирования. JSON подходит для передачи данных между системами и создания API. Выбор формата зависит от дальнейшего использования собранной информации.

База данных SQLite оптимальна для больших объемов информации и сложных запросов. Pandas может напрямую сохранять DataFrame в таблицы базы данных. Такой подход обеспечивает быстрый поиск, фильтрацию и агрегацию результатов парсинга.

Как парсить сложные сайты с защитой и JavaScript

Современные веб-ресурсы активно применяют защитные механизмы против автоматического сбора данных. Антибот-системы анализируют поведение посетителей, скорость запросов и характеристики браузера. Динамическая загрузка контента через JavaScript требует эмуляции полноценного браузера для получения данных.

Источник: shutterstock.com

Преодоление защиты требует комплексного подхода. Простое увеличение задержек между запросами может не сработать с продвинутыми системами защиты. Необходимо имитировать естественное поведение пользователя, использовать реальные заголовки браузера и чередовать IP-адреса.

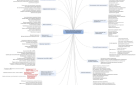

Таблица 2. Типы защиты сайтов и методы обхода

| Тип защиты | Описание | Методы обхода | Сложность |

| Rate limiting | Ограничение частоты запросов | Задержки, ротация IP | Низкая |

| User-Agent фильтры | Блокировка ботов по заголовкам | Реальные заголовки браузеров | Низкая |

| JavaScript проверки | Выполнение кода на стороне клиента | Selenium, Playwright | Средняя |

| Captcha | Выполнение кода на стороне клиента | Сервисы распознавания | Средняя |

| Fingerprinting | Анализ характеристик браузера | Полная эмуляция браузера | Высокая |

| WAF системы | Профессиональная защита | Комбинация всех методов | Очень высокая |

Обход капчи и антибот-систем

Капча представляет наибольшую сложность для автоматизированного парсинга. Современные системы используют поведенческий анализ, отслеживая движения мыши, время заполнения форм и паттерны кликов. Простые текстовые капчи можно распознать с помощью OCR библиотек, но reCAPTCHA требует специализированных решений.

Гайд «Как увеличить количество заявок с сайта на 250%» — это практический разбор кейсов, где компании усилили конверсию за счет эффективной стратегии работы с трафиком.

Что вы получите:

8 бизнес-кейсов, где конверсия в лид выросла до +250%;

практические шаги для повышения количества заявок без дополнительных вложений;

инструменты, позволяющие снизить стоимость заявки в 2 раза;

понимание, какие элементы сайта дают максимальный прирост обращений.

Гайд подойдет предпринимателям, руководителям и маркетологам, которые хотят увеличить поток заявок и использовать потенциал сайта на полную.

Перейдите к материалу и узнайте, какие решения принесут вашему бизнесу больше продаж.

Сервисы распознавания капчи предлагают API для автоматического решения головоломок. Система отправляет изображение на сервис, получает решение и продолжает работу. Стоимость составляет несколько центов за одну капчу, что может быть оправдано при работе с ценными данными.

Изменение поведенческих паттернов помогает обойти системы анализа. Случайные задержки между действиями, имитация движений мыши и постепенное увеличение активности делают бота похожим на человека. Ротация сессий и cookies предотвращает накопление подозрительной статистики.

Работа с динамическими сайтами

Selenium автоматизирует реальный браузер, выполняя JavaScript и получая полностью отрендеренный контент. Этот инструмент эмулирует действия пользователя: клики, скроллинг, заполнение форм. WebDriver поддерживает все популярные браузеры и позволяет настроить их поведение.

from selenium import webdriver

from selenium.webdriver.common.by import By

import time

driver = webdriver.Chrome()

driver.get("https://dynamic-site.com")

# Ожидание загрузки динамического контента

time.sleep(5)

products = driver.find_elements(By.CLASS_NAME, "product-item")

for product in products:

title = product.find_element(By.TAG_NAME, "h3").text

print(title)

driver.quit()

Playwright представляет современную альтернативу Selenium с лучшей производительностью. Инструмент поддерживает параллельное выполнение, автоматическое ожидание элементов и перехват сетевых запросов. Встроенные функции создания скриншотов помогают отладить работу парсера.

Headless режим браузера ускоряет парсинг, убирая графический интерфейс. Потребление ресурсов снижается, что позволяет запускать несколько экземпляров одновременно. Настройка viewport и эмуляция мобильных устройств дает доступ к адаптивным версиям сайтов.

Использование прокси и смена User-Agent

Прокси-серверы скрывают реальный IP-адрес парсера, распределяя запросы между разными точками. Ротация адресов предотвращает блокировку по IP и позволяет обходить географические ограничения. Качественные прокси обеспечивают стабильное соединение и высокую скорость работы.

import requests

import random

proxies_list = [

"http://proxy1.example.com:8080",

"http://proxy2.example.com:8080",

"http://proxy3.example.com:8080"

]

user_agents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36"

]

proxy = random.choice(proxies_list)

headers = {"User-Agent": random.choice(user_agents)}

response = requests.get(url, proxies={"http": proxy}, headers=headers)

Смена User-Agent маскирует парсер под различные браузеры и устройства. База реальных заголовков имитирует популярные комбинации браузер-операционная система. Случайный выбор из списка предотвращает обнаружение по повторяющимся паттернам.

Дополнительные HTTP-заголовки усиливают маскировку. Accept-Language указывает предпочитаемый язык, Referer имитирует переход с другой страницы, Accept-Encoding поддерживает сжатие данных. Полный набор заголовков делает запросы неотличимыми от браузерных.

Читайте также!

Правовые аспекты: что можно парсить без нарушения закона

Парсинг данных находится в правовой серой зоне, где законность зависит от множества факторов. Публично доступная информация обычно может быть собрана, но условия использования сайта могут это запрещать. Персональные данные требуют особой осторожности и соблюдения требований защиты конфиденциальности.

Юридические риски варьируются от предупреждений до серьезных штрафов. Нарушение авторских прав, сбор персональных данных без согласия или игнорирование условий использования может привести к судебным искам. Понимание правовых границ защищает от неприятных последствий.

Источник: shutterstock.com

Принципы этичного парсинга:

-

Уважение к robots.txt и условиям использования сайтов

-

Ограничение частоты запросов для предотвращения перегрузки серверов

-

Избегание сбора персональных данных без явного согласия

-

Использование данных только в законных целях

-

Указание источника при публикации собранной информации

Разрешенные и запрещенные виды данных

Публичная информация, такая как цены товаров, описания продуктов и новости, обычно доступна для парсинга. Эти данные размещены для свободного просмотра посетителями сайта. Однако коммерческое использование может требовать разрешения правообладателей.

Персональные данные попадают под строгое регулирование законодательства о защите данных. Имена, адреса, телефоны и email требуют согласия на обработку. Сбор таких сведений без разрешения может привести к серьезным штрафам и судебным искам.

Защищенный авторским правом контент нельзя копировать в коммерческих целях. Тексты статей, фотографии товаров и описания услуг могут использоваться только с разрешения авторов. Краткое цитирование в исследовательских целях обычно допускается.

Как не нарушить условия использования сайтов

Файл robots.txt содержит официальные правила для автоматических программ. Директивы User-agent указывают, какие части сайта доступны для индексации. Соблюдение этих правил демонстрирует уважение к политике владельца ресурса.

Пользовательские соглашения часто содержат запреты на автоматический сбор данных. Внимательное изучение условий использования поможет избежать нарушений. Некоторые сайты разрешают парсинг для исследовательских целей, но запрещают коммерческое использование.

Источник: shutterstock.com

Техническое поведение парсера не должно нарушать работу сайта. Слишком частые запросы могут привести к перегрузке серверов и ухудшению пользовательского опыта. Разумные задержки и ограничение параллельности демонстрируют ответственный подход.

Защита персональных данных и этичный парсинг

Российское законодательство требует согласия на обработку персональных данных. Автоматический сбор контактной информации без уведомления пользователей нарушает требования закона. Необходимо уведомлять субъектов данных о целях сбора и способах использования информации.

GDPR в Европейском союзе устанавливает еще более строгие требования. Принцип минимизации данных требует сбора только необходимой информации. Право на забвение позволяет пользователям требовать удаления своих данных из баз.

Анонимизация и агрегирование снижают правовые риски. Обезличивание данных перед анализом защищает конфиденциальность пользователей. Статистические выводы на основе агрегированных данных обычно не нарушают требования защиты персональной информации.

Реальные кейсы и результаты парсинга данных

Практическое применение парсинга демонстрирует его эффективность в различных отраслях бизнеса. Компании экономят значительные ресурсы на аналитике, мониторинге конкурентов и исследованиях рынка. Автоматизация рутинных задач освобождает сотрудников для более творческой работы.

Измеримые результаты включают сокращение времени на сбор данных, увеличение объема анализируемой информации и улучшение качества принимаемых решений. Регулярный мониторинг рынка позволяет быстро реагировать на изменения и сохранять конкурентные преимущества.

Источник: shutterstock.com

Популярные задачи для парсинга:

-

Мониторинг цен и акций конкурентов в интернет-магазинах

-

Сбор контактных данных потенциальных клиентов из каталогов

-

Анализ отзывов и репутации брендов в социальных сетях

-

Отслеживание упоминаний компании в новостных источниках

-

Исследование рынка труда и анализ вакансий

-

Сбор данных для машинного обучения и аналитики

-

Мониторинг изменений на сайтах поставщиков

-

Агрегация контента для новостных и информационных порталов

Мониторинг цен конкурентов: экономия до 80% времени

Крупная розничная сеть электроники автоматизировала отслеживание цен на 5000 товарных позиций у 20 конкурентов. Ручной мониторинг требовал работы трех аналитиков в течение полной недели. Парсер обрабатывает весь ассортимент за 4 часа, освобождая команду для анализа трендов и принятия решений.

Система отправляет уведомления при критических изменениях цен, позволяя оперативно корректировать стратегию. Автоматические отчеты показывают динамику рынка, выявляют сезонные колебания и прогнозируют тренды. Данные интегрируются с системой управления ценами для быстрого реагирования.

Результат проекта превзошел ожидания: выручка выросла на 12% благодаря оптимальному ценообразованию. Время реакции на изменения рынка сократилось с недель до часов. Освобожденные аналитики переключились на стратегические задачи и работу с поставщиками.

Сбор контактных данных для email-маркетинга

B2B-компания в сфере IT-услуг использовала парсинг для формирования базы потенциальных клиентов. Целевая аудитория включала стартапы и средний бизнес определенных регионов. Автоматический сбор email-адресов из деловых каталогов и корпоративных сайтов заменил покупку готовых баз сомнительного качества.

Парсер собирал контактную информацию с соблюдением требований законодательства о персональных данных. Система фильтровала дубликаты, проверяла актуальность email-адресов и сегментировала аудиторию по отраслям. Каждая запись содержала название компании, сферу деятельности и размер бизнеса.

Источник: shutterstock.com

Email-кампании показали открываемость в 28% против 15% при использовании покупных баз. Конверсия в заявки увеличилась в 2.3 раза благодаря точной сегментации и персонализации сообщений. Стоимость привлечения лида снизилась на 60% по сравнению с традиционными методами.

Анализ отзывов и репутации конкурентов

Производитель потребительской электроники запустил проект мониторинга репутации в интернете. Парсер собирал отзывы о продукции компании и конкурентов с популярных торговых площадок и обзорных сайтов. Анализ тональности помогал выявлять проблемы качества и реагировать на негативные тренды.

Система обрабатывала тысячи отзывов ежедневно, выделяя ключевые темы и проблемы. Машинное обучение классифицировало отзывы по категориям: качество, дизайн, цена, сервис. Автоматические дашборды показывали рейтинги продуктов и сравнение с конкурентами.

Результаты анализа повлияли на разработку новых моделей и улучшение существующих. Время выхода обновленных версий продуктов сократилось на 30% благодаря быстрому выявлению недостатков. Индекс удовлетворенности клиентов вырос на 25% после устранения основных претензий.

Часто задаваемые вопросы о парсинге данных

Можно ли парсить любой сайт?

Технически парсить можно практически любой сайт, но юридически это не всегда допустимо. Публично доступная информация обычно может быть собрана, но условия использования конкретного сайта могут это запрещать. Персональные данные требуют особой осторожности и соблюдения законодательства о защите конфиденциальности.

Сколько стоит заказать парсер у программиста?

Стоимость разработки парсера зависит от сложности проекта. Простой скрипт для одного сайта может стоить от 5000 до 15000 рублей. Сложные системы с обходом защиты и интеграцией с базами данных обойдутся в 50000-150000 рублей.

Как часто можно обращаться к сайту без блокировки?

Оптимальная частота запросов зависит от размера целевого сайта. Крупные ресурсы выдерживают десятки запросов в минуту, небольшие сайты могут заблокировать уже при 5-10 запросах подряд. Рекомендуется начинать с 1-2 запросов в минуту и постепенно увеличивать интенсивность.

Какие альтернативы есть парсингу?

API интерфейсы предоставляют структурированный доступ к данным без необходимости парсинга HTML. RSS каналы позволяют получать обновления контента в автоматическом режиме. Готовые базы данных и агрегаторы собирают информацию из различных источников.

Нужны ли специальные навыки программирования?

Базовые задачи парсинга можно решить с помощью готовых инструментов без программирования. Excel, Google Таблицы и специализированные программы предлагают визуальные интерфейсы. Сложные проекты требуют знания Python и понимания основ веб-технологий.