О чем речь? Технология Big Data – «современная нефть», как считают многие эксперты. Это большие массивы данных, представляющие существенную ценность для бизнеса, корпораций и даже стран. Их можно использовать не только в благих, но и в корыстных целях.

О чем речь? Технология Big Data – «современная нефть», как считают многие эксперты. Это большие массивы данных, представляющие существенную ценность для бизнеса, корпораций и даже стран. Их можно использовать не только в благих, но и в корыстных целях.

Как работает? Принцип работы технологии заключается в сборе, хранении, обработке и анализе больших данных. В бизнесе все это делается перед запуском нового продукта, для изучения целевой аудитории или ее привлечения. Занимаются Big Data специально обученные этому люди.

Как работает? Принцип работы технологии заключается в сборе, хранении, обработке и анализе больших данных. В бизнесе все это делается перед запуском нового продукта, для изучения целевой аудитории или ее привлечения. Занимаются Big Data специально обученные этому люди.

В статье рассказывается:

- Что такое Big Data

- Отличия Big Data

- Параметры Big Data

- Источники Big Data

- Этапы работы с технологией Big Data

- Сферы использования технологии Big Data

- Польза технологии Big Data для бизнеса

- Кто работает с технологией Big Data

- Методы работы аналитика Big Data

- Преимущества и недостатки технологии Big Data

- Часто задаваемые вопросы о технологии Big Data

-

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Что такое Big Data

Термином Big Data обозначают колоссальный объем информации, зачастую совершенно неструктурированной и хранящейся на каком-либо цифровом носителе. Размер массива данных настолько велик, что традиционными методами подвергнуть его обработке не получается. Это понятие также трактуется как комплексная технология поиска, анализа, подготовки и интерпретации результатов информации в огромных объемах.

Автором словосочетания «большие данные» считают Клиффорда Линча, который впервые его употребил в 2008 году в специальном выпуске журнала Nature. Он комментировал стремительный рост потоков информации. Технология Big Data позволяет обрабатывать массив данных, объем которых превышает 150 Гб в 24 часа.

Источник: shutterstock.com

Аналитики многих статистических компаний подсчитали, что в 2005 году на планете в виртуальном пространстве специалистам было доступно около 4–5 эксабайт информации (4–5 миллиардов гигабайт). Всего через пять лет технологии обработки Big Data развились настолько, что стало возможным упорядочивать до 0,19 зеттабайт (1 Зб = 1024 Эб).

В 2012 году этот показатель составлял уже 1,8 Зб, а в 2015 – 7 Зб. Эксперты дают обоснованные прогнозы, что в 2024 году системы больших данных будут оперировать 147 зеттабайтами информации.

Вплоть до 2011 года цифровая технология Big Data считалась теорией, которая активно изучалась и классифицировалась, практически не имея никакого прикладного значения. Но бурный экспоненциальный рост объемов информации поставил перед учеными проблему качественной ее обработки. Эта тенденция хорошо просматривается по статистике Google Trends.

Вопросом плотно занялись такие тяжеловесы цифровой индустрии как Microsoft, IBM, Oracle, EMC и пр. Что такое технология больших данных Big Data стали пытаться выяснить IT-специалисты в разных университетах и научных лабораториях. С 2014 года начались попытки внедрения наработок в практической плоскости.

Читайте также!

Отличия Big Data

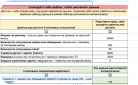

Big Data, несмотря на свой огромный размер, не является обычной базой. У нее есть свои принципиальные отличия. Некоторые их них сведены в таблицу, представленную ниже.

| Обычная база данных | Big Data |

| Массив, состоящий из сведений о тысячах работников корпорации. Такие сведения имеют четкую структуру. Основные параметры легко алгоритмизируются и могут быть представлены при помощи электронных таблиц. (Например, MS Excel) | Журнал действий сотрудников. Например, полный перечень сведений, добываемых работниками среднего кол-центра (на 500 человек) в процессе деятельности |

| Сведения о Ф.И.О., поле, возрасте всех 2,5 млрд пользователей социальной сети ВКонтакте являются всего лишь огромной базой данных | Переходы по ссылкам, перепосты, лайки, клики другие действия пользователей ВКонтакте, в том числе и в мобильной версии |

| Архив, содержащий записи видеокамер визуального наблюдения | Пакет данных, включающий в себя сведения о нарушениях ПДД с фиксацией государственных номерных знаков; информация, полученная при помощи комплекса распознавания лиц, обо всех пассажирах, передвигающихся в поездах метрополитена, и сравнение с базами данных лиц, находящихся в розыске |

Параметры Big Data

Что же это такое – технология Big Data?

Выделяют шесть основных характеристик, начинающихся с латинской буквы «V»:

-

Volume. Объем составляет не менее 150 Гб в 24 часа.

-

Velocity. Скорость. Структура и объем больших данных постоянно подвергается изменениям. Поэтому обработка таких огромных массивов возможна только на машинах с большой вычислительной мощностью. Например, сервис FlightRadar24, объединяющий в себе информацию обо всех перемещениях находящихся в воздухе самолетов в режиме реального времени.

-

Variety. Разнообразие. Big Data может состоять из данных разных форматов: графические, аудио- и видеофайлы, тексты и т. д.

-

Veracity. Достоверность. Вся информация собирается только из верифицированных источников, обработка идет при помощи точных и объективных методов. Только тогда получают релевантные результаты. Крупные корпорации принимают их к сведению при реализации стратегий.

-

Variability. Изменчивость. Big Data ежесекундно обновляется. Поток данных крайне нестабилен и зависит от скорости обмена, количества источников в каждый момент времени, действий пользователей. Поэтому при анализе все эти переменчивые факторы должны обязательно учитываться. Например, сводная информация об авиасообщении будет актуальна при использовании своевременных поправок о задержках рейсов, погодных условиях в конкретных местностях, изменениях в расписании и т. д.

-

Value. Ценность. Массив сам по себе не несет никакой особой ценности. Информация только тогда полезна, когда в результате обработки и анализа можно сделать конкретные выводы, позволяющие принимать обоснованные решения. Например, разработать оптимальную логистическую систему городского транспорта.

По степени обработанности большие базы данных могут быть:

-

Структурированными. Данные сгруппированы по какой-то выборке. Например, примененная в медицине технология Big Data позволяет отсортировать сведения по температуре, артериальному давлению и другим важным параметрам находящихся на лечении пациентов.

-

Частично структурированными. Определенная доля массива все еще находится в хаотичном состоянии и требует тщательной обработки. Пример: база данных о ЧС в регионе за определенный промежуток времени.

-

Неструктурированными. Часто в качестве примера приводят совокупность файлов (фотографии, музыка, клипы и пр.), размещенных пользователями социальной сети.

Источник: shutterstock.com

Есть еще одно принципиальное отличие Big Data от обычных баз данных. Оно заключается в том, что благодаря распределенной структуре управление информационным массивом можно производить при помощи множества микросервисов. Это работает как сложный фильтр. На вход подается массив разрозненных сведений, а в итоге выкристаллизовывается концентрированный фрагмент нужной и полезной информации.

Если в этом процессе всего один источник, то обработка пройдет быстро и без затруднений. Но при огромных потоках информации из разных мест обычные инструменты могут не совладать с таким объемом. Поэтому спроектированы специализированные сервисы, значительно ускоряющие работу с большой базой данных.

Источники Big Data

Big Data как одна из разновидностей сквозных технологий необходима для анализа всех значимых параметров с целью выработки правильного стратегического решения. При помощи больших данных конструируют различные модели, чтобы проследить, как производимые изменения будут влиять на конечный продукт или идею.

Перечислим основные источники Big Data:

-

интернет вещей (IoT);

-

социальные сети и электронные средства массовой информации;

-

сведения, собираемые различными фирмами: заявки на приобретение товаров и услуг, транзакции, профили пользователей;

-

показания приборов: датчики метеорологических и сейсмологических станций, данные со спутников и пр.;

-

государственные электронные сервисы: записи ЗАГС, сведения о регистрации и т. д.;

-

медицинские учреждения: совокупность результатов анализов и исследований, анамнезы.

Источник: shutterstock.com

Спецслужбы США в 2007 году обзавелись мощной системой сбора данных обо всех пользователях социальных сетей и сервисов Microsoft, Google, Apple, Yahoo. Кроме того, тщательно анализируется содержание телефонных разговоров и СМС. Последние модели компьютеров позволяют быстро и беспрепятственно получить доступ к большим базам данных. Вычислительные системы обладают емкими хранилищами и мощнейшими серверами.

Для работы с Big Data активно применяются облачные технологии. Например, Data Lake (место хранения огромных объемов неструктурированных данных из одного источника) и Hadoop (комплекс инструментов для проектирования приложений, выполняющих распределенные вычисления).

Этапы работы с технологией Big Data

Принцип работы технологии заключается в сборе, хранении, обработке и анализе больших данных. Рассмотрим каждый из этапов подробнее.

Сбор данных

Получают большие данные из самых разных источников. Фильтрация и очистка сведений (Data Cleaning) производятся при помощи специальных утилит. При этом разметка массивов информации происходит таким образом, чтобы алгоритм программ находил нужные фрагменты наиболее быстро и рационально.

Сортировка данных может быть сделана с учетом фактора времени. Например, при формировании метеорологической сводки берутся данные за последние 24 часа. Для извлечения конкретных сведений за определённый период используется функция выбора и захвата данных.

Хранение данных

Традиционные объемы информации содержатся на обычных носителях соответствующей емкости. В силу того, что технологии Big Data оперируют гигантскими массивами, для размещения данных применяются облачные сервера, а обработка происходит методом распределенных вычислительных мощностей. Эта особенность позволяет делать одновременные запросы нескольким людям, физически находящимся в разных точках.

Источник: shutterstock.com

Перечислим основные хранилища Big Data:

-

DWH (Data Warehouse). Централизованное место, где находятся рабочие файлы компании, используемые в повседневной практике. Данные отсортированы по сферам специализации и расположены в хронологическом порядке. Например, DWH маркетплейса, содержащий сведения о товаре, клиентах, заказах и пр. Формирование массивов информации осуществляется по принципу ETL (от англ. Extract, Transform, Load), смысл которого состоит в том, что данные добываются, упорядочиваются (подвергаются обработке) и сохраняются в едином формате.

-

Data Lake. Массив, состоящий из разрозненных, не имеющих единого формата сведений. Данные извлекаются, затем помещаются в базу, где и происходит их трансформация. Этот способ имеет аналогию с виртуальным диском, на котором содержатся упорядоченные графические, текстовые и видеофайлы. А роль базы данных играет таблица разметки, указывающая адреса ячеек, где хранится определенная информация.

-

СУБД. Системы управления базами данных подразделяются на обычные и реляционные. При работе с Big Data чаще применяются вторые. Данные структурированы в виде таблиц, связанных друг с другом ключами. Для вызова команд при запросах применяется SQL (специальный алгоритмический язык). Строки этих таблиц являются событиями, а столбцы – их атрибутами. Такой подход позволяет очень быстро формировать отчеты, так как обрабатываются данные, расположенные в соседних ячейках.

Некоторые фирмы практикуют использование обычных (нереляционных) СУБД. В таких системах таблицы не связаны между собой, а данные хранятся по заранее созданной схеме. Этот метод организации обеспечивает высокую скорость извлечения необходимого фрагмента и запуск высоконагруженной программы. Ярким примером является DynamoDB от Amazon. Это бессерверная СУБД типа NoSQL, поддерживающая запросы на различных языках. Область применения: системы «умного дома», цифровая реклама, индустрия онлайн-игр.

Обработка данных

Чем значимее объем информации, тем больше времени потребуется на ее анализ. Технология Big Data подразумевает использование специализированных программ, функционирующих по принципу MapReduce.

Приложение производит выбор фрагментов по заданным критериям, а потом данные распределяются между разными объектами (серверами, компьютерами и пр.). Затем уже происходит непосредственная обработка всех этих сегментов, причем процесс развивается параллельно.

Источник: shutterstock.com

Приведем примеры:

-

Hadoop. Является проектом фонда Apache Software Foundation и представляет собой комплекс утилит с открытым исходным кодом. Инструментом могут пользоваться несколько специалистов одновременно.

-

Apache Spark. Сборник библиотек и фреймворков для обработки потоковых данных с высокой скоростью. Применимы для обучения нейросетей.

Работой с этими инструментами занимаются DWH-аналитики.

Анализ данных

Прежде чем применить массивы больших данных на практике, необходимо произвести их анализ по разным объективным критериям. Для этого применяют:

-

SQL. Язык формирования запросов при взаимодействии с СУБД.

-

Нейросети. Обучаемые математические модели, позволяющие с очень большой скоростью взаимодействовать с гигантскими объемами информации.

Для обработки больших данных разработаны аналитические платформы на базе Business Intelligence (BI). Например, Power BI Microsoft – сервис бизнес-аналитики, собирающий сведения из разных источников и преобразующий данные в отчеты по сформированным запросам.

Читайте также!

Сферы использования технологии Big Data

Практическая область применения достаточно обширна:

-

Тяжелая индустрия. Активное использование в промышленности позволяет оптимизировать технологические процессы и прогнозировать спрос на товар.

-

Рекрутинг. Работа с Big Data помогает HR-менеджерам в поиске, сортировке, подборе кадров.

-

Финансово-кредитные учреждения. Цифровизация банковских операций в значительной степени облегчает взаимодействие с клиентами. В последнее время повышенное внимание уделяется безопасности при проведении транзакций.

-

Медицина. Технология Big Data в этой сфере используется для диагностирования, создания новых препаратов, оптимизации мероприятий по диспансеризации и вакцинации и пр.

-

Государственные органы. Цифровое правительство обеспечивает граждан легким доступом к управленческим функциям властных структур с исключением участия человеческого фактора. Это способствует значимому снижению влияния на решения коррупционной составляющей.

-

Маркетинг. Значительно облегчает работу специалистов по рекламе при продвижении товара или услуги на потребительском рынке.

Источник: shutterstock.com

-

Медиа. Big Data активно применяется при анализе сегментов целевой аудитории.

-

Логистика. Оптимизация маршрутов, снижение себестоимости грузовых и пассажирских перевозок.

-

Обработка графических файлов. Большие информационные массивы позволяют на практике применять колоссальное число различных стилей и фильтров, значительно упрощая работу дизайнеров.

-

Розничная торговля. В области ритейла Big Data успешно используется маркетплейсами для формирования уникальных торговых предложений на основе анализа влияющих на объемы продаж факторов.

-

Рынок недвижимости. Сбор информации о жилье позволяет риелторам делать актуальные предложения клиентам.

-

Спорт. В этой сфере чаще всего Big Data используется при рекрутинге перспективных игроков и разработке тренировочных планов.

-

Агропромышленный комплекс. Большие данные позволяют получать точные сводки об изменениях погоды и корректировать время проведения посевных кампаний.

-

Геология. Производятся поиск новых месторождений и оценка их рентабельности.

-

Образование. Технология Big Data способствует более продуктивному выбору необходимых курсов для обучения.

Польза технологии Big Data для бизнеса

Для коммерческих структур большие данные полезны в трех основных векторах:

-

Запуск наиболее перспективных стартапов.

-

Анализ и сегментирование целевой аудитории.

-

Лидогенерация.

Big Data позволяет MasterCard противостоять мошенническим действиям. В результате чего удается сохранить более 3 млрд долларов в год.

Такие гиганты как Netflix, Procter & Gamble, The Boeing Company, Coca-Cola, используя технологию Big Data, изучают и прогнозируют спрос на продукцию.

Читайте также!

Кто работает с технологией Big Data

Перечислим основные специализации, которые связаны с технологией Big Data, а также навыки, которыми должны обладать сотрудники, выбравшие эту работу.

Data Scientist

Инженер, чьими основными обязанностями являются: сбор и анализ данных; проектирование математических моделей, их тестирование и обучение; формирование отчетов, содержащих прогноз развития. Например, специалист, используя статистические данных по транзакциям, совершенным в банкомате, предсказывает рост спроса на наличные средства. Этот прогноз позволяет оптимизировать график завоза купюр.

Человек, выбравший освоение этой профессии, должен обладать аналитическим складом ума и владеть основами программирования.

Data Analyst

В его распоряжении такой же набор инструментов, но аналитик занимается интерпретацией объективных релевантных результатов обработки информации.

Источник: shutterstock.com

С Big Data в своей основной работе сталкиваются и другие профессионалы:

-

дизайнеры интерфейсов на основе изучения поведенческих реакций пользователей создают графические оболочки приложений;

-

NLP-инженеры используют большие данные для проектирования чат-ботов и автоматизации справочной системы;

-

маркетологи, активно занимающиеся продвижением продукта на потребительский рынок;

-

инженеры и программисты промышленных предприятий, оптимизирующие технологические процессы.

Data engineer

В круг обязанностей специалиста входит техническое обеспечение проектов; он организует сбор, обработку первичных данных. Дата-инженеры могут участвовать в разработке программного обеспечения, проектируя алгоритмы автоматизации рутинных задач. Профессионал должен на достаточно высоком уровне владеть Python и SQL, уметь работать с Framework.

Методы работы аналитика Big Data

Так как в настоящее время существуют эффективные технологии работы с Big Data, многие компании активно используют большие массивы разнородной информации. Зачастую перед анализом база данных подвергается структурированию, чтобы выбрать только нужные фрагменты. Получает распространение применение искусственного интеллекта.

Рассмотрим основные способы анализа Big Data:

-

Описательная аналитика (Descriptive Analytics) является самой популярной и востребованной методикой. Принцип работы заключается в поиске ответа на вопрос «Что произошло?». Цель этого способа – выяснение причин и закономерностей наступления событий (как позитивных, так и негативных) в той или иной области деятельности. По результатам анализа дается алгоритм усовершенствования системы и общий прогноз развития. В качестве основного инструмента используются базовые математические функции. Типичный пример – маркетинговые исследования или сбор статистических данных посредством сервиса Google Analytics.

Существуют две основные категории моделей, служащих основанием для формирования финансовой стратегии. Первая учитывает цены, установившиеся на рынке. Данные о стоимости товаров в других торговых точках собираются и анализируются, после чего принимается решение о назначении своей.

Вторая категория математических моделей предусматривает построение графика спроса, кривая которого отображает зависимость объема продаж от стоимости единицы продукта. Подобный метод широко применяется онлайн.

-

Прогнозная или предикативная аналитика (Predictive Analytics) способствует созданию сценария, по которому с большой степенью вероятности будут развиваться события. В арсенале специалистов этого направления находятся инструменты, позволяющие применять готовые шаблоны и сравнивать их поведение с реальными объектами, обладающими схожими наборами характеристик. Предикативная аналитика позволяет прогнозировать тренды на биржах.

Источник: shutterstock.com

-

Предписывающая аналитика (Prescriptive Analytics). Является развитием предыдущей техники. При помощи Big Data и современных цифровых технологий становится возможным определение проблемных узлов в бизнес-процессе (и в любой другой сфере тоже) и разработать стратегию, исключающую их влияние в будущем. Например, сеть центров медицины Aurora Health Care каждый год экономит 6 млн долларов при активном применении Prescriptive A При этом в клиниках сократилось число повторных госпитализаций на 10 %.

-

Диагностическая аналитика (Diagnostic Analytics). Анализ данных нужен для вскрытия истинных причин произошедших событий. Например, специалисты компании Amazon изучают продажи и валовую прибыль разных товаров с целью выяснения источников возникающих проблем. Сбор информации осуществляется по двум критериям:

-

Клиентская база, содержащая обезличенные данные пользователей, снижает эффективность обработки данных.

-

Если сведения для анализа обладают повышенной степенью агрегированности, то оперировать можно будет только лишь средними значениями показателей.

-

Для обработки Big Data онлайн применяют суперкомпьютеры, чья производительность и мощность многократно превышает обычный ПК.

Преимущества и недостатки технологии Big Data

Большие данные – это локомотив глобальной экономики. Как и у любой технологии, Big Data обладает как преимуществами, так и некоторыми недостатками.

Преимущества технологии Big Data

С их помощью можно:

-

Использовать в повседневной деятельности огромные массивы информации.

-

Оперативно учитывать влияние сбоев и других угроз. Big Data позволяет кредитно-финансовым учреждениям активно бороться со всеми видами мошеннической деятельности и предотвращать правонарушения в экономической сфере.

-

Разрабатывать планы развития на основе достаточно точного прогнозирования. Например, организовать рекламную кампанию, опираясь на данные, полученные при помощи сервиса Яндекс.Метрика, который содержит сведения об огромном количестве пользователей и их целевых действиях: посещениях, кликах, заявках и пр. Всесторонний анализ позволяет добиться больших успехов при меньшем бюджете.

Источник: shutterstock.com

-

Заниматься эффективным планированием на достаточно длительную перспективу. Разработка стратегии развития на основе анализа данных о продажах, доходах и издержках за предыдущие отчетные периоды.

-

Совершенствовать продукт без повторения прошлых ошибок. Допустим, менеджеры, отвечающие за доставку товара, обнаружили, что вечером процент отмены заказа повышается. Следовательно, клиенты не хотят продолжительное время ожидать продукт, предпочитая покупать его в обычном магазине. Проблема решается сокращением времени доставки за счет привлечения в эти часы большего числа курьеров.

Востребованность технологии Big Data

Значимость этой технологии в современном мире постоянно возрастает. Эксперты подсчитали, что объем рынка Big Data в России к 2024 году вырастет с 45 млрд до 65 млрд рублей. А если реализуется самый оптимистичный сценарий, то и до 230 миллиардов.

Усиливающаяся конкуренция подталкивает коммерческие структуры все активнее прибегать к анализу огромных массивов данных. Например, информационный бюллетень The Bell сообщает, что компания Caterpillar еще в 2014 году теряла 9–18 млрд долларов из-за недостаточного внедрения технологии Big Data. А теперь около 3,5 миллионов единиц специального подвижного состава содержит в своей конструкции специальные датчики, которые собирают разные сведения о техническом состоянии. В результате повысился коэффициент использования машин, а затраты на ремонт и обслуживание сократились.

По мере внедрения технологии в разные сферы деятельности растет спрос и на специалистов, способных работать с большими данными. Так, Академия больших данных MADE от Mail.ru Group и HeadHunter в 2020 году по результатам исследования пришли к выводу, что на рынке труда вырос спрос на инженеров, обслуживающих и анализирующих огромные массивы информации. Количество вакансий увеличилось примерно в 10 раз за последние четыре года.

Структура распределения дата-специалистов по отраслям: на IT-сферу приходится 38 %, в кредитных учреждениях занято 29 %, а в коммерческих организациях трудится 9 %.

Недостатки технологии Big Data

У применения больших данных также есть недостатки:

-

Трудности с масштабированием. Например, онлайн-сервис в обычное время посещает стабильное количество пользователей. После проведения рекламной кампании внезапно многократно возрастает число посетителей. Не каждая платформа будет оставаться работоспособной при таком наплыве. Проблема решается применением облачных хранилищ, поддающихся быстрому масштабированию.

-

Высокая степень рисков и угроз. Big Data при работе требуют повышения уровня безопасности. Это особенно критично в медицине, банковской сфере и некоторых производствах, связанных с опасными и вредными веществами. Отчасти проблема решается организацией распределенного контролируемого доступа к базам данных. Активно применяется сквозное шифрование, аутентификация и некоторые другие эффективные меры.

-

Высокие затраты. Работа с большими данными требуют значительных вычислительных мощностей, применения серверов и другого дорогостоящего оборудования. Она доступна только людям, прошедшим определенную подготовку и получившим специфические навыки.

Источник: shutterstock.com

Проблемы технологии Big Data

Основные сложности:

-

Большой массив информации часто представляет собой собрание разрозненных неструктурированных данных. Поэтому их анализ затруднен. Чем больше критериев используется для выборки, тем выше вероятность получения ошибки.

-

Для хранения и обработки данных требуется введение дополнительных мер безопасности.

-

Манипуляции со сведениями, содержащими личные данные пользователей, могут привести к возникновению проблем с приватностью.

-

Возможно не вполне чистоплотное использование Big Data. Например, при попытках повлиять на выборы или заработать на бирже, используя инсайдерскую информацию.

Часто задаваемые вопросы о технологии Big Data

Ниже отвечаем на часто задаваемые вопросы о технологии Big Data.

С чего начать изучение технологии?

Целесообразно прежде всего изучить теоретические основы работы с информацией. Затем нужно освоить методику сбора и анализа данных. На этом этапе не принципиально, будет ли таблица на сотню строк или на несколько миллионов. Главное – постичь принцип. Понимание специфики работы фильтров, очистки и анализа данных заложит отличный фундамент в освоение любой специализации при работе с Big Data.

Есть ли отличие между Big Data и Data Science?

Data Science является научной дисциплиной, изучающей закономерности поведения потоков информации, причем необязательно огромных. В качестве инструментов используются математические и статистические методы исследования.

Big Data – это гигантская база данных, зачастую не имеющая строгой упорядоченной структуры. Смысл состоит в том, чтобы из множества разрозненных и мало друг с другом связанных сведений выудить рациональное зерно, которое может быть использовано в практической деятельности.

Существуют ли курсы по изучению работы с информацией?

Профессию в этой сфере можно приобрести, учась в некоторых технических высших учебных заведениях России, начиная с 2023 года. Существуют и специализированные онлайн-курсы. Самостоятельное изучение требует много времени и усилий, сопряжено с рядом сложностей.

Оставить комментарий

Оставить комментарий