О чем речь? Индексация сайта в Google — добавление его страниц в базу данных поисковой системы, после чего они появляются в результатах запросов пользователей. Без этого люди не узнают о существовании ресурса.

О чем речь? Индексация сайта в Google — добавление его страниц в базу данных поисковой системы, после чего они появляются в результатах запросов пользователей. Без этого люди не узнают о существовании ресурса.

Как ускорить? Нужно использовать Google Search Console для отправки URL, создать карту сайта sitemap.xml, обеспечить качественную внутреннюю перелинковку и регулярно обновлять контент. Также важно оптимизировать скорость загрузки страниц и сделать мобильную версию ресурса.

Как ускорить? Нужно использовать Google Search Console для отправки URL, создать карту сайта sitemap.xml, обеспечить качественную внутреннюю перелинковку и регулярно обновлять контент. Также важно оптимизировать скорость загрузки страниц и сделать мобильную версию ресурса.

В этой статье:

- Алгоритм индексации сайта в Google

- Как проверить индексацию сайта в Google

- Факторы, препятствующие индексации сайта в Google

- Настройка индексации сайта в Google

- Как метатеги ускоряют индексацию сайта в Google

- Как выявить ошибки индексации сайта в Google

- Часто задаваемые вопросы об индексации сайта в Google

-

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Алгоритм индексации сайта в Google

Такой процесс важен для каждого ресурса, независимо от его направленности и вида бизнеса. Только сайт, прошедший индексацию, способен привлекать целевую аудиторию, ведь это его основная функция.

После 2022 года, когда в России прекратила работу платформа Google Ads, единственным способом продвижения в поиске этой фирмы стала органическая выдача. Поэтому лишь проиндексированные сайты полностью доступны пользователям и способны получать стабильный поток переходов.

За этот процесс отвечают поисковые роботы. Они автоматически сканируют страницы, оценивают содержимое, обновления и наличие ошибок. Популярные ресурсы с большим объемом трафика проверяются примерно один-два раза в неделю, а сайты средств массовой информации и новостные порталы, где контент обновляется часто, могут анализироваться поисковыми системами несколько раз в день.

Источник: shutterstock.com

Google ежедневно сканирует миллионы URL, но в индекс попадают не все. Новые сайты без внешних ссылок могут быть пропущены, а ресурсы с низким качеством контента не добавляются в базу данных и не продвигаются в поиске.

Если структура площадки слишком разветвленная, часть внутренних страниц может остаться вне индекса. В такой ситуации робот Googlebot обычно обрабатывает только верхние уровни ресурса.

Исправить это помогает внутренняя перелинковка — она распределяет вес между страницами и повышает их значимость для поисковой системы. Процесс добавления в базу данных в Google имеет свои особенности и отличается от принципов, используемых в «Яндексе», поэтому требует особого подхода.

Чтобы поддерживать актуальность и точность поисковой выдачи, «Гугл» применяет сложные алгоритмы для сканирования и индексирования сайтов. В основе этого процесса лежит регулярное обновление базы данных, благодаря чему пользователи получают свежую информацию максимально быстро. Обход сайтов выполняется автоматически роботами Googlebot, которые переходят по ссылкам и находят новый или измененный контент.

Процесс сканирования страниц в Google состоит из нескольких этапов:

-

Открытие. Googlebot ищет новые или обновленные страницы, переходя по ссылкам или через добавленные URL в Google Search Console.

-

Краулинг. На этом этапе робот анализирует содержимое страницы — текст, изображения, видео, а также структуру и иерархию сайта.

-

Индексирование. После анализа данные добавляются в базу данных Google, и страница становится доступной в поиске.

-

Ранжирование. На заключительном этапе система использует более 200 факторов, чтобы определить позицию страницы в результатах поиска по конкретным запросам.

Этот процесс позволяет Google поддерживать актуальность интернет-выдачи и одновременно дает владельцам сайтов возможность оптимизировать свои страницы, повышая их видимость и доступность для пользователей.

Читайте также!

Как проверить индексацию сайта в Google

Существуют способы, как это сделать. Можете выбрать любой вариант: каждый из них надежен.

-

Проверить индексацию можно с помощью различных онлайн-сервисов и SEO-инструментов.

-

Для быстрого контроля иногда можно использовать даже GoogleDocs. Если вставить в документ или таблицу ссылку на страницу, которая уже находится в индексе, при наведении курсора появится окно с предварительным просмотром. Если же ресурс не занесён в базу, Google Docs не отобразит этот просмотр.

-

Использование оператора site. В поисковой строке введите запрос site:name.com/, заменив name.com на адрес сайта. Так можно примерно узнать, сколько страниц ресурса проиндексировано. Проверка отдельных из них осуществляется аналогично — указав их полный URL. Если результаты отсутствуют, это сигнализирует о проблемах с занесением в базу.

-

Проверку индексации можно выполнить с помощью GoogleSearch Console. Зарегистрируйте сайт в аккаунте GSC и подтвердите владение. Теперь используйте вкладку индексации для анализа страниц. Это можно делать как для всех сразу, так и по отдельности.

Факторы, препятствующие индексации сайта в Google

Иногда проблема с занесением в базу оказывается сложнее, и простая отправка страницы на повторную проверку не помогает. Google может не индексировать сайт по двум основным причинам:

-

Поисковая система считает, что размещенный контент не представляет ценности для пользователей. По этой причине не добавляет страницы или весь сайт в индекс.

-

На ресурсе присутствуют технические ошибки, мешающие работе поисковых роботов.

Необходимо как можно быстрее выявить и устранить причину неполадки — оптимально делать это методом исключения, постепенно проверяя все возможные варианты.

Файл robots.txt

Он регулирует доступ различных роботов к вашему сайту, включая поисковых. Если в нем указано ограничение на посещение определенной страницы, она не будет индексироваться — то же самое касается и всего ресурса. В Google Search Console такие запреты легко обнаружить в разделе «Индексирование страниц».

Источник: shutterstock.com

Система уведомит о наличии ограничений на сканирование в robots.txt, после чего его можно удалить вручную, убрав директиву disallow. Кроме того, Google может исключить сайт из индекса, если файл возвращает серверную ошибку с кодом 500.

Теги noindex

Если на странице установлена запрещающая метка, поисковые роботы либо не смогут ее просканировать, либо посетят без добавления в индекс. В Google Search Console есть инструмент URL Inspection.

Он позволяет определить, какие страницы заблокированы для сканирования. Также рекомендуется провести аудит сайта через Ahrefs, чтобы убедиться в отсутствии на этих ресурсах тега robots со значением noindex или заголовка X-Robots-Tag.

Правильность файла Sitemap

Если добавить страницу в карту сайта, вероятность ее индексации увеличится. Определить, есть ли она в Sitemap, можно с помощью Google Search Console. Следите, чтобы размер файла не превышал 10 МБ, и после каждого обновления загружайте его в консоль. Однако важно помнить, что этот способ не решит проблему, если на сайте присутствуют более серьезные ошибки.

Канонические страницы

Тег сообщает поисковику, какая версия ресурса является оригинальной, и выглядит так: . Обычно он отсутствует или указывает на саму страницу. Ошибочный тег может перенаправить Google на несуществующий адрес, из-за чего нужный документ не индексируется. В инструменте проверки URL такие случаи отображаются как предупреждения по каноническим адресам. Нужно проверить, куда ведет тег.

Источник: shutterstock.com

Файл Sitemap помогает определить, какой URL считается каноническим для конкретного контента. Если в карте сайта указан один адрес, а происходит перенаправление на другой, возникает несоответствие, которое может помешать корректной индексации.

Отсутствие внутренней перелинковки

Нормальной считается такая структура сайта, при которой каждая страница открыта для сканирования и индексации, а также имеет уникальный URL. Ещё она должна быть доступна через внутренние ссылки <a href="">, прописанные в исходном HTML-коде.

Проверьте, есть ли на сайте страницы-сироты — те, что не связаны с другими разделами или ресурсами. Найти их можно с помощью специальных инструментов, например Netpeak Spider. Отсутствие внутренних ссылок мешает поисковикам находить такие ресурсы. Чтобы ускорить индексацию важного контента, разместите ссылку на него на одной из наиболее посещаемых страниц сайта. Их сканируют чаще.

Nofollow-ссылки

Проверьте, чтобы внутренние ссылки на страницы, подлежащие индексации, не содержали такой атрибут. Параметр rel="nofollow" в них не передают показатель PageRank, поэтому Google их не сканирует.

Читайте также!

Низкая ценность страницы

Контент должен быть уникальным, иначе он вряд ли будет корректно проиндексирован. Кроме того, Google оценивает полезность страницы для пользователей. Поэтому, если технических ошибок нет, но ресурс все равно не попадает в индекс, возможно, поисковик просто не считает его достаточно ценным.

Google оценивает полезность страниц по принципу E-E-A-T (опыт, экспертность, авторитетность, доверие). Поэтому контент должен быть релевантным, актуальным, основанным на достоверных источниках и созданным экспертами. Регулярное обновление и дополнение материалов также служит для поисковика сигналом, что страница представляет ценность для пользователей.

Проверьте качество ресурсов, которые не попадают в индекс, дорабатывайте и улучшайте их, а затем повторно отправляйте на занесение в базу через Google Search Console. Также проанализируйте поисковые запросы пользователей — возможно, страница просто не соответствует их интересам. По этой причине Google и не видит смысла включать ее в индекс.

Дублирование страниц

Это может происходить из-за автоматической генерации, ошибок в структуре или неправильного деления кластера на две части. Наличие дублей воспринимается поисковыми системами как признак низкого качества сайта и контента, поэтому их стоит избегать.

Источник: shutterstock.com

Если на ресурсе много похожих страниц, внесите элементы рандомизации, чтобы разнообразить их. Также можно переписать тексты вручную или использовать для уникализации ChatGPT.

Отсутствие трафика

На сайте могут присутствовать страницы, которые никто не смотрит. Если их становится слишком много, это негативно влияет на общие показатели ресурса. На некоторых контентных площадках структура устроена так, что при перераспределении трафика появляются страницы, куда пользователи практически не заходят. В таком случае стоит провести аудит и удалить их — это может помочь решить проблемы с индексацией.

Малое число входящих ссылок

Наличие внешних уникальных адресов, ведущих на сайт, — положительный сигнал для Google, который способствует более быстрой индексации. Чем больше качественных ссылок приходит на ресурс, тем выше его значимость в глазах поисковика. Однако важно, чтобы эти сайты были тематически близкими, имели высокий трафик и хорошие показатели доверия.

Google уделяет особое внимание качеству ссылок и активно борется со спамом. Поисковик ценит только те адреса, которые ведут с авторитетных и тематически схожих сайтов. Поэтому, чтобы ускорить индексацию, рекомендуется использовать надежные сервисы для размещения ссылок. Так вы можете быть уверены, что они принесут сайту пользу.

Для ускорения индексации можно применить многоуровневую ссылочную стратегию Tier 2. Суть ее в том, чтобы приобретать бэклинки на сайты, уже ведущие на ваш ресурс. Это повышает активность поисковых роботов и способствует более быстрой индексации. Дополнительно можно использовать ссылки из социальных сетей, направляя их на страницы, которые еще не попали в базу.

Настройка индексации сайта в Google

-

Прежде чем начинать работу в этом направлении, важно определить, какие ссылки уже занесены в базу, а какие — нет. Это можно сделать с помощью специализированных инструментов и сервисов, которые используют специалисты по поисковой оптимизации (SEO). Например, парсера в связке с XEvilи фермой мобильных прокси.

-

XEvil — инструмент автоматического распознавания капч, позволяющий обходить большинство типов CAPTCHA и заменяющий такие сервисы, как AntiGate(Anti-Captcha), RuCaptcha и DeCaptcher. Продается в паре с «Хрумером».

-

A-Parser — универсальный инструмент для парсинга, который решает широкий спектр задач. Он выполняет запросы к реальной поисковой выдаче Google, сохраняет полученные данные и проводит их анализ.

-

Ферма мобильных прокси использует модемы с симками для отправки запросов в реальную выдачу, снижая число появляющихся CAPTCHA.

Базируясь на данных анализа, необходимо составить таблицу с перечнем ссылок, требующих индексации.

Перечислим шаги, необходимые для занесения в базу ресурса в Google.

Настройка ответов сервера

Это нужно, чтобы информировать поисковые системы о текущем состоянии страниц. Правильно настроенные ответы сервера, или коды состояния HTTP (например, 200, 404, 301), позволяют Google определить, какие ресурсы доступны, а какие были перемещены либо удалены. Это важно для безопасности сайта, оптимизации его работы и корректного соблюдения технических требований.

Источник: shutterstock.com

Для этого создается конфигурационный файл — .htaccess (для Apache) или nginx.conf (для Nginx), в котором задаются правила отправки HTTP-заголовков и ограничения по типам контента. Например, можно настроить сервер так, чтобы он возвращал определенный код состояния (например, 404 — «Не найдено») или добавлял кэшируемый заголовок Expires, ускоряющий загрузку страниц.

Эта настройка требует специальных знаний в сфере веб-разработки и администрирования. Если вы не обладаете достаточным опытом, лучше поручить эту задачу специалисту.

Автогенерирующийся Sitemap.xml

Этот файл помогает поисковым системам эффективнее работать с сайтом, ускоряя индексацию новых и обновленных страниц. Это особенно актуально для крупных ресурсов с регулярно меняющимся контентом.

Увеличим продажи вашего бизнеса с помощью комплексного продвижения сайта. Наша команда экспертов разработает для вас индивидуальную стратегию, которая позволит в разы увеличить трафик, количество заявок и лидов, снизить стоимость привлечения клиентов и создать стабильный поток новых покупателей.

Фавиконки и индексация

Первое — это небольшие значки, отображающиеся рядом с названием сайта в поисковой выдаче. Хотя они не оказывают прямого влияния на процесс индексации, их наличие улучшает удобство взаимодействия пользователя с ресурсом.

Google учитывает такие элементы, поскольку хороший UX (пользовательский опыт) является важным фактором ранжирования. Кроме того, favicon помогает повысить узнаваемость ресурса и сделать его более запоминающимся, что может косвенно способствовать росту позиций в результатах поиска.

Настройка микроразметки Open Graph

Она позволяет правильно отображать контент при публикации в социальных сетях, делая ссылки более привлекательными и заметными. Это повышает кликабельность и трафик, что положительно сказывается на SEO. Настройка OG-тегов требует понимания структуры и атрибутов разметки.

Этапы такого процесса:

-

Определить тип контента, который нужно структурировать (статья, изображение, видео, товар).

-

Выбрать соответствующий тип объекта OG (Article, Music, Videoи так далее).

-

Задать основные атрибуты — название, описание, автора, дату публикации, изображение.

-

Вставить код разметки OG в HTML страницы.

-

Проверить корректность настройки через онлайн-валидаторы.

Настройка микроразметки Schema.org

Этот стандарт помогает добавить структурированную дополнительную информацию, благодаря которой поисковые системы точнее понимают содержание страниц. Это ускоряет индексацию, способствует появлению сайта в расширенных сниппетах и повышает его видимость в поисковой выдаче, улучшая поведенческие факторы.

Чтобы внедрить микроразметку Schema.org на сайте, нужно:

-

Определить тип контента, который требуется структурировать — товары, события, отзывы и так далее.

-

Выбрать подходящий объект Schema.org (например, Product для товара или Event для мероприятия).

-

Указать ключевые атрибуты и их значения. Этоname, price, image, description для Product; startTime, endTime, location для

-

Проверить корректность разметки с помощью инструмента GoogleRich Results Test.

-

Добавить её код в HTML страницы.

Настройка canonical

Канонические теги применяются для обозначения предпочтительной версии похожих страниц, что помогает избежать проблем с дублирующимся контентом. Это является важной частью SEO, так как позволяет поисковым системам определить, какой ресурс считается основным и должен индексироваться в первую очередь.

Источник: shutterstock.com

Этапы настройки канонического тега:

-

Определить основной URL страницы. Предпочтительно с правильной структурой, без ошибок и с учетом всех параметров (язык, регион, товар).

-

Добавить в HTML тег link с атрибутом rel="canonical" внутри элемента head, указывая на выбранный основной URL. Например: .

-

Проделать аналогичные действия на всех страницах, где нужно указать основной URL. Убедиться, что href содержит корректный адрес.

-

Проверить правильность настройки с помощью инструментов веб-мастеров, таких как GoogleSearch Console или Bing Webmaster Tools.

-

При редизайне сайта или обновлении контента нужно актуализировать канонические теги.

Настройка файла robots.txt

Он находится в корне сайта и контролирует, какие страницы и разделы видны поисковым системам. Это конфигурационный текстовый файл. Он помогает исключать из индексации неактуальные, недоработанные или конфиденциальные страницы, ограничивая доступ краулеров.

Особенности его составления:

-

В корневой папке сайта создайте файл robots.txt.

-

Откройте его в любом текстовом редакторе.

-

Впишите инструкции для краулеров, например запрет на индексацию, указание главного зеркала или дополнительные параметры.

-

Сохраните файл.

-

Загрузите robots.txt на сервер, чтобы он был доступен из корня сайта.

Настройка страниц пагинации

Это позволяет поисковым системам корректно понимать структуру многостраничных списков, что способствует более эффективной индексации всех страниц. Правильная настройка пагинации должна использовать теги rel="next" и rel="prev".

Добавление сайта в поисковую систему (ПС) Google

Каждый из этих шагов играет важную роль в SEO, помогая ресурсу быстрее индексироваться, повышая его видимость для запросов браузеров и привлекая целевой трафик. Для добавления страниц в базу применяется Google Search Console: достаточно добавить и верифицировать сайт, а для улучшения индексации — загрузить Sitemap.

Использование Google Indexing API

Этот инструмент позволяет отправлять на индексацию новые или обновленные страницы сайта, а также удалять неактуальные ссылки. Суточный лимит отправки составляет 200 адресов.

Регистрация ресурса в поисковую систему «Яндекса»

Это обязательно для индексации сайта. Процесс добавления в «Яндекс Вебмастер» простой и интуитивный. Сервис помогает увеличить трафик и улучшить присутствие ресурса в поисковой выдаче России и стран СНГ.

Читайте также!

Как метатеги ускоряют индексацию сайта в Google

Они дают краткое описание содержимого страниц. Поэтому важно не только использовать метатеги, но и грамотно их составлять. Основные требования к ним включают: уникальность, информативность, соответствие содержанию страницы и наличие ключевых слов. Что касается объёма текста, то он зависит от типа метатега. Для каждого вида установлены свои рекомендации по длине.

Элемент title является метатегом, видимым как пользователям сайта, так и поисковым системам. Он отображается в строке браузера при переходе на страницу. Оптимальная длина такого тега составляет от 80 до 130 символов.

Пример 1. <title>Купить мобильный телефон в Москве — рассрочка и выгодные цены на сотовые телефоны в интернет-магазине «Связной».</title>.

Источник: shutterstock.com

В поисковой выдаче пользователям отображаются сниппеты, которые чаще всего формируются на основе метатега description длиной от 120 до 300 символов.

Пример 2. <meta name="description" content="Интернет-магазин «Связной» предлагает большой выбор мобильных телефонов, которые можно купить в рассрочку без переплат. В каталоге представлены современные модели по выгодным ценам, доступна покупка в кредит и доставка по всей России.">.

Отправившись на проиндексированную страницу, пользователи Google видят заголовок h1. Он составлен правильно, если примерно в 50 символах отражает суть контента и не дублирует title.

Пример 3. <h1>Мобильные телефоны</h1>.

На странице также может размещаться несколько заголовков уровней h2—h6, которые формируют иерархическую структуру содержимого.

Как выявить ошибки индексации сайта в Google

Вся информация о действиях поискового робота на вашем сайте за последние 90 дней отображается в отчёте «Статистика сканирования». Чтобы ознакомиться с ним, необходимо открыть настройки панели Search Console и выбрать соответствующий раздел. В этом отчёте представлены данные:

-

О количестве запросов на сканирование.

-

О среднем времени отклика.

-

О целях сканирования.

-

Об общем объёме загруженных данных.

-

Об ответах сервера при сканировании.

-

О типах файлов.

-

О состоянии хоста.

-

О типах роботов Googlebot.

Статистический отчёт фиксирует найденные ошибки. Достаточно просмотреть их список и устранить перед повторным запросом индексирования в Google.

Источник: shutterstock.com

Если в течение 1-2 недель на диаграмме не наблюдается скачков, это говорит о стабильной скорости сканирования и отсутствии проблем. Небольшие колебания возможны при добавлении новых страниц или удалении части контента.

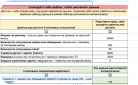

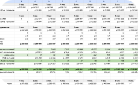

Если показатели заметно нестабильны, следует найти и устранить причину. Наиболее распространённые ошибки и способы их исправления приведены в табличной форме:

| Ситуация, при которой поисковый робот прекращает сканирование сайта | Что нужно сделать |

| Изменение файла robots.txt, а также добавление в него новых или слишком объёмных правил. | Ограничивайте доступ к страницам лишь при необходимости и не блокируйте файлы CSS и JavaScript. |

| Медленная реакция сервера на запросы — в этом случае бот понижает приоритет сканирования. | Проверьте, насколько быстро загружаются страницы сайта. |

| Ошибки в разметке, неподдерживаемый контент или только графические элементы на странице. | Используйте инструмент проверки URL* — он покажет, как Googlebot видит страницы вашего сайта. |

| Ошибки на сервере. | Откройте отчет об ошибках сканирования в инструменте проверки URL, определите и устраните причину неполадок. |

* Инструмент проверки URL — это средство диагностики в Google Search Console, позволяющее имитировать процесс сканирования и отображения страницы. В результате формируется отчёт с данными об индексации, предупреждениями и выявленными ошибками.

Если контент обновляется редко и имеет низкое качество, робот медлит с индексацией страницы, так как Google отдаёт приоритет актуальным и ценным ресурсам.

В системе Search Console можно установить максимальную скорость сканирования. Однако использовать эту настройку постоянно не рекомендуется — лучше управлять доступом к страницам.

Часто задаваемые вопросы об индексации сайта в Google

Поскольку запросы пользователей могут затрагивать разные аспекты вашего проекта, ресурс должен быть полностью проиндексирован Google. Для этого важно обеспечить наличие ссылок на все категории и страницы, которые вы хотите сделать доступными поисковику, и не ограничивать к ним доступ авторизацией.

Влияет ли время загрузки страницы на занесение в базу?

Скорость открытия ресурса — важный фактор ранжирования, так как Google стремится обеспечить пользователям максимально удобный опыт. Быстро работающие сайты имеют больше шансов на успешное занесение в базу и высокие позиции в поисковой выдаче.

Какие распространенные ошибки мешают индексации сайта в Google?

Чтобы ресурс успешно отображался в поисковой выдаче этой системы, необходимо избегать популярных недочётов, препятствующих занесению страниц в базу. Один из наиболее частых — неверно указанные директивы в файле robots.txt. Это может ограничить доступ поисковых систем к сайту. Также важно следить, чтобы все страницы были доступны и корректно связаны между собой — это помогает роботам без затруднений находить и индексировать контент.

Чтобы снизить риск ошибок, препятствующих занесению в базу, придерживайтесь следующих рекомендаций:

-

Проверьте корректность настроек файла robots.txt и убедитесь, что он не блокирует доступ к важным страницам сайта.

-

Применяйте атрибут noindex только для тех ресурсов, которые действительно не должны отображаться в результатах поиска.

-

Убедитесь, что все страницы сайта корректно связаны между собой и не содержат битых ссылок.

-

Оптимизируйте скорость загрузки, поскольку медленная работа ресурса может ухудшить его индексацию.

Эти меры помогут устранить ключевые проблемы, мешающие занесению в базу, и повысят эффективность SEO-продвижения вашего сайта.

Как социальные сигналы влияют на индексацию страницы?

Опосредованно. Несмотря на то, что Google не рассматривает их как прямой фактор ранжирования, активность в социальных сетях помогает повысить узнаваемость и посещаемость ресурса, что косвенно способствует улучшению занесения страниц в базу.

Влияет ли наличие SSL-сертификата на индексацию сайта?

Да, в том числе и на ранжирование. Google учитывает безопасность пользователей как приоритет. Поэтому сайты с защищенным протоколом HTTPS получают преимущество в поисковой выдаче.

Как удалить страницу из индекса Google?

Это можно сделать двумя способами:

-

С помощью файла robots.txt, запретив ее занесение в базу.

-

Через инструмент удаления URL в SearchConsole, что позволяет оперативно исключить страницу из поиска.

Какие тенденции прослеживаются в индексации сайтов в Google?

В 2026 году все больше ресурсов создаются на JavaScript-фреймворках, таких как React и Vue.js. При их индексации важно учитывать особенности работы поисковых систем с динамическим контентом — такие страницы требуют дополнительной обработки, из-за чего процесс занесения в базу может проходить медленнее. Об этом подробнее я уже писал ранее.

В 2026 году Google продолжает уделять приоритет мобильной индексации. Особенно это касается PWA-сайтов, сочетающим удобство веб-страниц и функции приложений.

Google все активнее применяет искусственный интеллект и машинное обучение для оптимизации индексации и ранжирования. Сайты, использующие эти технологии для улучшения пользовательского опыта и создания качественного контента, получают больше шансов на высокие позиции в поисковой выдаче. Об этом говорится и в справке Google.

Инструменты автоматизации давно применяются в издательской сфере для создания полезного контента, а искусственный интеллект открывает новые возможности для его качественной генерации.

Индексация сайта может помочь пользователям Google получить ответы на свои запросы. Для этого кампания проводит сканирование, занесение в базу и ранжирование всех сайтов, включая их отдельные страницы и разделы.

Чтобы ваш сайт гарантированно попал в индекс Google и чаще занимал высокие позиции в выдаче, стоит доверить эту задачу специалистам. При этом важно использовать не только возможности SEO, но и применять комплексный подход с инструментами интернет-маркетинга.