Как закрыть сайт от индексации? Есть разные способы: работа с текстовым файлом robots.txt, через админ-панель WordPress, с помощью HTML-кода. Добиться желаемого также можно, используя специальные сервисы или ограничив возможности ботов-поисковиков на сервере.

Как закрыть сайт от индексации? Есть разные способы: работа с текстовым файлом robots.txt, через админ-панель WordPress, с помощью HTML-кода. Добиться желаемого также можно, используя специальные сервисы или ограничив возможности ботов-поисковиков на сервере.

Зачем это нужно? Запрет индексации сайта управляет видимостью ресурса в поисковых системах. Иногда это крайне важно. Например, чтобы скрыть конфиденциальную информацию, повысить эффективность работы ресурса или провести SEO-оптимизацию.

Зачем это нужно? Запрет индексации сайта управляет видимостью ресурса в поисковых системах. Иногда это крайне важно. Например, чтобы скрыть конфиденциальную информацию, повысить эффективность работы ресурса или провести SEO-оптимизацию.

Из этого материала вы узнаете:

- Что такое индексация сайта

- Зачем закрывать сайт от индексации

- Что желательно скрывать от поисковых систем

- Как закрыть сайт от индексации, работая с файлом robots.txt

- Как закрыть сайт от индексации с помощью HTML-кода

- Как закрыть сайт от индексации другими способами

- Дополнительные советы по запрету индексации

- Каким образом проверить, что сайт закрыт от индексации

- Ошибки при настройке запрета индексации

- Какие страницы нужно индексировать

- Часто задаваемые вопросы о закрытии сайта от индексации

-

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Что такое индексация сайта

Владельцы сайтов всегда стремятся к тому, чтобы их страницы как можно быстрее попадали в топ выдачи. Это напрямую отражается на посещаемости ресурса. Одно из важных условий появления ресурса в топе – процесс индексации. Разберём, как уведомить поисковые системы об обновлениях. И определим, как ускорить включение страниц в их базы.

Индексация – это процесс, при котором поисковые системы сканируют сайт. Затем анализируют его содержимое и сохраняют информацию о страницах в своей базе данных. Благодаря этому алгоритмы лучше понимают, как устроен ресурс и какой контент на нём представлен.

Источник: shutterstock.com

Алгоритмы поисковых систем решают, какое место займет страница в выдаче. Иными словами: чем точнее информация соответствует запросу пользователя, тем выше её позиция. Хорошие места – тем более в топе – привлекают больше посетителей, поднимают узнаваемость сайта.

Процесс появления страницы в поиске проходит несколько этапов:

-

Сканирование. Роботы поисковых систем, называемые краулерами, регулярно просматривают интернет, чтобы находить свежие или обновлённые страницы. Именно во время таких обходов система узнаёт обо всех изменениях на сайте.

-

Анализ и оценка. После обнаружения страницы алгоритмы изучают её содержание, оценивают качество и уникальность информации, авторитетность источника, метатеги, структуру и другие показатели, влияющие на ранжирование.

-

Сохранение. Вся собранная информация помещается в базу поисковой системы. Это даёт быстро обрабатывать запросы пользователей и показывать им наиболее подходящие результаты.

-

Обновление данных. Даже после индексации поисковые системы продолжают отслеживать изменения на сайте. Когда добавляются новые материалы или редактируются старые, краулеры повторно сканируют страницы и обновляют их данные в индексе. Этот процесс происходит автоматически и непрерывно.

Если страницы не проходит сканирование, они не появятся в выдаче поиска. Поэтому важно как можно быстрее включать их в индекс, не теряя трафик и стабильность потока посетителей.

Читайте также!

Зачем закрывать сайт от индексации

Чем быстрее поисковые системы индексируют страницы, тем скорее они появляются в результатах поиска. Поэтому SEO-специалисты стараются всеми способами ускорить этот процесс. Однако бывают ситуации, когда надо сделать обратное – узнать, как полностью закрыть сайт от краулеров или ограничить доступ к отдельным его разделам.

Запрет индексации – важный инструмент управления сайтом. Он помогает контролировать то, какие страницы будут доступны поисковым системам, а что останется невидимым. Грамотно настроенный запрет способен улучшить общие SEO-показатели и защитить внутренние данные. Рассмотрим основные причины, по которым владельцы сайтов применяют этот инструмент:

Оптимизация структуры ресурса для поисковиков

Краулеры индексируют всё, до чего могут добраться. Но далеко не каждая страница полезна для продвижения. К таким относятся материалы-дубли, технические страницы (корзина, вход в личный кабинет), архивы или категории без уникального контента. Если их закрыть от индексации, поисковик сосредоточится на действительно важных разделах сайта.

Интересно: чем логичнее и понятнее структура ресурса, тем выше позиции в выдаче. Поисковые системы вроде Google учитывают это, улучшая опыт пользователя, повышая доверие к сайту.

Защита конфиденциальных данных.

Некоторые разделы сайта могут содержать информацию, не предназначенную для публичного просмотра. Это, например, административные панели, черновые материалы, тестовые страницы.

Если их не закрыть от индексации, существует риск, что они случайно окажутся в результатах поиска. Ограничение доступа для краулеров помогает избежать подобных утечек.

Рациональное использование бюджета индексации.

Крупные сайты с тысячами страниц сталкиваются с особым ограничением. Это бюджет индексации. Поисковик не может бесконечно сканировать весь ресурс, поэтому количество проанализированных страниц ограничено.

Если исключить из индексации второстепенные или повторяющиеся, можно направить краулеры на действительно важные разделы. Так, в интернет-магазинах закрывают фильтры, страницы сортировки. И карточка товара индексируется быстрее.

Предотвращение проблем с неуникальным контентом.

Поисковым системам важна оригинальность информации. Если текст на странице дублирует уже существующие материалы, преимущество в выдаче получает источник. Поэтому копии или тексты «заемные» лучше закрыть от индексации, чтобы не снижать рейтинг сайта и позиции в поиске.

Что желательно скрывать от поисковых систем

В первую очередь стоит закрывать индексацию сайтов, которые находятся в разработке. Это позволит предотвратить попадание в поисковые базы неполных, неверных данных. Если ресурс уже работает, но вы не уверены, какой контент лучше исключить из выдачи, ознакомьтесь с практическими рекомендациями ниже:

-

Персональные данные пользователей. Любая информация, позволяющая идентифицировать человека, должна быть надежно защищена. Это касается контактных данных, платежной информации и других личных сведений, которые нельзя допускать в индекс поисковых систем.

-

Страницы в разработке. Разделы, которые находятся в процессе создания или тестирования, не должны появляться в поиске. Рекомендуется индексировать только те, которые уже оптимизированы и содержат уникальный материал. Настроить запрет можно через robots.txt.

-

Копии сайта. При создании дубля ресурса важно правильно указать оригинальный через 301 редирект. Это позволит сохранить рейтинг исходного и предотвратить путаницу поисковых систем. Применение копии как основного ресурса не рекомендуется: это обнулит возраст домена и его репутацию.

-

Страницы для печати. Многие сайты создают отдельные версии разделов для печати. Они часто дублируют основной контент, и роботы могут считать их приоритетными. Чтобы избежать этого, индексацию таких страниц нужно отключать.

-

Интерактивные и вспомогательные элементы. Личный кабинет, корзина покупателя, регистрационные и контактные формы – важные части сайта, но бесполезные для поисковых систем. Эти разделы лучше закрыть от индексации.

-

Служебные страницы. Разделы, используемые администраторами, такие как панели управления или внутренние формы, не несут ценности для обычного пользователя. Их также следует исключать из индексации.

-

Результаты поиска по сайту. Страницы с итогами внутреннего поиска полезны для посетителей, но не нужны поисковикам, так как содержат дублирующийся контент.

-

Сортировочные разделы. Контент таких страниц часто повторяет основной материал. А это краулеры воспринимают как дублирование. Для избежания проблем лучше закрывать эти разделы от индексации.

-

Документы PDF и другие файлы. На многих сайтах публикуются различные материалы, связанные с содержимым конкретных страниц. Среди них могут быть и важные документы – политика конфиденциальности, инструкции и др.

Стоит регулярно проверять поисковую выдачу: если PDF-файлы появляются в ней выше, чем основные страницы с похожими запросами, их желательно скрыть. Это позволит пользователям быстрее находить нужную информацию на самом сайте.

Ограничить индексацию PDF-документов и других типов файлов можно через файл robots.txt, указав соответствующие директивы.

-

Пагинация на сайте. Пагинация – неотъемлемая часть любого крупного ресурса. Чтобы понять её значение, можно представить себе старинные свитки: текст приходилось читать, постепенно разворачивая длинное полотно. Это было неудобно и затрудняло поиск нужных фрагментов. Аналогично, без пагинации пользователю сложно ориентироваться в больших объемах данных или находить нужный товар.

Пагинация помогает разбивать контент на отдельные страницы, делая взаимодействие с сайтом удобным и структурированным. Отключать индексацию таких разделов не рекомендуется. Достаточно правильно настроить атрибуты rel="canonical", rel="prev" и rel="next", чтобы краулеры корректно воспринимали взаимосвязь страниц.

В Google Search Console можно дополнительно указать параметры, отвечающие за разбиение контента в разделе «Параметры URL». При этом следует закрывать от индексации такие разделы, как лендинги для контекстной рекламы, страницы с внутренними результатами поиска и с UTM-метками.

Источник: shutterstock.com

Существует несколько способов ограничить индексацию: настройка директив в файле robots.txt; применение HTML-кода; коррекция на уровне сервера; работа через админ-панель WordPress; применение специализированных сервисов. Далее рассмотрим каждый из них подробнее.

Как закрыть сайт от индексации, работая с файлом robots.txt

Файл robots.txt – это текстовый документ, к которому поисковые системы обращаются в первую очередь. Он информирует роботов, какие страницы и файлы можно сканировать, а какие нет. Основная цель такого файла – уменьшить объем запросов к сайту и снизить нагрузку на сервер.

Файл должен соответствовать следующим требованиям:

-

Имя файла указывается в нижнем регистре.

-

Формат его: .txt.

-

Размер файла не должен превышать 500 Кб.

-

Размещается он в корневой директории сайта.

-

Доступен по адресу URL/robots.txt, при этом сервер должен возвращать код 200 при обращении.

Перед редактированием файла важно учитывать несколько ограничений:

-

Директивы robots.txt поддерживаются не всеми поисковыми системами. Большинство роботов соблюдают указанные правила, но полностью полагаться на них нельзя. Чтобы надёжно скрыть страницы, рекомендуется применять дополнительные методы.

-

Синтаксис директив может трактоваться по-разному в зависимости от поисковой системы. Поэтому перед внесением изменений важно ознакомиться с правилами и рекомендациями конкретного краулера, чтобы корректно настроить ограничения и избежать ошибок.

-

Запрещённые страницы могут попасть в индекс, если на них ссылаются другие ресурсы. Особенно это касается Google: несмотря на запрет, он может обнаружить URL на сторонних сайтах и добавить их в выдачу. В этом случае проблему решают защита файлов паролем или использование метатега noindex.

Источник: shutterstock.com

Основные параметры файла robots.txt:

-

User-agent указывает конкретного поискового робота, к которому применяются правила.

-

Disallow запрещает сканирование указанных страниц или разделов.

-

Allow разрешает обход разделов, даже если для родительской папки задан запрет.

-

Sitemap сообщает расположение файла sitemap.xml, позволяя роботу быстро найти карту сайта для индексирования.

-

Clean-param исключает из анализа страницы с динамическими параметрами, которые могут выдавать одинаковое содержимое при разных URL.

-

Crawl-delay – параметр, который помогает снизить нагрузку на сервер, если краулеры посещают сайт слишком часто. Он задаёт интервал между обращениями бота к страницам. Эта директива особенно полезна для крупных ресурсов с большим количеством разделов.

Рассмотрим, как закрыть весь сайт от индексации, а также отдельные страницы. Все пути в примерах условные.

Читайте также!

Работа с файлом robots.txt

Файл находится в корневой директории сайта. Если его нет, создайте новый через текстовый редактор и разместите в нужной папке.

Для сайтов на «Битрикс» robots.txt формируется автоматически. Изменить его можно через панель администратора: откройте раздел «Маркетинг», выберите «Поисковая оптимизация» и нажмите «Настройка robots.txt».

В файле вы увидите строки:

User-agent: *

Disallow: /

Удалите остальные правила, и краулеры перестанут сканировать страницы, добавлять их в индекс.

Это один из самых простых и эффективных методов.

Запрет индексации для Яндекс

User-agent: Yandex

Disallow: /

Проверить корректность настроек можно через Яндекс.Вебмастер. Загрузите robots.txt и перейдите по ссылке https://webmaster.yandex.ru/tools/robotstxt/. В поле для проверки вставьте несколько URL страниц сайта и нажмите «Проверить». Если закрытие прошло успешно, напротив ссылок будет написано «Запрещено правилом /*?*».

Запрет индексации для Google

User-agent: Googlebot

Disallow: /

В Google Search Console убедитесь: напротив закрытых страниц есть «Заблокировано по строке».

Ограничение для других поисковых систем

Каждая из них использует своих роботов с уникальными именами. Их можно добавить в robots.txt с соответствующими командами. Примеры ботов:

-

Slurp (Yahoo).

-

SputnikBot («Спутник»).

-

MSNBot (Microsoft Network Search).

Закрытие отдельных страниц для ботов

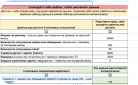

Чтобы скрыть служебные разделы, админ-панель, корзину, старые акции и т. д., используйте директиву Disallow. Примеры:

| Конкретная страница |

User-agent: * Disallow: /contact.html |

| Один раздел |

User-agent: * Disallow: /catalog/ |

| Веб-ресурс полностью (кроме конкретного раздела) |

User-agent: * Disallow: / Allow: /catalog |

| Раздел полностью (кроме подраздела) |

User-agent: * Disallow: /product Allow: /product/auto |

| Внутренний поиск |

User-agent: * Disallow: /search |

| Админ-панель |

User-agent: * Disallow: /admin |

Увеличим продажи вашего бизнеса с помощью комплексного продвижения сайта. Наша команда экспертов разработает для вас индивидуальную стратегию, которая позволит в разы увеличить трафик, количество заявок и лидов, снизить стоимость привлечения клиентов и создать стабильный поток новых покупателей.

Закрытие других данных для поисковиков

С помощью robots.txt можно ограничить индексацию файлов, папок, скриптов, UTM-меток и изображений. Примеры:

| Файлы определенного ипа (с расширением .ipa) |

User-agent: * Disallow: /*.jpg |

| Папки |

User-agent: * Disallow: /images/ |

| Папка полностью (кроме одного файла) |

User-agent: * Disallow: /images/ Allow: file.jpg |

| Скрипты |

User-agent: * Disallow: /plugins/*.js |

| UTM-метки |

User-agent: * Disallow: *utm= |

| UTM-метки для ботов Яндекс | Clean-Param: utm_source&utm_medium&utm_campaign |

Запрет индексации изображений

Чтобы исключить картинки из выдачи, используйте директивы:

User-Agent: *

Disallow: *.png

Disallow: *.jpg

Disallow: *.gif

Запрет индексации поддомена

Они обычно имеют отдельный robots.txt в корневой директории. Для запрета добавьте:

User-agent: *

Disallow: /

Как закрыть сайт от индексации с помощью HTML-кода

Если есть необходимость ограничить индексирование отдельных страниц сайта, добавьте в блок <head> HTML-кода метатег robots с указанием директив noindex, nofollow или none.

Источник: shutterstock.com

Значение этих директив:

-

noindex – запрещает роботу добавлять страницу в индекс. Раздел с этой директивой не будет появляться в поисковой выдаче.

-

nofollow – блокирует переход робота по ссылкам на странице.

-

none – сочетает оба ограничения: раздел не индексируется, а ссылки по нему робот не обрабатывает.

Например, чтобы скрыть определённый текст на странице и предотвратить его появление в поисковой выдаче, пропишите:

<meta name="yandexbot" content="noindex, nofollow">.

Нужно не показывать целый раздел сайта – добавьте директиву noindex на каждой его странице.

Как скрыть часть текста от индексации

Чтобы запретить сканирование только определённого блока текста на странице, используйте элемент <noindex> в HTML.

Так это будет выглядеть: <noindex>текст, который нужно скрыть от индексирования</noindex>.

Также можно использовать директиву <noscript>: <noscript>текст, который нужно скрыть от краулеров</noscript>.

Она позволяет запретить роботам индексировать этот фрагмент. И, одновременно, спрятать его от пользователей, если их браузер поддерживает JavaScript.

Как запретить сканирование ссылок

Если страницу необходимо оставить в индексе, но нужно ограничить переход робота по ссылкам, используйте директиву nofollow. Эта директива вставляется непосредственно в HTML-разметку рядом со ссылкой.

Источник: shutterstock.com

Как запретить индексацию через авторизацию

Для главной страницы сайта использование этого метода часто эффективнее, чем блокировка через robots.txt. Даже если последний запрещает индексацию, внешние ссылки на страницу могут позволить роботу добавить её в индекс.

Чтобы закрыть ее для конкретного краулера, укажите атрибут name – yandex для Яндекса и googlebot для Google. Пример запрета индексации страницы вместе со ссылками для Гугл:

<html>

<head>

<meta name="googlebot" content="noindex, nofollow" />

</head>

<body>...</body>

</html>

Как закрыть сайт от индексации другими способами

С помощью специализированных сервисов

Чтобы ограничить индексирование конкретной страницы, необходимо открыть Google Search Console. Далее перейти в раздел «Индекс Google» и удалить нужный URL. Обратите внимание: запрет на индексацию вступает в силу не сразу, а через определённое время.

Аналогично этот процесс можно выполнить в Яндекс.Вебмастер. Сначала убедитесь, что файл robots.txt настроен корректно. Откройте «Результаты анализа robots.txt». В этом разделе показан список директив, которые поисковые системы учитывают при обходе сайта.

Источник: shutterstock.com

Чтобы проверить разрешение индексирования отдельных страниц, вставьте их адреса в поле «Список URL». Можно проконтролировать изменения robots.txt и при необходимости скачать нужную версию файла.

На стороне сервера

Если поисковые системы не соблюдают запрет на индексирование, можно заблокировать доступ поисковых ботов на сервере. Для этого откройте корневую директорию сайта и найдите файл .htaccess, после чего добавьте следующий код:

-

Для Google: SetEnvIfNoCase User-Agent "^Googlebot" search_bot.

-

Для Яндекс: SetEnvIfNoCase User-Agent "^Yandex" search_bot.

Через админ-панель WordPress

Если вы хотите узнать, как закрыть сайт от индексации WordPress, сделать это можно через административную панель. Перейдите в раздел «Настройки», откройте вкладку «Чтение» и отметьте галочкой опцию «Попросить поисковые системы не индексировать сайт». После сохранения изменений CMS автоматически обновит файл robots.txt.

Чтобы закрыть от индексации отдельные страницы, установите плагин Yoast SEO, откройте нужную для редактирования, прокрутите до блока «Дополнительно» и выберите значение «Нет» для индексирования.

Читайте также!

Дополнительные рекомендации по ограничению индексации

Проводите предварительный анализ сайта

Перед внесением изменений используйте инструменты, такие как Screaming Frog, чтобы выявить страницы с дублированным содержимым или с низкой ценностью для поисковых систем.

Дополнительные инструменты: еще можно применять Sitebulb или Ahrefs для более детальной проверки и анализа ресурса.

Регулярно обновляйте файл robots.txt

Когда на сайте появляются разделы или страницы, необходимо проверить, нужно ли их индексировать, и при необходимости внести корректировки в файл robots.txt.

Контролируйте результаты

После настройки обязательно проверяйте, что запрещённые страницы действительно не сканируются, используя Google Search Console и другие инструменты проверки индексации.

Источник: shutterstock.com

Рекомендуется проводить полноценный аудит индексации сайта хотя бы раз в квартал, чтобы убедиться, что все настройки корректны и лишние страницы не попадают в поисковую выдачу.

Как проверить, что сайт закрыт от индексации

Существует несколько способов убедиться, что ресурс или отдельные страницы не попадают в поисковую выдачу:

-

Проверка файла robots.txt. Откройте адрес сайта с добавлением /robots.txt и изучите правила. Там указано, какие его страницы, блоки разрешено сканировать краулерам, а какие закрыты.

-

Проверка метатега noindex. Чтобы убедиться, что раздел закрыт через HTML, откройте его в браузере, нажмите Ctrl+U (Просмотр кода страницы). Найдите строку <meta name="robots" content="noindex">. Этот тег сигнализирует поисковикам, что страницу индексировать нельзя.

-

Использование Google Search Console. Сначала необходимо подтвердить права на сайт. Затем откройте Google Search Console, перейдите в раздел «Проверка URL» и введите адрес страницы. Если сервис выдаёт сообщение «Заблокировано robots.txt» или «Исключено по метатегу noindex», значит, раздел не индексируется.

-

Использование Яндекс.Вебмастер. Авторизуйтесь в сервисе, откройте меню «Индексирование» и выберите инструмент «Проверка ответа сервера». Вставьте URL страницы в поле и запустите проверку. Если раздел закрыт от роботов, сервис уведомит об этом.

-

Проверка индекса поисковых систем. В строке поиска Google или Яндекс введите запрос вида site:example.com. Если нужные страницы не отображаются в выдаче, значит, сайт или разделы его закрыты от индексации.

Ошибки при настройке запрета индексации

-

Блокировка статики: JS и CSS. Веб-мастера иногда по ошибке запрещают индексацию папок с CSS и JavaScript, считая, что поисковым системам эти файлы не нужны. Но современные роботы анализируют визуальное отображение и функциональность сайта. Если скрипты или стили недоступны, Google может понизить позиции ресурса в выдаче за некорректную верстку.

-

Полная блокировка сайта. Опасная ошибка – использование директивы Disallow: / в секции User-agent: *. Она запрещает всем поисковым ботам доступ к любым страницам сайта.

-

Неправильная настройка для разных поисковых систем. Файл robots.txt может содержать инструкции для отдельных ботов. Без персонализации можно случайно закрыть важные разделы не только для Google, но и для Яндекс, Bing или других поисковиков.

-

Старые директивы остаются в силе. После редизайна или переноса сайта прежние ограничения могут устареть. Если не обновлять robots.txt, новые разделы могут быть закрыты для индексации, а приватные данные останутся доступными.

-

Отсутствие тестирования и валидации. Часто веб-мастера создают файл вручную, не проверяя его корректность. Даже если он выглядит правильно, может работать иначе и допускать ошибки.

-

Переусердствование с директивами. Иногда пытаются закрыть слишком много страниц: поиск, параметры, фильтры, корзины и т. д. Это мешает краулерам понимать структуру сайта и снижает качество ранжирования.

-

Противоречивые инструкции. Например, если robots.txt запрещает доступ к странице, но на ней установлен тег index, поисковые системы могут игнорировать одно из правил. Решение – проверять сайт инструментами анализа, чтобы исключить конфликты в настройках.

-

Использование запрета вместо удаления. Важно помнить, что недопуск к индексации не исключает страницу из поисковой выдачи.

Какие страницы стоит оставлять для индексации

Иногда ограничение доступа для поисковых систем превращается в проблему: владельцы сайтов откладывают настройку, случайно блокируют ключевой контент. Чтобы избежать таких ошибок, важно понимать, какие разделы должны оставаться открытыми при отладке индексации.

Иногда на сайте появляются дублирующие страницы. Обычно это связано с созданием повторяющихся категорий, привязкой одного товара к нескольким разделам или доступом к информации через разные ссылки. Не стоит сразу отключать индексацию таких страниц: сначала проанализируйте, какой трафик они приносят.

Источник: shutterstock.com

После анализа рекомендуется настроить 301-редиректы с непопулярных страниц на те, которые привлекают больше посетителей. А которые не приносят результата, надо удалить.

Страницы со смарт-фильтрами полезны: помогают увеличить трафик за счет низкочастотных запросов. Важно корректно настроить метатеги, обрабатывать пустые страницы с кодом 404. Надо обеспечить и наличие карты сайта.

Сохранение индексации таких страниц значительно повышает видимость ресурса в поисковой выдаче, особенно если ранее оптимизация не проводилась.

Часто задаваемые вопросы по закрытию сайта от индексации

Что важно при использовании метатега для запрета индексации?

Чтобы закрыть сайт целиком, необходимо добавить тег на каждую его страницу. Если они формируются динамически, достаточно прописать команду в шапке ресурса.

Как не допустить ошибок при закрытии сайта от индексации?

Рекомендуется заранее составить план этой работы, регулярно проверять настройки и их влияние на попадание в индекс. Используйте инструменты веб-мастеров, такие как Google Search Console или Яндекс.Вебмастер, чтобы отслеживать ошибки. При сомнениях лучше обратиться к специалисту или поддержке хостинга.

Зачем проверять статус страницы после того, как она была закрыта от индексации?

Даже после правильной настройки закрытия отдельных разделов или всего сайта, поисковые системы могут не учитывать директивы полностью. В итоге страница может попасть в индекс.

Настройка индексации – это сложный процесс. Он требует не только обеспечения сканирования целевых страниц, но и грамотного сокрытия части ресурса от роботов. Существует несколько способов решения этой задачи, выбор которых зависит от структуры сайта и поставленных целей.

Источник изображения на шапке: shutterstock.com