В статье рассказывается:

- Какие принципы лежали в основе работы первых поисковых систем

- Как работают современные поисковые системы

- На чем основывается принцип работы любой поисковой системы

- О принципах работы всех поисковых систем простыми словами

- Формулы для принципов работы поисковых системы

- Принцип работы информационно-поисковых систем: критерии ранжирования

- Принцип работы поисковой системы Яндекс

Перед тем как заниматься SEO-продвижением сайта, важно изучить принципы работы поисковых систем, чтобы на выходе достичь желаемых результатов. Эти знания будут полезны для разработки индивидуальной стратегии оптимизации интернет-ресурса под определенные ключевые слова и помогут вывести его в ТОП поисковой выдачи.

Какие принципы лежали в основе работы первых поисковых систем

На заре появления Интернета лишь небольшое количество пользователей имело возможность к нему подключиться. Объем доступной информации тоже был невелик. В Интернете в то время работали в основном сотрудники научно-исследовательских организаций. Поиск информации в Сети был не так популярен, как в настоящее время.

Первой попытку организовать доступ к электронным данным через Интернет предприняла поисковая система Yahoo!, появившаяся в 1994 году.

Разработчики компании создали открытый каталог сайтов, ссылки на которые были сгруппированы по соответствующей тематике. С ростом количества ресурсов в базе возникла необходимость по добавлению опции поиска по каталогу. Это еще не была поисковая система в привычном для нас виде, т. к. она искала информацию по внутренней базе сайтов, а не по всем существующим интернет-ресурсам.

Подобные каталоги ссылок пользовались раньше большой популярностью, но сегодня потеряли свою актуальность, т. к. количество сайтов постоянно увеличивается. Например, в самый большой из современных каталогов в Интернете DMOZ (другое название — Open Directory Project) входит около 5 млн сайтов, при этом в базе поисковой системы Google содержится более 8 млрд ссылок.

В 1994 году появилась первая настоящая поисковая система WebCrawler.

В 1995 году были созданы еще два поисковика: Lycos и AltaVista. Последняя поисковая система долгое время занимала лидирующие позиции в сфере онлайн-поиска информации.

В 1997 году студенты Стэнфордского университета Сергей Брин и Ларри Пейдж разработали поисковую систему Google, которая стала самой востребованной в мире.

Так же в 1997 году начала работу поисковая система Яндекс, пользующаяся популярностью в Рунете.

Как работают современные поисковые системы

Если вы не программист и ваша профессия никак не связана с ИТ, зачем вам разбираться в принципах работы поисковиков? Дело в том, что через поисковые системы на сайт компании приходит так называемый органический трафик — это пользователи, которые сами нашли ваш интернет-ресурс по ключевым словам в Яндексе или Гугле. Органический трафик — это лакомый кусок пирога (целевой аудитории). Чем выше его уровень, тем больше конверсия и продажи сайта.

Для того чтобы пользователи могли легко найти ваш интернет-ресурс, важно наполнить его правильным контентом. Поисковые системы в зависимости от качества контента ранжируют сайты, что влияет на их место в поисковой выдаче. Получается, зная, как поисковики индексируют интернет-ресурсы, можно оптимизировать их содержание и продвинуть в ТОП.

С другой стороны, с помощью поисковых систем можно анализировать действия пользователей. Изучать, что они ищут, какая информация, товары или услуги для них сейчас актуальны. Если по статистике Яндекса можно сформировать картину действий пользователей Рунета, то по данным Google — всемирного Интернета.

Основным понятием, с которым работает любая поисковая система, является поисковый индекс — определенная структура данных, отражающая информацию о документах и расположении в них ключевых слов.

Принципы работы многих поисковых систем очень похожи. Основное отличие заключается в подходе к ранжированию сайтов (способу упорядочивания ресурсов в поисковой выдаче).

Каждый день огромное количество пользователей ищет различную информацию с помощью поисковых систем.

Например, популярны такие поисковые запросы:

«Реферат написать»:

«Купить»:

Для увеличения скорости работы поисковой системы архитектура поиска состоит из двух элементов:

-

базовый поиск;

-

метапоиск.

Базовый поиск — программа, которая ищет в рамках своей части индекса и выдает пользователю все ссылки, отвечающие поисковому запросу.

Метапоиск — программа, которая при обработке запроса определяет местонахождение пользователя и выдает готовую поисковую выдачу, если ключевое слово популярное, если же подобных запросов раньше не было, то в работу подключается базовый поиск, который методом машинного обучения обрабатывает имеющиеся в базе ссылки и выдает их список пользователю.

Поисковая система одновременно анализирует пользователя и непосредственно поисковый запрос по следующим критериям:

-

длина;

-

четкость;

-

популярность;

-

конкурентность;

-

синтаксис;

-

география.

Выделяют следующие типы запроса:

-

навигационный;

-

информационный;

-

транзакционный;

-

мультимедийный;

-

общий;

-

служебный.

После того как поисковый запрос разобран по параметрам и классифицирован по одному из перечисленных типов, поисковая система подбирает функцию ранжирования.

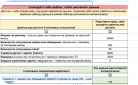

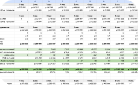

Поисковики не разглашают информацию о ранжировании поисковых запросов, поэтому пример на рисунке выше — лишь предположения SEO-специалистов.

Знание типов запросов необходимо для выбора стратегии продвижения сайтов. Например, если пользователь вводит общий запрос, то поисковик выдаст ему ссылки разного типа (коммерческие, мультимедийные, информационные и т. д.). Если вы при этом продвигаете свой коммерческий сайт по общему запросу и хотите вывести его в десятку поисковой выдачи, то с высокой вероятностью не попадете в ТОП, а только в число мест для коммерческих интернет-ресурсов, определенное формулой ранжирования поисковой системы. Получается, продвигать сайт на первые строчки в поисковой выдаче по общим поисковым запросам гораздо сложнее, чем по другим типам.

Поисковая система Яндекс с 2009 года использует машинное обучение Матрикснет — особый алгоритм, который ранжирует сайты по определенным запросам.

Основной принцип работы этого алгоритма следующий: отдел асессоров собирает первичную информацию для оценки эффективности формулы ранжирования. Сотрудники этого отдела на основе экспериментальной формулы проводят оценку выборки интернет-ресурсов по определенным параметрам:

-

Витальный — официальный интернет-ресурс компании или нет. Это может быть сайт, страница в социальной сети или информация на авторитетных ресурсах.

-

Полезный (оценка 5) — сайт, предоставляющий всю необходимую информацию по поисковому запросу. Например, пользователь вводит в поисковой строке «баннерная ткань».

Для того чтобы алгоритм мог оценить ресурс как полезный, на нем должна быть следующая информация:

-

что такое баннерная ткань;

-

технические характеристики;

-

фотографии;

-

виды;

-

прайс-лист;

-

дополнительные данные.

Примеры запроса, которые попадают в ТОП поисковой выдачи:

-

-

Релевантный+ (оценка 4) — эта оценка говорит о том, что информация на сайте соответствует поисковому запросу.

-

Релевантный- (оценка 3) — сайт не полностью соответствует поисковому запросу. Например, если на запрос «стражи галактики сеансы» поисковик показывает ссылки на страницы о фильме, но без расписания сеансов или с неактуальным расписанием.

-

Нерелевантный (оценка 2) — сайт не отвечает поисковому запросу. Например: пользователь ищет информацию по одному хостелу, а поисковая система выдает ему страницу совершенно другого.

Для продвижения сайта по общим или информационным поисковым запросам нужно оптимизировать его содержимое таким образом, чтобы поисковик в ходе ранжирования присвоил оценку «полезный».

На чем основывается принцип работы любой поисковой системы

Поисковая система традиционно позволяет:

-

Дать пользователю правильный ответ на его поисковый запрос и таким образом полностью его удовлетворить, чтобы он не обратился за помощью к другой поисковой системе. Для этого в первую десятку поисковой выдачи должны попадать ссылки на сайты, которые максимально отвечают запросу пользователя.

-

Обеспечить монетизацию трафика. В первых строках поисковой выдачи показывать ссылки на коммерческие сайты, например разместившие контекстную рекламу.

Принципы работы поисковой системы строятся на взаимодействии трех основных элементов. Сначала осуществляется поиск по введенным пользователем ключевым словам или фразам, затем в процессе математического формирования происходит группировка результатов по ссылкам и сайтам. И в завершение для считывания информации с отобранных интернет-ресурсов используется поисковый робот или другие инструменты.

Основные поисковые роботы, пользующиеся популярностью в настоящее время

-

Web crawler (другое название — «обходчик»)

Программа, «гуляющая» по Сети. Она заходит только на те сайты, на которых находит хотя бы минимальное соответствие тому, что задано в поисковом запросе. Работа начинается со списка адресов из доступных баз данных или индекса.

-

Индекс

«Обходчик» передает всю полученную информацию поисковому индексу. Таким образом, у последнего есть всегда актуальная информация о найденных сайтах и веб-страницах. Если на ресурс или страницу загружаются обновления, то эта информация актуализируется и у индекса.

-

Поисковая система (сервер)

Зто специальное программное обеспечение, основной функцией которого является анализ информации, собранной в поисковом индексе. Алгоритм поисковика работает по принципу поддержки только итоговых результатов поиска по интернет-ресурсам. Поисковая система сама решает, каким образом распределить страницы в поисковой выдаче.

Любая поисковая система нацелена на предоставление пользователю самых актуальных и полезных сайтов, соответствующих поисковому запросу. С технической точки зрения это называется «релевантность ответа». Например, для продвижения интернет-магазина большое значение имеет соответствие размещенного на нем контента запросам пользователей. Оптимизация сайта позволит повысить его позицию в поисковой выдаче.

Рассмотрим основные характеристики поисковых систем Интернета и принципы их работы.

Полнота

Ключевая характеристика поисковой системы. Рассчитывается как отношение количества документов, отобранных по запросу пользователя, к суммарному числу документов в Сети, подходящих под поисковый запрос.

Например, в Интернете есть 200 страниц, где используется фраза «как выбрать холодильник», поисковая система по этому запросу выдала только 40, следовательно, полнота поиска составляет 0,2. Чем выше показатель полноты, тем вероятнее, что пользователь найдет то, что искал (при условии, что эта информация есть в Сети).

Точность

Вторая, но не менее важная характеристика работы поисковой системы. Показывает соответствие найденных документов поисковому запросу пользователя.

Допустим, в нашем примере по запросу «как выбрать холодильник» есть 200 страниц, в 80 из них есть фраза «как выбрать холодильник», а в остальных просто есть отдельные слова (например, «как эргономично разместить кухонный гарнитур и выбрать место под холодильник»).

В этом случае точность поиска будет равна: 80 / 200 = 0,4. Чем выше точность поиска, тем быстрее пользователь найдет то, что ему нужно, и тем меньше разного «спама» он встретит по пути.

Актуальность

Еще один важный параметр работы поисковой системы. Он отражает время, прошедшее между публикацией материала в Интернете и его попаданием в индексную базу поисковика.

Например, через несколько часов после крушения самолета большое количество пользователей искало в Сети информацию о происшествии. Несмотря на то, что прошло мало времени с публикации первых сообщений на эту тему, поисковые системы успели их проиндексировать и пользователи смогли узнать подробности катастрофы.

Скорость

Скорость работы поисковой системы напрямую зависит от ее устойчивости к нагрузкам. Например, по данным ООО «Рамблер Интернет Холдинг», ежедневно поисковик обрабатывает около 60 поисковых запросов в секунду.

Такая скорость обеспечивается сокращенным временем обработки каждого отдельного обращения пользователя.

Наглядность представления результатов

Этот параметр отвечает за удобство работы поисковой системой для пользователя. Поисковик может найти по поисковому запросу сотни и даже тысячи сайтов. Если запрос составлен не совсем корректно, то даже на первую страницу выдачи могут попасть страницы, не совсем соответствующие тому, что хочет найти пользователь.

В результате человек вынужден фильтровать информацию в рамках полученного списка. Отдельные элементы страницы выдачи поисковика помогают ориентироваться в результатах поиска. Подробные пояснения по странице результатов поиска, например у «Яндекса», можно посмотреть по ссылке .

Для того чтобы сайт с высокой вероятностью оказался на первой странице поисковой выдачи, нужно:

-

Применять анкорные ссылки, которые перенаправляют пользователей с тематических интернет-площадок на сайт вашей компании. Это повышает видимость интернет-ресурса для поисковой системы, т. к. в выдачу может попасть не только текст со ссылкой на сайт, но и его URL.

-

Использовать метатеги вместе с правильно подобранными ключевыми словами. Это позволит сделать краткое содержание сайта более уникальным и эффективным.

-

Применять заголовок Title.

-

Правильно составить семантическое ядро сайта. Недостаточно распределить ключевые слова по контенту сайта, важно сделать это аккуратно и ненавязчиво. Не стоит вставлять ключевики в каждом предложении. Поисковая система может оценить это как спам.

-

Использовать URL сайта (адрес его нахождения в Сети). Грамотное написание адреса влияет на его ранжирование поисковой системой.

О принципах работы всех поисковых систем простыми словами

Поисковая система — специальная программа с удобным веб-интерфейсом, с помощью которой пользователи могут быстро и легко искать необходимую информацию в Сети. Рассмотрим принцип работы любого поисковика без углубления в детали и техническую терминологию.

Для того чтобы поисковая система могла выдавать пользователю список ссылок страниц, на которых содержится информация по поисковому запросу, она должна знать содержание контента всех разделов каждого сайта. Как поисковик собирает эти данные?

Интернет — это особая сеть, состоящая из отдельных страниц, ссылающихся друг на друга. Поисковой системе не обязательно заходить на каждую из них, достаточно иметь информацию о сайтах и каталогах с самыми высокими рейтингами, чтобы аккумулировать данные о страницах для последующего закачивания.

Поисковик, по сути, создает предметный указатель, в котором адреса всех интернет-страниц сгруппированы особым образом. Если в Сети появился новый сайт, на который не ссылаются другие ресурсы, то поисковой системе будет трудно его найти, чтобы проиндексировать и занести в свою базу.

После того как поисковик сформировал список страниц, начинается процесс индексации (работа по скачиванию с них всех данных). С помощью специально созданных для этих целей программ поисковая система записывает новую информацию или перезаписывает старую, удаляя неактуальные сведения. Работа по индексации сайтов в Интернете идет непрерывно.

Программы собирают данные во временное хранилище. Там они накапливаются до определенного количества, после чего запускается процесс апдейта, основной принцип работы которого — актуализация информации в основной базе поисковой системы.

В индексе поисковиков находится огромное количество страниц. Когда пользователь вводит запрос в поисковой строке, поисковая система отбирает релевантные ссылки из своей базы. Другими словами, она составляет список сайтов, на страницах которых упоминаются ключевые слова, заданные пользователем.

Так как внутренняя база поисковой системы огромна, то поисковая выдача может содержать десятки страниц. Как же поисковик их ранжирует? По какому принципу определяет, какие страницы показывать пользователю в первую очередь? Все страницы сортируются по соответствию контента поисковому запросу. Чем выше показатель полноты содержащейся на странице информации, тем ближе будет страница к началу списка.

В настоящее время поисковые системы применяют машинное обучение для ранжирования страниц в поисковой выдаче. Принцип действия этого процесса можно рассмотреть на абстрактном примере.

Допустим, нам нужно обучить робота отличать спелые яблоки от неспелых. Программа для определения свойств фрукта ориентируется на его характеристики:

-

цвет;

-

размер;

-

твердость;

-

содержание сахара;

-

содержание кислоты.

Для анализа роботу дают два яблока: незрелое и готовое. Он их сравнивает. Затем проводим обучение машины — показываем, какие характеристики яблока являются положительными, какие отрицательными. Объясняем, по какому набору параметров фрукт можно отнести к спелому или нет.

Таким образом, у нас есть алгоритм для анализа яблок, с помощью которого робот может их самостоятельно сортировать. Теперь можно давать не два фрукта, а гораздо больше, машина будет сама их делить на спелые и незрелые.

Подобный принцип работы заложен в работе поисковой системы. Есть специалисты, занимающиеся обучением машин алгоритмам сортировки контента. Сначала они самостоятельно анализируют страницы, попавшие в выдачу по поисковому запросу, разделяя их на релевантные и нерелевантные. Затем обучают робота сортировать страницы.

Релевантность страниц — это показатель в виде дробного числа. Каждой странице присваивается свое значение релевантности. Потом все ресурсы сортируются в порядке убывания этого показателя. В ТОП поисковой выдачи попадают самые релевантные сайты.

Помимо основного алгоритма сортировки, поисковые системы используют различные дополнительные, которые также могут влиять на поисковые результаты. Например, с их помощью можно фильтровать недобросовестные сайты, использующие разные «серые» схемы для продвижения.

Формулы для принципов работы поисковых системы

Каждая поисковая система применяет свои уникальные алгоритмы поиска и ранжирования страниц и сайтов, но при этом принципы работы у всех поисковиков одинаковые.

Процесс поиска информации, соответствующей запросу пользователя, состоит из нескольких этапов: сбора данных в Интернете, индексации сайтов, поиска по ключевым словам и ранжирования полученных результатов. Рассмотрим подробнее каждый этап.

-

Сбор данных

После того как сайт готов, нужно сделать так, чтобы роботы поисковой системы узнали о его появлении. Можно разместить внешние ссылки на ваш интернет-ресурс или воспользоваться другими способами. Как только робот зайдет на сайт, он станет собирать данные на каждой странице. Этот процесс называется crawling. Сбор информации с сайта происходит не только после его создания. Робот будет периодически просматривать интернет-ресурс, чтобы проверить актуальность информации и обновить имеющиеся данные.

И для вас, и для бота (робота) подобное взаимодействие должно быть взаимовыгодным и комфортным. Вы, как владелец сайта, заинтересованы в том, чтобы бот выполнял свою работу быстро, не перегружая сервер, при этом максимально полно собирал данные со всех страниц. Боту также важно сделать все как можно быстрее, чтобы перейти к сбору данных со следующего сайта в его списке. Со своей стороны, вы можете проверить, что сайт работает, нет проблем с навигацией, отсутствуют страницы, выдающие ошибку 404 и т. д.

-

Индексация

Даже если робот побывал на вашем сайте не один раз, это еще не означает, что интернет-ресурс мгновенно станет виден поисковой системе и будет появляться в выдаче. После сбора данных следующий этап процесса обработки сайта — его индексация (создание для каждой страницы инвертированного файла индекса). Индекс нужен для быстрого поиска. Как правило, он состоит из перечня слов из текста и сведений о них (позиции в тексте, вес и т. д.).

После завершения индексации сайт и отдельные страницы появляются в выдаче поисковика по поисковым запросам пользователей. Обычно процесс индексации не занимает много времени.

-

Поиск информации

На этом этапе осуществляется непосредственно поиск информации по поисковым запросам пользователей. Сначала поисковая система анализирует запрос, определяет вес каждого из ключевых слов. Затем ищет соответствия по инвертированным индексам, отбираются все документы в базе данных поисковика, отвечающие поисковому запросу.

Соответствие документа запросу определяется по специальной формуле:

similatiry(Q,D) = SUM(wqk * wdk),

где similatiry(Q,D) — схожесть запроса Q документу D;

wqk — вес k-го слова в запросе;

wdk — вес k-го слова в документе.

Документы, больше всего схожие с запросом пользователя, отражаются в поисковой выдаче.

-

Ранжирование

На последнем этапе поисковая система группирует полученные результаты таким образом, чтобы вначале пользователь видел ссылки на наиболее релевантные страницы. У каждого поисковика своя уникальная формула ранжирования, в которой учитывается влияние следующих параметров:

-

веса страницы (индекс цитируемости, PageRank);

-

авторитетности домена;

-

релевантности текста запросу;

-

релевантности текстов внешних ссылок запросу;

-

а также множества других факторов ранжирования.

Для примера рассмотрим упрощенную формулу ранжирования:

Rа(x) = (m * Tа (x) + p * Lа (x)) * F(PRa);

где Rа(x) — итоговое соответствие документа а запросу x;

Tа(x) — релевантность текста (кода) документа а запросу x;

Lа(x) — релевантность текста ссылок с других документов на документ а запросу x;

PRа — показатель авторитетности страницы а, константа относительно х;

F(PRa) — монотонно неубывающая функция, причем F(0) = 1, можно допустить, что F(PRa) = (1 + q * PRа);

m, p, q — некие коэффициенты.

-

Таким образом, на место страницы в поисковой выдаче влияют различные факторы, которые как имеют отношение к поисковому запросу, так и никак с ним не связаны.

Принцип работы информационно-поисковых систем: критерии ранжирования

Если вы хотите, чтобы ваш интернет-ресурс входил в тройку или хотя бы десятку поисковой выдачи, нужно знать принципы работы поисковых систем и критерии ранжирования, чтобы постоянно оптимизировать сайт под их требования.

Выделяют две основных группы таких критериев:

-

Текстовые критерии поисковой системы.

Поисковая система в этом случае ранжирует страницы исходя из качества их текстового контента. Оптимизация этой составляющей сайта предполагает работу с семантическим ядром еще на этапе создания и наполнения интернет-ресурса.

Поисковик, обрабатывая запрос пользователя, на первой странице выдачи покажет наиболее релевантные результаты. В процессе поиска документов поисковая система анализирует правильность заполнения титульной фразы (title), описания страницы (description) и наличие ключевого запроса в заголовках (H1, H2 и т. д.).

-

Нетекстовые критерии поисковой системы.

Поисковая система проводит работу по анализу этих критериев после того, как сайт опубликован и проиндексирован. Основной принцип ранжирования по критериям этой группы — это оценка не качества их контента, а внешнего ссылочного профиля.

Поисковик анализирует количество ссылок на сайт с других интернет-ресурсов, оценивает их авторитетность, смотрит регистрации в каталогах. Если проводить аналогию, то поисковая система, как банк, который принимает решение выдать фирме кредит, собирает отзывы о ней от контрагентов, поставщиков, других кредиторов.

Знание принципов работы поисковых систем поможет вам создавать и оптимизировать сайты, которые легко будут занимать первые позиции в поисковой выдаче и долго там находиться, так как соответствуют поисковым запросам пользователей.

Принцип работы поисковой системы Яндекс

В основе работы таких крупных и известных поисковых систем, как Google и Яндекс, лежит система кластеров. Они группируют всю информацию по определенным областям, привязанным к тому или иному кластеру. Для индексации сайтов и отдельных страниц и сбора с них данных используются специальные роботы-сканеры.

Они бывают двух видов: основной робот-сканер (предназначен для сбора данных регулярно обновляющихся интернет-ресурсов) и робот-сканер (нужен для обновления перечня проиндексированных сайтов и их индексов в максимально короткое время). Для того чтобы поисковая система Яндекс собирала информацию в Интернете как можно полнее, регулярно проводится обновление базы поиска и программного кода:

-

Актуализация базы поисковой информации осуществляется несколько раз в месяц, при этом пользователи получают обновленные данные с интернет-ресурсов при введении запросов в поисковой строке. Эти данные добавляет основной робот-сканер.

-

Обновление программного кода или, как его называют программисты, «движка» предназначено для поиска и устранения недостатков работы алгоритмов, занимающихся ранжированием страниц в поисковой выдаче. Обычно Яндекс предупреждает пользователей о предстоящих изменениях.

Главное преимущество поисковой системы Яндекс, объясняющее ее популярность в Рунете, — это умение находить разные словоформы с учетом морфологических особенностей русского языка. Геотаргетинг и формула поиска позволяют получить на выходе максимально точную формулировку. Также у Яндекса есть свой уникальный алгоритм ранжирования страниц и сайтов. Бесспорным плюсом работы системы является быстрота обработки поисковых запросов пользователей и стабильная работа серверов.

Как уже говорилось, поисковая система при индексации ресурсов смотрит на динамические ссылки, наличие которых может стать причиной отказа от определения индекса сайта ботом.

В основе принципа работы Яндекса лежит анализ текстового контента в документах с различными расширениями (.pdf, .rtf, .doc, .xls, .ppt и др.).

В процессе индексации интернет-ресурса поисковик берет данные из файла robots.txt, при этом поддерживается атрибут Allow и часть метатегов, а метатеги Revisit-After и Keywords не учитываются.

Сниппеты (краткие описания текстовых документов) состоят из словосочетаний на искомой странице, поэтому писать теги в описании совсем не обязательно, но их можно ставить, если такая необходимость есть.

По мнению многих разработчиков, определение кода индексируемых документов происходит в автоматическом режиме, поэтому метатег кодировки не играет большой роли.

Яндекс большое внимание уделяет показателю последнего изменения информации (Last-Modified). Если сервер перестанет передавать поисковику эти данные, то индексация сайта будет проводиться гораздо реже.

Если у интернет-ресурса есть свои «зеркала» (например, , , <), нужно сделать так, чтобы поисковая система их не индексировала. Если это невозможно, то есть возможность склеить такие сайты, внеся соответствующие изменения в документ robots.txt.

После того как интернет-ресурс попадет в Яндекс.Каталог, поисковая система отнесет его к категории сайтов, требующих особого внимания, что скажется на его продвижении. Это также позволит упростить процедуру определения тематики сайта, что является, несомненно, плюсом, так как у него появится значимая внешняя ссылка.

Разработчики Яндекс не раскрывают IP-адреса своих роботов. Тем не менее в лог-файлах на разных сайтах можно найти текстовые пометки, принадлежащие роботам этой поисковой системы.

-

Yandex/1.01.001 (compatible; Win16; I) — основной робот, занимающийся непосредственно индексацией сайтов;

-

Yandex/1.01.001 (compatible; Win16; P) — робот-индексатор изображений;

-

Yandex/1.01.001 (compatible; Win16; H) — робот, который выявляет «зеркала» индексируемых сайтов;

-

Yandex/1.02.000 (compatible; Win16; F) — робот-индексатор пиктограмм ресурсов (favicons);

-

Yandex/1.03.003 (compatible; Win16; D) — робот, который обращается к страницам, добавленным с помощью формы «Добавить URL»;

-

Yandex/1.03.000 (compatible; Win16; M) — задействуется при переходе на страницу посредством ссылки «Найденные слова»;

-

YaDirectBot/1.0 (compatible; Win16; I) — этот робот отвечает за индексацию страниц ресурсов, принимающих участие в рекламной сети Яндекс.

Самый главный из всех поисковых роботов — основной. От результатов его работы по индексации страницы зависит значимость сайта для Яндекса.

У каждого робота есть свое расписание индексации интернет-ресурсов. Время работы разных роботов с каждым из сайтов в базе поисковой системы может не совпадать.

Помимо основных роботов, у поисковика есть дополнительные, которые регулярно заходят на страницы интернет-ресурсов, чтобы проверить их доступность. Например, это роботы Яндекс.Каталога и рекламной сети Яндекс.

Поисковая система Яндекс ориентируется на следующие ключевые показатели внешней оптимизации:

-

тИЦ (общедоступный тематический индекс цитирования) — показывает среднее количество ссылок, которые обращаются к сайту. Не влияет напрямую на результаты ранжирования, применяется для определения позиций в тематической группе Яндекс.Каталога. Используется при продвижении интернет-ресурсов.

-

вИЦ (взвешенный индекс цитирования) — специальный алгоритм, предназначенный для подсчета количества внешних ссылок на сайт. Имеет первостепенное значение при ранжировании страниц поисковой системой.

-

Присутствие сайта в Яндекс.Каталоге.

-

Общее число страниц сайта, прошедших индексацию.

-

Периодичность индексации контента интернет-ресурса.

-

Наличие и отсутствие ссылок с сайта, присутствие сайта в поисковых фильтрах.

Индекс цитирования лежит в основе тематического и взвешенного индекса цитирования.

Индекс цитирования (ИЦ) — показатель количества цитирований (или ссылок на первоисточник), помогает определить, какие из недавно созданных документов ссылаются на более ранние публикации. ИЦ применяется как для анализа статей, так и авторов (например, в научной среде).

В Яндексе, как и в других поисковых системах, индекс цитирования рассматривается как количество обратных ссылок без учета ссылок с сайтов следующих типов: немодерируемых каталогов, досок объявлений, сетевых конференций, страниц серверной статистики, XSS-ссылок и др., число которых может постоянно увеличиваться без участия владельца ресурса.

Нужно уточнить, что в каталоге Апорт ИЦ рассматривается как взвешенный индекс цитируемости.

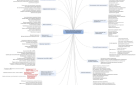

Для расчета этого индекса используется ссылочный граф: если сайты — это вершины графа, а ссылки на другие сайты — это связи вершин графа или ребра, то ссылочный граф предстает в виде диаграммы, представленной на рисунке:

где А, B, …, F — определенные сайты в индексе поисковой системы Яндекс, а стрелками обозначены направления связей между ними (односторонние или двусторонние).

Индекс цитирования играет большую роль в ранжировании документов поисковиком, но итоговые результаты зависят не только от этого показателя.

Считается, что индекс цитирования характеризует значимость публикации, но при этом он не отражает структуру ссылок сайта, в результате ресурсы с разным количеством внешних ссылок могут быть проиндексированы одинаково.

Для устранения этого недостатка используют взвешенный индекс цитирования, который характеризует не только количество, но и качество ссылающихся ресурсов. Применение ссылочного поиска и статической ссылочной популярности облегчает работу поисковых систем, избавляя их от различного текстового спама. В поисковой системе Google используется аналогичный взвешенному индексу цитирования показатель PageRank.

Для расчета вИЦ, как и других факторов, влияющих на ранжирование, используется ссылочный граф. Владелец сайта может самостоятельно примерно оценить вИЦ своего интернет-ресурса, проверив его значение PageRank с помощью любого из доступных онлайн-сервисов. Но стоит иметь в виду, что в индексе Яндекса находятся только документы на русском языке, а из иностранных лишь отдельные популярные, таким образом, значение яндексовского вИЦ будет отличаться от гугловского PageRank.