В статье рассказывается:

- Что такое дубли страниц на сайте

- Почему нужно избавляться от дублей страниц на сайте

- Виды дублей страниц на сайте

- Как найти дубли страниц на сайте

- Рабочие способы, как удалить дубли страниц на сайте

- Онлайн-сервисы проверки сайта на дубли страниц

- Поиск дублей страниц сайта на примерах

- Часто задаваемые вопросы про дубли страниц на сайте

Появление копий на сайте связано с разными причинами, но поисковик в них разбираться не будет. Он просто отметит для себя данный сайт как некорректный и снизит его позиции в поиске. А вот владельцу интернет-ресурса знать об этом необходимо: он должен как можно быстрее удалить дубли страниц на сайте и постараться не допустить их появления в будущем. Читая далее, вы поймете, как это сделать.

Что такое дубли страниц на сайте

Дубли — это разделы, в которых размещена одна и та же информация. Появиться они могут случайно, из-за того, что администратор изменил структуру сайта или некорректно разделил его на кластеры, из-за неправильной настройки или при автогенерации.

Продублированные элементы отрицательно сказываются на SEO-продвижении, потому что поисковики распознают их как неуникальные. Соответственно, из-за малосодержательных элементов снижается оценка всего сайта. Если вы хотите видеть своё детище в топе, то дубликаты надо постоянно отслеживать и быстро устранять.

Источник: shutterstock.com

Причины возникновения дублей страниц на сайте:

-

Системой управления контентом (CMS) пользуются многие разработчики, хотя именно она может стать причиной появления дублирующих разделов. К примеру, статья была написана для нескольких рубрик на ресурсе, но их домены входят в адрес сайта, где была размещена запись. В итоге образовались аналоги такого вида:

-

wiki.site.ru/blog1/info/

-

wiki.site.ru/blog2/info/

-

-

Технические разделы. Больше всего подобных ситуаций возникает при работе с Bitrix и Joomla. Например, когда разрабатываются функции сайта — поиск, фильтрация, генерация и так далее. Любая из них может сгенерировать параметрические адреса с одной и той же информацией по отношению к ресурсу без параметров в URL, например:

-

site.ru/rarticles.php

-

site.ru/rarticles.php?ajax=Y

-

-

Человеческий фактор. Ситуация обычно возникает из-за невнимательности администратора сайта, разместившего один и тот же текст в разных местах.

-

Технические ошибки. При использовании разных систем управления информацией со своими настройками неправильная генерация ссылок может привести к дублированию и даже зацикливанию, как в случае некорректной ссылки в системе Opencart:

-

site.ru/tools/tools/tools/…/…/…

-

Почему нужно избавляться от дублей страниц на сайте

Рассмотрим подробнее, чем грозит присутствие дублирующих разделов на сайте.

-

Ухудшается индексация сайта

Если в проекте из тысячи страниц появится хотя бы по одному дублю, то объем ресурса увеличится вдвое. А если их будет больше? Например, экспертиза одного новостного портала показала, что автоматическое размещение одной новости в каждом разделе приводит к появлению новой страницы сразу с несколькими дублями.

-

Неправильно распределяется внутренний ссылочный вес

Дубликат может появиться и в результате неправильно организованной перелинковки. В итоге страница-аналог приобретает больший вес, чем оригинал. Свою роль играют и посетители, попадающие на дублирующую копию, тем самым изменяя её показатели. В этом случае количество посещений на основной версии не изменится.

-

Меняется релевантная страница в поисковой выдаче

Поскольку сайт открыт для индексации, то поисковик, наткнувшись на копию, может посчитать её более релевантной запросу, чем оригинал. Происходящая при этом смена страницы в поисковой выдаче может заметно снизить позицию сайта.

-

Теряется внешний ссылочный вес

Заинтересовавшись вашим товаром или статьей, пользователь решил поделиться информацией и поставил ссылку на страницу. Если он побывал на дубле, то дал указатель именно на неё, а основная версия недосчитается полезной естественной ссылки.

Виды дублей страниц на сайте

Дубликаты бывают трех видов:

-

Полные — с полностью одинаковым контентом.

-

Частичные — с частично повторяющимся контентом.

-

Смысловые — когда несколько разделов несут один смысл, переданный разными словами.

Анализируя структуру сайта, эксперты чаще реагируют на полные совпадения, хотя поисковые системы замечают и частичные, и смысловые.

Полные

Полный аналог ухудшает факторы внутренней оптимизации всего сайта и затрудняет его продвижение в ТОП, что крайне нежелательно. Поэтому их надо ликвидировать сразу после обнаружения.

К ним относятся:

-

Версия с/без www. Возникает, если пользователь не указал зеркало в панели «Яндекса» и Google.

-

Различные варианты главной страницы:

-

site.net/index.html;

-

site.net/index/;

-

site.net/index;

-

site.net.

-

-

Страницы, которые появляются при ошибочной иерархии разделов:

-

site.net/category/gift/;

-

site.net/products/gift/;

-

site.net/products/category/gift/.

-

-

UTM-метки. Они используются, чтобы передавать данные для анализа рекламы и источника переходов. Поисковики их обычно не индексируют, но иногда бывают исключения.

-

GET-параметры в URL. Иногда при передаче данных GET-параметры попадают в адрес:

-

site.net/products/gift/page.php?color=red.

-

-

Разделы, сгенерированные реферальной ссылкой. Обычно их выделяют специальным параметром, добавляемым к URL. На такой ссылке должен стоять редирект на обычный URL, но этим часто пренебрегают.

-

Если неправильно настроить раздел с ошибкой 404, то он спровоцирует появление бесконечного количества дублей. Любые символы в адресе сайта автоматически превратятся в ссылку и без редиректа выдадут ошибку 404.

Прекратить появление дубликатов с полным совпадением можно, если поставить редирект, убрать ошибку программным путем или закрыть ресурс от индексации.

Частичные

Дубликаты с частичным совпадением меньше влияют на сайт. Трудно сказать, сколько дублей страниц сайта допустимо. Но если их слишком много, то это снижает позиции ресурса в поисковой выдаче, а также мешает его продвижению по конкретным ключевым запросам. Осталось выяснить, как частичные дубли появляются на сайте.

Источник: shutterstock.com

-

Характеристики в карточке товара

Описание товара на странице может иметь дополнительные вкладки, например отзывы или характеристики. Переключившись на одну из них, можно отследить изменение URL, хотя большая часть информации не меняется. Это и создает дубль.

-

Пагинация

Если система управления контентом настроена неверно, то при переходе на следующую страницу в одной категории URL меняется, а Title и Description остаются теми же. В результате получаем несколько различных ссылок с одинаковыми метатегами:

-

site.net/category/notebooks/?page=2;

-

site.net/category/notebooks/.

Поисковый алгоритм проиндексирует эти URL-адреса как разные документы. Этого можно избежать — надо лишь проверить реализацию вывода товаров и автогенерации с технической стороны.

Кроме этого, на каждом документе пагинации надо будет указать каноническую страницу как главную на сайте.

-

Подстановка контента

Когда владельцы ресурса хотят увеличить количество посещений по запросам с указанием города, они добавляют на сайт кнопку выбора региона. При переходе в другой город на странице с контактами меняется номер телефона. Но бывают случаи, когда в адресной строке появляется такой аргумент, как, например, «wt_city_by_default=..». В результате документ получает несколько дублей с разными ссылками. Подобная генерация недопустима, старайтесь использовать 301 редирект.

-

Версия для печати

Подразумевает точную копию содержимого раздела, но в другом, преобразованном формате, например:

-

site.net/blog/content;

-

site.net/blog/content/print — версия для печати.

Чтобы не создавать множество дубликатов, их надо закрывать от индексации в robots.txt.

Смысловые

Чтобы обнаружить смысловые дубли, а точнее статьи, написанные под запросы из одного кластера, необходимо провести парсинг сайта, например, с помощью программы Screaming Frog. Затем добавить в любой Hard-кластеризатор скопированные заголовки всех статей с порогом группировки 3,4. Смысловые дубли обязательно окажутся в одном кластере. Надо оставить лучшую статью, а с остальных поставить 301 редирект.

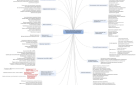

Как найти дубли страниц на сайте

Поняв, что такое дубли и чем грозит их появление на сайте, надо научиться их находить, чтобы потом удалить.

Рассмотрим несколько способов поиска дубликатов.

Поиск дублей с помощью поисковиков

Для Google достаточно указать в расширенном поиске адрес главной страницы, чтобы он выдал проиндексированный объем. Если же в поисковой строке задать адрес документа, который хотелось бы проверить, то система выложит перечень дублей, попавших в индексацию. В этом отношении работать с «Яндексом» проще: поисковик сразу показывает все копии проиндексированных страниц.

Если на вашем ресурсе много документов, для ускорения процесса анализа разбейте их на категории — товарные карточки, статьи в блоге, новости и так далее.

Если вы считаете, что дубли имеет конкретная страница, то на помощь придет поисковый запрос, сформированный из определенного фрагмента текста. Он складывается следующим образом: часть текста берется в кавычки, затем ставится пробел и оператор «site:». Здесь надо указать ваш сайт, на котором будет работать поисковый алгоритм. Например:

«Фрагмент текста со страницы сайта, которая может иметь дубли» site:examplesite.net

Если ваши сомнения не оправдались, то результатом станет та самая страница, которую вы подозревали в наличии дубликатов. Несколько документов, выданные в результате поиска, заставят задуматься о причинах размещения на них одинакового контента. Либо это и есть ожидаемые дубли, которые надо удалить.

Точно так же можно проанализировать сайт с помощью оператора «intitle:», который сравнит содержимое «Title» на представленных в выдаче страницах. Одинаковые метатеги могут быть признаком дубликата — проверить это можно с помощью поискового оператора «site:»:

site:examplesite.net intitle:полный или частичный текст тега Title.

Также с помощью операторов «site» и «inurl» вылавливаются продублированные документы, возникшие на страницах сортировок (sort) или при работе фильтров и поиска (filter, search). Чтобы найти, например, все страницы сортировок, надо задать в поисковой строке: site:examplesite.net inurl:sort. А для поиска страниц фильтров и поиска — site:examplesite.net inurl:filter, search.

Этот метод поиска ориентирован только на дубли, которые были проиндексированы системой. Поэтому полной гарантии того, что обнаружены все копии, он не дает.

Программы и инструменты для поиска дублей

-

Программа XENU (Xenu Link Sleuth) позволяет провести аудит сайта и найти дубли, но только с полным совпадением. Для этого в специальную строку надо ввести URL сайта. Частичные повторы программа отследить не сможет.

-

Полные дубли можно обнаружить при помощи инструментов web-мастерской Google. Для этого надо в ней зарегистрироваться, и тогда в разделе «Оптимизация Html» появится перечень страниц с повторяющимся контентом и метатегами <Title>. Полностью дублированные документы в нём хорошо видны, но разделы с частичным совпадением определить невозможно.

-

Онлайн-seo-платформа Serpstat проводит технический seo-аудит сайта по 55+ ошибок. В неё входит и блок для распознавания и анализа дублируемого контента. Сервис способен найти полные дубликаты Title, Description, H1 на нескольких страницах. Он успешно распознает совпадение H1 и Title, замечает, когда на одной странице ошибочно прописали два метатега Title и не один заголовок формата H1.

Для работы с сервисом Serpstat надо в нём зарегистрироваться и открыть проект для технического аудита сайта.

-

Использование поисковых операторов. Для поиска дублей среди открытых для индексации страниц удобно использовать оператор «site:». Если ввести в строку поисковика (Google или «Яндекс») запрос «site:examplesite.net», то в общем индексе выйдут все страницы сайта. Их количество может сильно отличаться от найденных спайдером или от числа страниц в XML-карте. Проанализировав список выдачи, можно обнаружить и дублируемые, и мусорные разделы, которые необходимо закрыть от индексации.

Рабочие способы, как удалить дубли страниц на сайте

Прежде чем проводить регулярную чистку ресурса от дубликатов, неплохо было бы сначала удалить причину их появления. Иначе работа превратится в сизифов труд. Если программирование — ваш хлеб, то вы легко справитесь с ошибками в функционировании CMS. Или, чтобы не отнимать хлеб у программистов, пригласите знающего человека для наладки системы. После успешного решения проблемы можно заняться её последствиями.

-

Закрытие через robots.txt.

Текстовый файл robots.txt можно назвать в определенном смысле инструкцией по индексации ресурса для поисковых систем. С его помощью легко можно запретить индексацию разного рода служебных документов и выявленных дублей.

Директива Disallow не допускает поискового робота к индексации записанных в ней элементов:

-

Disallow: /dir/ — директория dir запрещена для индексации.

-

Disallow: /dir — директория dir и все вложенные документы запрещены для индексации.

-

Disallow: *XXX — все страницы, в URL которых встречается набор символов XXX, запрещены для индексации.

При заполнении директивы требуется внимательность, чтобы не спрятать от поисковиков основные разделы или не скрыть от них вообще весь сайт.

Роботы послушно обходят стороной указанные в Disallow страницы, но реагируют на её присутствие каждый по-своему. С течением времени «Яндекс» просто удалит все запрещенные директории из индекса, а Google может обойти запрет, если на конкретный документ настроены ссылки.

-

-

301 редирект. Этот способ удобен тем, у кого дублей не так много, а по каким-либо причинам их не хотелось бы закрывать от индексации, например из-за проставленной внешней ссылки. Как убрать дубли страниц на сайте в этом случае? Настройте 301 редирект с дубликата на основную страницу.

-

Link rel=«canonical». Когда к одному и тому же контенту можно попасть через разные URL, удобно будет воспользоваться методом указания канонической страницы. Для каждой такой статьи создается тег вида <link=«canonical» href=«http://site.ru/cat1/page.php»>, где http://site.ru/cat1/page.php — тот вариант URL записи, который надо проиндексировать.

Тег внедряется программным путем в каждый подобный пост, а далее, даже если у него будет 100 URL, поисковая система воспользуется только тем, который прописан в коде. И не заметит те документы, у которых собственный URL отличается от URL, обозначенного в link rel=«canonical».

-

Google Search Console. Прием, не отличающийся популярностью, но вполне работающий. Им можно воспользоваться в разделе «Сканирование» — «Параметры URL» из Google Search Console.

Таблица содержит в себе необходимые параметры URL. Добавляя другие, мы сообщаем поисковому роботу, что страницы с дополнительными данными не изменяют содержимое раздела, поэтому индексировать их необязательно. Правда, возможен и такой вариант, когда при добавлении нового параметра в адрес содержимое раздела перемешивается, сохраняя свой состав без изменения. Например, это может быть сортировка записей в категории по популярности.

Дав необходимую информацию поисковику, владелец ресурса тем самым помогает Google точнее проанализировать сайт в процессе его сканирования. Но решение вопроса об индексации документов с добавленными параметрами в URL лучше предоставить «На усмотрение робота Googlebot&rauqo».

Онлайн-сервисы проверки сайта на дубли страниц

Как найти контент, представляющий собой дубликат оригинала? Для этого разработаны поисковые программы и сервисы онлайн-проверки. Одни из них платные, другие — бесплатные, часть — условно-бесплатные, предлагающие пробную версию на какое-то время или ограничивающие функционал до принятия решения об оплате.

Xenu — бесплатный аналог предыдущих программ. С её помощью на предмет поиска дублирующих разделов можно проанализировать даже сайт, не прошедший индексацию.

При сканировании программа найдет повторяющиеся заголовки и метатеги.

-

Яндекс.Вебмастер

Удобно и просто работать с Яндекс-панелью. Чтобы узнать о наличии дублей, необходимо:

-

выбрать вкладку «Индексирование»;

-

открыть раздел «Страницы в поиске»;

-

посмотреть количество «Исключенных страниц».

Причины исключения из индексации прописываются под ссылками. Они бывают разными, в том числе из-за идентичного текста.

-

-

Netpeak Spider

Netpeak Spider — платная программа с 14-дневным свободным доступом. Если провести поиск по заданному сайту, то программа покажет все найденные ошибки и дубликаты.

-

Xenu

-

Screaming Frog Seo Spider

Screaming Frog Seo Spider — условно-бесплатная программа, позволяющая быстро и эффективно проверить до 500 ссылок на наличие дублей. Если надо больше, придется заплатить или найти рабочий ключ в Интернете.

-

Сервис-лайфхак

Тем, у кого нет желания осваивать сервисные программы, подойдет Wizard.Sape. Технический аудит проводится в автоматическом режиме за 2–4 часа и стоит всего 690 рублей. В течение месяца ещё одну проверку можно устроить бесплатно. Инструмент собирает массу полезной информации для владельца ресурса и помимо найденных дублей разделов и метатегов показывает:

-

все 301 редиректы;

-

обработку заранее ошибочных адресов;

-

страницы, на которых нет контента;

-

битые внешние и внутренние ссылки и картинки.

-

Поиск дублей страниц сайта на примерах

Появление дублей происходит чаще всего по одним и тем же причинам. Поэтому продвигающие очередной проект разработчики в первую очередь обращают внимание на следующие ситуации:

-

Дубли разделов с разными протоколами: http и https.

Вот пример такого дубля: http://www.foxtrot.com.ua/ и https://www.foxtrot.com.ua/.

-

С www и без www.

Например: http://oknadeshevo.ru/ и http://www.oknadeshevo.ru/.

-

Со слешем на конце URL и без него.

Например: https://www.1tv.ru/live и https://www.1tv.ru/live/.

Еще пример: https://www.lamoda.ru/p/wa007ewbhbj9/clothes-wallis-bryuki и https://www.lamoda.ru/p/wa007ewbhbj9/clothes-wallis-bryuki/.

При этом на каждой странице прописана canonical на саму себя.

-

Строчные и прописные буквы во вложенностях URL.

Например: https://www.mosokna.ru/info/osteklenie-detskikh-sadov/ и https://www.mosokna.ru/info/OSTEKLENIE-DETSKIKH-SADOV/.

При том, что раздел https://www.mosokna.ru/PLASTIKOVYE-OKNA/ отдаёт код 404 ответа сервера.

Это пример того, как поисковые системы по-разному обрабатывают один и тот же принцип формирования дублей на разных типах документов.

-

Добавления в конце URL:

index.php

home.php

index.html

home.html

index.htm

home.htm

Например: https://www.eldorado.ru/cat/378830466/ и https://www.eldorado.ru/cat/378830466/index.html/.

Оба URL проиндексированы в «Яндексе».

-

Множественное добавление ////////////////// в конце URL.

Например, http://www.banki.ru/ и http://www.banki.ru////////.

-

Множественное добавление ////////////////// между вложенностями.

Например, https://moskva.beeline.ru/customers/products/mobile/services/details/nomer-na-vybor/krasivie-nomera/ и https://moskva.beeline.ru/customers///////products///////mobile///////services///////details///////nomer-na-vybor///////krasivie-nomera/.

Другой пример: https://f.ua/hewlett-packard/15-bs006ur-1zj72ea.html и https://f.ua/hewlett-packard///////15-bs006ur-1zj72ea.html.

Довольно часто встречающаяся ошибка.

-

Добавление произвольных символов в конец URL, формирующее новое вложение.

Например, https://apteka.ru/moskva/apteki/doktor-stoletov_16/ и https://apteka.ru/moskva/apteki/doktor-stoletov_16/Lfz/.

-

Добавление произвольных символов в существующее вложение.

Например, https://www.dochkisinochki.ru/brands/nutrilon/ и https://www.dochkisinochki.ru/brands/nutrilonbY5I/.

-

Добавление вложенности с произвольными символами.

Например, https://www.utkonos.ru/news/item/1343 и https://www.utkonos.ru/news/wg/item/1343.

Не совсем дубль, но страница отдаёт код 200 ответа сервера, а это дает ей право на индексацию.

-

Добавление * в конце URL.

Например, https://www.sportmaster.ru/product/10137329/ и https://www.sportmaster.ru/product/10137329/*/.

Ещё пример: https://docdoc.ru/clinic/set-evropeyskiy-medicinskiy-centr и https://docdoc.ru/clinic/set-evropeyskiy-medicinskiy-centr/*.

-

Замена нижнего подчеркивания «_» на тире «-» и наоборот.

Например, https://mamsy.ru/filter/zhenshinam_tovary_bolshie_razmery/ и https://mamsy.ru/filter/zhenshinam-tovary-bolshie-razmery/.

-

Добавление произвольных цифр в конце URL, что определяет новое вложение.

Например, https://apteka.ru/moskva/apteki/doktor-stoletov_16/ и https://apteka.ru/moskva/apteki/doktor-stoletov_16/2488/.

Этим часто грешат публикации на WordPress.

-

Перестановка вложенностей.

Например https://www.toy.ru/catalog/producers/BARBIE-Mattel/ и https://www.toy.ru/producers/catalog/BARBIE-Mattel/.

-

Пропущенное внутреннее вложение.

Например, https://www.toy.ru/catalog/producers/BARBIE-Mattel/ и https://www.toy.ru/producers/BARBIE-Mattel/.

Отметим, что пункты 14 и 15 не являются полными дублями, но аналогично пункту 10 отдают код 200 ответа сервера.

-

Копирование первой вложенности и добавление её в конец URL.

Например, https://www.dochkisinochki.ru/brands/nutrilon/ и https://www.dochkisinochki.ru/brands/nutrilon/brands/.

-

Дубли .html, .htm или .php для страниц, которые заканчиваются на одно из этих расширений.

Например:

• http://sad-i-ogorod.ru/shop/11041.php;

• http://sad-i-ogorod.ru/shop/11041.htm;

• http://sad-i-ogorod.ru/shop/11041.html.

Приведенные выше типы дублей реально существуют и были обнаружены в индексе поисковых систем нескольких проектов. Вряд ли кто-то из владельцев сайтов хотел бы получить такое огромное количество копий. Поэтому очень важно обнаружить их в процессе формирования и не допустить индексации поисковиками. Хотя на практике роботы такие документы всё-таки находят и индексируют их, причем без каких-либо внутренних или внешних ссылок.

Ручная проверка всех дублей займет много времени и всё равно не будет достаточно эффективной. Ведь на наличие копий надо проверять каждый тип документов. Категории товаров и определенный товар организованы по-разному и будут иметь разные дубли в случае их появления.

Многие сайты чаще всего используют разные CMS для определенного типа контента. Считается нормальным, когда к интернет-магазину на OpenCart подключен блог на WordPress. Понятно, что дубли разделов этих CMS будут так же отличаться друг от друга, как и сами системы.

Часто задаваемые вопросы про дубли страниц на сайте

-

«Многостраничные разделы (пагинация) — дубли или нет? Стоит закрывать их от индексации?»

Нет, многостраничники — это не дубли, потому что каждый раздел несет уникальный по отношению к другим директориям контент. Так что ни закрывать от индексации, ни ставить на первую страницу раздела rel=«canonical» не надо. К тому же поисковые системы умеют распознавать пагинацию. Для подстраховки достаточно проставить элементы микроразметки rel=«next» и rel=«prev».

Например:

<link rel="next" href="URL следующего по порядку документа раздела">

<link rel="prev" href="URL предыдущего документа раздела">

-

«URL с хештегами (#) — дубли или нет? Обязательно их удалять?»

Поисковики по умолчанию не обращают внимания на страницы с # в адресе и не индексируют их, так что можно не волноваться.

Чтобы улучшить продвижение сайта, необходимо отслеживать появление на ресурсе дубликатов, полных или частичных, сгенерированных в результате технических ошибок или смысловых. Описанные в статье методы помогут вам их благополучно устранить.