О чем речь? Индексация сайта — процедура оценки ресурса поисковыми системами и присвоения определенного места в выдаче. Если робот нашел что-то запрещенное, то часть контента либо вся страница не будет показана пользователям.

О чем речь? Индексация сайта — процедура оценки ресурса поисковыми системами и присвоения определенного места в выдаче. Если робот нашел что-то запрещенное, то часть контента либо вся страница не будет показана пользователям.

На что обратить внимание? Процесс индексации отличается у Яндекса и Google, а также в зависимости от тематики самого веб-ресурса. Чтобы он пошел быстрее, необходимо оптимизировать техническую часть сайта и контент, регулярно обновлять страницы и выполнять ряд других действий.

На что обратить внимание? Процесс индексации отличается у Яндекса и Google, а также в зависимости от тематики самого веб-ресурса. Чтобы он пошел быстрее, необходимо оптимизировать техническую часть сайта и контент, регулярно обновлять страницы и выполнять ряд других действий.

В этой статье:

- Понятие индексации сайта

- Порядок индексации сайта в Google

- Отличия индексации сайта в Яндексе

- Особенности индексации сайтов разной тематики

- Как проиндексировать сайт

- Проверка индексации сайта

- Методы ускорения индексации сайта

- Как закрыть сайт от индексации

- Проблемы с индексацией сайта

- Часто задаваемые вопросы об индексации сайта

-

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Понятие индексации сайта

Чтобы веб-ресурс появился в выдаче, сначала его должны «увидеть» поисковые системы. Этот процесс называется индексированием. Он начинается задолго до раскрутки или роста позиций.

Поисковая индексация сайта — процесс, при котором Яндекс и Google сканируют его страницы. И вносят их в собственную базу данных. Этим занимается специальная программа — поисковый робот.

Он автоматически изучает сайт, анализируя его структуру, ссылки, текстовое наполнение и другие параметры. Если все требования соблюдены, страница добавляется в индекс и может появляться в результатах поиска.

Источник: shutterstock.com

Однако при наличии ошибок (например, дублирующегося контента, запретов в файле robots.txt или технических неполадок) поисковая система может проигнорировать часть страниц.

Это значит, что потенциальные клиенты не найдут их через поиск — и вы теряете трафик и прибыль. Сегодня значительно ужесточили требования к индексации. Теперь важную роль играют:

-

скорость загрузки сайта;

-

адаптация под мобильные устройства;

-

оригинальность и соответствие контента пользовательским запросам;

-

поведенческие факторы (например, время, проведённое на странице, число отказов).

Важно понимать: индексация сайта — не просто добавление страницы в поисковую базу. Это полноценная оценка их качества, удобства, полезности. Если на этом этапе сайт получает «отказ», дальнейшее продвижение не имеет смысла: страница просто не будет отображаться в выдаче.

Поэтому грамотная индексация — это основа SEO. Пока сайт не проверен правильно, рассчитывать на высокие позиции в Яндекс или Google не стоит. Лучше решить все технические и содержательные вопросы заранее — и только потом заниматься продвижением.

Читайте также!

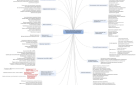

Порядок индексации сайта в Google

Процесс попадания сайта в его выдачу делится на три ключевых этапа: сканирование, индексация и показ. Каждый важен для того, чтобы его страницы стали видимыми для пользователей.

Сканирование

На первом этапе Google занимается тем, что ищет доступные в интернете страницы. Поскольку универсального списка всех сайтов нет, используется специальный алгоритм обнаружения URL.

Основную работу выполняет Googlebot — поисковый робот. Он регулярно проверяет уже известные сайты и переходит по ссылкам, чтобы находить новые страницы.

Во время сканирования робот изучает структуру ресурса, обращает внимание на контент и техническое состояние.

Он решает, как часто и в каком объёме нужно изучать конкретный сайт, чтобы не перегружать его. Например, если сервер отвечает ошибкой (например, код 500), частота сканирования снижается.

Источник: shutterstock.com

Важно: Googlebot не просматривает все страницы подряд. Некоторые из них могут быть скрыты за авторизацией или защищены от сканирования в настройках сайта.

Кроме того, процесс включает так называемый рендеринг. То есть Google запускает JavaScript. И визуализирует страницу почти так же, как это делает обычный пользователь в браузере Chrome. Это особо важно, если значимая часть контента зависит от JavaScript и требует соответствующего рендеринга.

Индексирование

Когда страница успешно отсканирована, Google приступает ко второму этапу. Это индексирование. Здесь поисковик оценивает, насколько страница уникальна. И стоит ли добавлять её в основной индекс.

Страницы с очень похожим содержанием группируются в кластеры. Из них выбирается каноническая версия — та, которая будет отображаться в результатах поиска. Решение о том, какая страница станет такой, зависит от множества факторов.

Это язык контента, удобство для пользователя, целевая аудитория и география. Остальные страницы из кластера могут быть показаны в выдаче только в определённых условиях. Например, если запрос введён с мобильного устройства или пользователь ищет конкретный адрес.

Но не все страницы, которые прошли сканирование, попадают в индекс. Проблемы с версткой, низкое качество контента, неверные настройки метатегов robots.txt — причины игнорирования.

Отображение в поисковой выдаче

На заключительном этапе, когда пользователь вводит запрос, Google использует сложный алгоритм для выбора страниц, наиболее подходящих по смыслу и качеству. При этом учитываются не только ключевые слова, но и множество дополнительных факторов.

Источник: shutterstock.com

Это язык и местоположение пользователя, устройство, с которого выполняется поиск (ПК или смартфон), тип запроса (информационный, коммерческий, навигационный и т. д.). Например, если посетитель в Минске ищет «ремонт велосипеда», в первую очередь он увидит локальные сервисы. А при запросе «топ велосипедов 2026», скорее всего, появятся сайты с обзорами и картинками.

Важно помнить, что даже проиндексированные страницы могут не отображаться в поисковой выдаче. Причины могут быть разными: низкое качество контента, отсутствие релевантности к запросу или ограничения в метатегах, запрещающих показ.

Отличия индексации сайта в Яндексе

Индексация сайта в Яндекс также проходит несколько этапов. Прежде чем страница попадёт в поисковую выдачу, происходит следующее.

Сбор данных ботом

Первый шаг начинается с обхода сайта поисковыми роботами Яндекс. Эти автоматизированные программы принимают решение о том, какие сайты нужно посещать, с какой регулярностью и какое количество страниц сканировать на каждом из них.

Список URL-адресов для обхода формируется на основании нескольких источников: внутренних и внешних гиперссылок, информации из файлов Sitemap, данных, полученных с помощью счетчика Яндекс.Метрика, а также ограничений и указаний из файла robots.txt. Стоит иметь в виду, что если страница превышает размер в 10 мегабайт, она не будет принята к индексации.

Кроме того, поисковые роботы Яндекса постоянно отслеживают изменения на уже известных страницах, проверяют их актуальность и доступность. Если страница становится закрытой от индексации, робот исключает её из дальнейшего обхода.

Важно понимать: пока возможен ее анализ и она имеет активную ссылку хотя бы на одном сайте, она будет изучаться системой. Такой подход позволяет Яндекс предоставлять пользователям актуальные и точные результаты поиска.

Обработка и анализ данных

На следующем этапе происходит глубокое исследование загруженной информации. Яндекс внимательно анализирует множество элементов каждой страницы: заголовок (title), описание в метатеге (description), наличие структурированных данных (например, разметка Schema.org).

Если страница содержит директиву noindex в метатеге robots или запрещена к индексации через файл robots.txt, она не будет отображаться в выдаче. Поисковый робот также проверяет ее содержимое: текст, изображения, видео, интерактивные элементы.

Источник: shutterstock.com

Важной задачей является выявление дубликатов контента. Если на сайте или за его пределами найдены другие страницы с аналогичным материалом, Яндекс может объединить их в группу и выбрать одну — основную — версию. Остальные будут проигнорированы или отображаться в редких случаях. Это помогает избежать повторов и повысить качество поиска.

Формирование базы страниц

Данные с сайта успешно загружены и обработаны. Теперь алгоритмы Яндекс анализируют их и принимают решение — добавить ли страницу в базу для последующего показа в результатах поиска. В нее могут не попасть закрытые от сканирования и индексации, дубликаты других, и контент, не соответствующий базовым требованиям к качеству.

Бывают и исключения: уникальная, структурированная и информативная страница может не быть добавлена в индекс из-за недостаточной конкурентоспособности. Это если поисковая система «не видит» в ней интереса для аудитории.

Таким образом, попадание страницы в базу не всегда гарантировано даже при внешне корректной структуре и контенте. И всё это — часть сложной, но нужной системы фильтрации, нацеленной на предоставление пользователям только действительно полезной информации.

Показ в поиске

После попадания в базу начинается заключительный этап. Это определение, будет ли страница показана в поиске по конкретному запросу. Здесь вступают в работу алгоритмы ранжирования, которые оценивают десятки параметров.

Вот основные критерии, по которым Яндекс определяет качество страницы:

-

Релевантность содержимого. Алгоритм сопоставляет тему страницы с запросом пользователя. Чем точнее соответствие — тем выше шанс попасть в выдачу.

-

Полезность и ясность информации. Контент должен быть понятным, полным, актуальным. Предпочтение отдается страницам, на которых пользователь находит ответ без необходимости переходить по другим ссылкам.

-

Удобство восприятия. Важно всё — от четких заголовков и абзацев до корректной адаптации под мобильные устройства. Алгоритм учитывает даже такие детали, как наличие списков, таблиц и структурированной подачи информации.

Если страница соответствует этим критериям, она получает шансы на высокие позиции в результатах поиска. Но важно помнить: попадание в индекс не гарантирует показ в выдаче.

Таким образом, индексация сайта в поисковике — это динамичный и многоступенчатый процесс. От правильной настройки ресурса и качества его наполнения зависит, будет ли он представлен в выдаче и увидит ли его ваша аудитория.

Читайте также!

Особенности индексации сайтов разной тематики

Индексация сайта — это не универсальный процесс, а индивидуальный для каждой тематики механизм. Как поисковые системы оценивают и ранжируют контент в зависимости от его направленности? Разберём их основных типов веб-ресурсов.

Коммерческие площадки

Для интернет-магазинов с каталогами товаров ключевой задачей становится корректная подача информации. Это четкая структура разделов, наличие карточек продуктов с уникальными описаниями, техническими характеристиками, отзывами и фотографиями.

Частая ошибка — дублирование страниц. Это может ухудшить индексацию и повлиять на позиции. Также важно не допускать пустых или автоматически сгенерированных страниц. Они негативно воспринимаются поисковыми системами и мешают эффективному обходу.

Новостные ресурсы

Сайты с оперативным контентом требуют отдельного подхода. Для них особенно важны скорость публикации новостей, уникальность формулировок, надежные источники, правильная дата публикации и авторство.

Источник: shutterstock.com

Для таких ресурсов Яндекс использует отдельного «быстрого» робота, который чаще посещает подобные страницы, чтобы как можно быстрее включить их в выдачу.

Блоги и порталы

Для дневников и информационных площадок главный критерий успеха — регулярное обновление содержимого и его качество. Здесь приветствуется разнообразие форматов: текст, изображения, видео, инфографика, подкасты. Важно правильно организовать навигацию: распределение по темам и категориям, внутренние ссылки между статьями, оптимизированные теги и заголовки.

Сайты на JavaScript

Современные ресурсы всё чаще создаются с применением JavaScript-фреймворков. Однако поисковые боты не всегда способны корректно отобразить такой контент. Поэтому необходимо выполнять предварительный (Prerender.io, Puppeteer) и серверный рендеринг (SSR), грамотную настройку SPA-приложений.

Очень важна и система управления контентом (CMS). Это не только способ руководства сайтом, но и важный фактор SEO. Популярные платформы WordPress, 1С-Битрикс, Joomla, Tilda и другие предлагают инструменты, которые упрощают индексацию.

Это автоматическая генерация карты сайта, настройка метатегов и канонических URL, оптимизация скорости загрузки и мобильной адаптации. Но для достижения максимального эффекта важно не полагаться лишь на встроенные функции. Нужно вручную контролировать ссылки и архитектуру сайта, качество контента.

Важно отметить, что поисковики по-разному относятся к форматам информации. Тексты выверяют на уникальность, полноту, актуальность и структуру. Ключевые слова должны использоваться органично. К изображениям, аудио и видео требования легче, но тоже есть правила оптимизации.

Итак, каждый тип сайта требует индивидуального подхода к индексации. Универсальные советы работают частично. Надо учитывать специфику платформы, тематику ресурса, формат материала.

Как проиндексировать сайт

Если вы только запустили ресурс или внесли важные изменения, важно как можно быстрее отправить страницы на индексацию. Ниже — пошаговая инструкция, как это сделать в Яндекс, Google и других системах.

Добавьте сайт в Яндекс.Вебмастер

Самый простой способ инициировать индексацию ресурса в Яндекс — воспользоваться инструментом Яндекс.Вебмастер. Зарегистрируйтесь, если у вас ещё нет аккаунта, и добавьте сайт, перейдя по ссылке: https://webmaster.yandex.ru/sites/add/. Далее система сгенерирует уникальный код подтверждения. Его необходимо вставить в блок <head> на главной странице вашего сайта — это подтвердит право собственности.

Для более полной и точной аналитики желательно подключить сервис Яндекс.Метрика. Это можно сделать в разделе «Настройки» -> «Привязка к Яндекс.Метрика». Данные Метрики помогают поисковому роботу лучше ориентироваться в структуре сайта при его обходе.

Источник: shutterstock.com

Уточнить, какие страницы уже попали в индекс, можно через меню «Индексирование» -> «Проверить статус URL». Этот инструмент покажет, был ли сайт просканирован, какие URL доступны в поиске и когда робот в последний раз посещал сайт.

В том же разделе можно загрузить карту сайта (Sitemap), настроить частоту обхода страниц и вручную запустить повторную индексацию конкретных разделов.

Регистрация ресурса в Google Search Console

Чтобы отправить сайт на индексацию в этот поисковик, необходимо воспользоваться сервисом Google Search Console. Для этого перейдите по ссылке https://search.google.com/search-console/welcome. И авторизуйтесь в системе с помощью своей Google-учётной записи.

Добавьте сайт в консоль, выбрав способ подтверждения (аналогично Яндекс). В панели вебмастера вы сможете получить доступ к детальной информации: какие страницы уже проиндексированы, какие — исключены, а также список внутренних и внешних ссылок, которые ведут на ваш сайт.

В отличие от Яндекс, Google не всегда корректно распознаёт Sitemap автоматически. Поэтому лучше сразу загрузить карту сайта вручную через соответствующий раздел. Процесс Google-переиндексации тоже менее гибкий. Надо ввести конкретный URL, дождаться его проверки и только после этого появится возможность нажать кнопку «Запросить индексирование».

Увеличим продажи вашего бизнеса с помощью комплексного продвижения сайта. Наша команда экспертов разработает для вас индивидуальную стратегию, которая позволит в разы увеличить трафик, количество заявок и лидов, снизить стоимость привлечения клиентов и создать стабильный поток новых покупателей.

Добавление сайта в прочие системы

Хотя в Рунете основные доли рынка принадлежат Яндекс и Google, другие поисковики тоже не стоит полностью игнорировать. Особенно если ваш сайт представляет значимую организацию или крупную компанию, для которой важна публичная репутация.

-

Рамблер. Поисковая система использует индексационные данные Яндекс. То есть при корректной настройке в Яндекс.Вебмастер иные действия для Рамблер не нужны.

-

Mail.ru. У него до сих пор есть собственная вебмастер-панель: https://webmaster.mail.ru/. Здесь можно отследить базовые параметры индексации, но возможности ограничены по сравнению с Яндекс и Google.

-

Yahoo.com и Bing. Интересно, что системы со временем объединились. Сейчас оба поисковика используют общую платформу для вебмастеров, доступную по адресу: https://www.bing.com/toolbox/webmaster/. Добавив сайт туда, вы автоматически обеспечите его присутствие в обеих системах.

Проверка индексации сайта

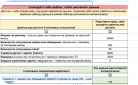

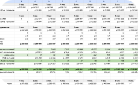

Чтобы проверить индексацию сайта, используйте эти 3 бесплатных инструмента:

-

Яндекс.Вебмастер и Search Console.

Это один из самых надёжных методов. В Яндекс.Вебмастер найдите инструмент «Проверить статус URL».

Вставьте адрес интересующей страницы и через пару минут получите информацию: присутствует ли она в индексе и когда последний раз к ней обращался поисковый робот. Иногда на обработку запроса может потребоваться немного больше времени.

В Google Search Console процесс аналогичен. В верхней части интерфейса найдите строку поиска и вставьте в неё URL нужной страницы. Система проанализирует адрес и отобразит его статус — был ли он добавлен в индекс, есть ли ошибки, когда была последняя проверка.

-

Поисковая команда «site».

Под рукой нет доступа к панели вебмастера или нужно быстро проверить индексацию в общем виде? Используйте встроенную команду поисковиков site.

Источник: shutterstock.com

Откройте Яндекс или Google и введите запрос по шаблону «site:адрес_вашего_сайта, например» (например, «site:example.com»). Вы получите список всех страниц ресурса, которые уже добавлены в базу.

-

Онлайн-сервисы для проверки индексации.

Существуют специальные платформы, которые позволяют сразу изучить множество URL-адресов на предмет наличия в индексе. Один из таких инструментов — «Серпхант». Он даёт возможность мгновенно проверить до 50 страниц одновременно в Яндекс и Google.

Достаточно вставить список ссылок в поле проверки (не забудьте указать http:// или https:// в начале каждого адреса) и нажать на кнопку «Начать проверку». Результаты по первым страницам могут появляться с небольшой задержкой, но в целом сервис работает стабильно и надёжно.

Ещё один удобный инструмент — расширение RDS Bar для браузеров Chrome, Firefox и Opera. Оно позволит прямо в момент просмотра сайта узнать, индексирована ли открытая страница, получить другую SEO-статистику в один клик.

Методы ускорения индексации сайта

-

Улучшите техническое состояние и контент.

Первым делом устраните все технические «узкие места». Убедитесь, что сайт быстро загружается, не содержит битых ссылок и доступен для пользователей с разных устройств. Контент должен быть актуальным, полезным и соответствовать поисковым запросам целевой аудитории. Чем выше качество страниц, тем больше шанс, что роботы обратят на них внимание.

-

Развивайте внутреннюю перелинковку.

Правильная структура — навигатор для поисковых ботов. Ссылки с уже проиндексированных страниц на новые материалы помогают ускорить их обнаружение.

-

Размещайте линки на свой сайт на других ресурсах.

Например, на сторонних платформах: в блогах, сообществах, комментариях, социальных сетях и тематических форумах. Когда внешние источники начинают ссылаться на ваш ресурс, поисковые роботы получают сигнал, что страница может быть ценной.

-

Откройте доступ для поисковых роботов.

Изучите содержимое файла robots.txt и наличие тега noindex на страницах. Сделать это можно через панели вебмастеров, в разделе анализа сайта — там будет информация об индексируемости и возможных ограничениях.

-

Подключите и отправьте карту сайта (Sitemap).

Sitemap — файл, который помогает поисковикам понять структуру ресурса, найти все страницы.

Источник: shutterstock.com

Итак, создайте карту с помощью специального сервиса, например, «Топвизор». Войдите в свой проект, откройте вкладку «Карта сайта» и нажмите кнопку «Сгенерировать».

Стоимость зависит от числа страниц. Например, сканирование 100 URL обойдётся всего в 5 рублей. Экспортировать карту можно в формате XML или CSV. После генерации не забудьте загрузить её в Яндекс.Вебмастер и Google Search Console.

-

Регулярно обновляйте контент на сайте.

Поисковые системы работают с краулинговым бюджетом. Это лимит на количество страниц, которые робот может проанализировать за определённое время (обычно за сутки). И чем быстрее они загружаются, чем выше активность на сайте, тем больше этот лимит. Регулярные обновления — важный сигнал для поисковых систем: если там часты перемены, значит, нужно чаще посещать.

Совет: обновляйте статьи, добавляйте новые, работайте с заголовками и описаниями.

-

Отправляйте страницы на переобход.

Если вы внесли изменения в конкретную страницу или добавили важный материал, который нужно быстро проиндексировать — используйте ручной запрос. В Яндекс это функция «Переобход страниц» в панели Вебмастера. В Google — «Инструмент проверки URL» в Search Console.

Читайте также!

Как закрыть сайт от индексации

Важно разобраться и в этом. Ниже рассмотрим, что за разделы стоит скрыть от поисковых роботов, какими способами это можно сделать.

Итак, лучше не индексировать:

-

Страницы с кодом ошибки

-

Дублирующийся контент и повторяющиеся URL.

-

Версии страниц, предназначенные для печати.

-

Вспомогательные разделы — формы поиска, входа, регистрации, админ-панель.

Кроме того, от индексации нужно скрывать все страницы, которые содержат персональные данные пользователей или иные элементы с ограниченным доступом.

Для этого есть технические решения. Вот 5 основных способов закрыть страницы от индексации.

Использование файла robots.txt

Самый распространённый способ запрета — добавить директиву Disallow в файл robots.txt, находящийся в корневом каталоге сайта. Она позволяет ограничить доступ ко всему ресурсу, отдельным разделам или конкретным страницам.

Обратите внимание! Даже если доступ к странице закрыт в robots.txt, сам URL может появиться в результатах поиска. В таком случае отобразится сообщение вроде «Владелец запретил просмотр содержимого» или «Ссылки на страницу содержат...».

Вставка метатега в HTML-код страницы

Чтобы полностью запретить индексацию конкретной страницы, можно использовать специальный тег в блоке <head>:

<meta name="robots" content="noindex">

</head>

Настройка на уровне сервера.

Более продвинутый способ — задать ограничения через конфигурационные файлы сервера. В файле .htaccess можно прописать правило, урезающее доступ, например, только для Яндекс:

SetEnvIfNoCase User-Agent «^Yandex» search_bot

Также можно задать заголовок X-Robots-Tag в HTTP-ответе. Вот такой пример, где явно указано: индексировать нельзя:

HTTP/1.1 200 OK

Date: Tue, 25 May 2010 21:42:43 GMT

X-Robots-Tag: noindex

Через CMS

Если сайт работает на системе управления контентом, индексацией можно руководить прямо из панели администратора. Так, в WordPress есть встроенные опции в настройках «Чтения». И популярный плагин Yoast SEO, позволяет гибко настраивать индексацию для каждой страницы.

В других CMS могут потребоваться расширения или ручные настройки — всё зависит от платформы.

Защита через авторизацию

Один из самых надёжных способов — ограничить доступ к странице логином и паролем. Роботы не смогут пройти авторизацию, а значит, и проиндексировать защищённый раздел.

Проблемы с индексацией сайта

Даже при внешне корректной работе ресурса страницы могут не попадать в поисковую выдачу. Ниже представлены наиболее распространённые причины.

-

Нерациональное использование краулингового бюджета. Поисковые роботы не могут бесконечно сканировать сайт. На каждую площадку выделяется краулинговый бюджет. Если на сайте много автоматически создаваемых ссылок, бесконечных циклических переходов, малополезных страниц, робот тратит этот ресурс впустую.

-

Ограничения, заданные в файле robots.txt. Он управляет доступом роботов к разделам сайта. Стоит проверить его содержимое — возможно, нужные страницы, папки случайно оказались закрытыми. Часто блокируются важные директории с изображениями, медиафайлами, даже ключевые разделы из-за директивы «Disallow:». Убедитесь, что все значимые части не запрещены к сканированию.

-

Запрет индексации в административной панели сайта. На старте проекта CMS, например WordPress, по умолчанию может быть активирована ограничивающая функция. Достаточно просто вручную отключить эту опцию.

-

Метатег robots с отключением индексации. Если в коде страницы в разделе <head>стоит тег: «noindex», «nofollow» — это означает полный запрет на нее и обход ссылок. Такой тег часто используется на этапе создания, при работе с черновиками. После их завершения его необходимо удалить, иначе страница навсегда останется невидимой для поисковиков.

-

Заголовок X-Robots-Tag с ограничениями. Иногда запрет на индексацию задаётся не в HTML-коде, а таким образом на сервере.

-

Фильтры и санкции со стороны систем. Если сайт был взломан, заражён вредоносным кодом или нарушает правила поисковиков, он может попасть под санкции. И индексация приостанавливается. Еще санкции накладывают на ресурс с неуникальным, автоматически сгенерированным или откровенно «пустым» контентом.

-

Страницы получили статус исключения. Поисковая система может сканировать такую, но не включить её в индекс, присвоив статус: «Просканировано, но не проиндексировано», «Неканоническая», «Дубликат», «Малоценный контент».Чтобы устранить это, нужно анализировать причину и вносить улучшения в ее контент или структуру.

-

Неверный код ответа сервера. Иногда страница открывается для пользователей, но для робота возвращает не тот HTTP-код — например, 403, 404, 500 вместо 200. Такое часто после перенастроек или внедрения защиты от ботов. Чтобы отслеживать эти ошибки, рекомендуется использовать инструменты мониторинга, например «Метасканер» от Rush.

Часто задаваемые вопросы об индексации сайта

Итак, мы разобрали, что такое индексация сайта. В современных условиях она происходит очень оперативно.

Как можно посмотреть, какие страницы уже находятся в базе?

Самый простой способ — использовать поисковую команду site:. Введите в строку поиска, например, «site:example.com» — и вы увидите перечень всех страниц этого сайта, которые уже учтены поисковой системой Google.

Аналогично можно проверить индекс в Яндекс. Для более точных данных воспользуйтесь сервисом xseo — введите адрес сайта, нажмите «Проверить». И система покажет, сколько страниц найдено в Google и Яндекс.

Почему проиндексированная страница может покинуть SERP?

Одна из самых частых причин — это ее автоматическое перенаправление. Если для страницы настроен редирект с кодом 301, поисковики воспринимают такой адрес как устаревший и со временем исключают его из выдачи, передавая ценность новой ссылке.

Как удалить сайт из индекса?

Самый простой способ — воспользоваться официальными инструментами. Google Search Console и Яндекс.Вебмастер предоставляют специальные разделы, где можно отправить заявку на удаление конкретной страницы или даже целого сайта из индекса.

При грамотной настройке сайта и наличии корректных файлов — таких как robots.txt и sitemap.xml — страницы могут попасть в индекс уже в течение 20—30 минут после публикации. Главное — создать все условия, чтобы поисковик легко нашёл и просканировал нужный контент.