В статье рассказывается:

- Почему так важна проверка индексации сайта

- Проверка в Яндексе и Google с помощью операторов

- Проверка с помощью инструментов Яндекса и Google

- Проверка индексации сайта с помощью букмарклетов и плагинов

- 3 лучших сервиса проверки индексации сайта

- Почему не индексируется сайт в поисковиках

-

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Те, кто только начинает разбираться в инструментах продвижения веб-ресурсов, не придают значения важности индексации своего сайта. В результате тратится много времени и средств на его разработку, а эффективность оказывается очень низкой.

Поэтому сегодня мы рассмотрим, как проводится проверка индексации сайта, а также отдельных его страниц. Кроме того, расскажем, как можно сделать процесс индексации быстрее и для чего это необходимо.

Почему так важна проверка индексации сайта

Ваш сайт будет приносить прибыль, если уровень посещаемости его будет высоким, так как только этим можно заинтересовать рекламодателей.

Большая часть посетителей сайтов переходит на них по ссылкам из поисковиков, выдаваемым после введения запроса. Роботы поисковых систем проводят сверку запроса с информацией баз данных и выдает наиболее актуальные результаты.

Источник: shutterstock.com

Попасть ресурсу в такую базу данных можно только после прохождения индексации поисковиком. Если сайт не проиндексировать или отдельные его страницы, то и потенциальный клиент никак не попадет на ваш ресурс.

Необходимо, чтобы поисковая система оперативно учитывала каждую новую страницу сайта, а не только весь ресурс. Оптимальный вариант – наличие внутренней перелинковки, обеспечивающей не только занесение новых данных в базу, но и обновление уже имеющихся по предоставляемым ссылкам.

Одним из факторов, влияющих на скорость индексации, является посещаемость ресурса. Но есть и другие.

Каждый день в Интернете появляются новые сайты, схожие по тематике с вашим. Они являются конкурентами, поскольку их контент дублирует содержимое вашего ресурса. С увеличением числа конкурирующих веб-страниц уникальность сайта падает. Причина этого – публикация в Сети материалов, представляющих собой рерайт уже имеющихся статей, поэтому так необходим учет поисковой системой уникального текста.

Также отсутствие индексации материалов сайта может стать причиной атаки ресурса мошенниками. Они могут скопировать ваш контент, выложить на своей странице и быстро проиндексировать его, таким образом заявив роботам поисковиков о своем авторстве.

Впоследствии поисковые системы будут определять ваш контент как неуникальный, и это может стать причиной бана вашего ресурса.

В связи с этим так важен контроль индексации и ускорение ее проведения, особенно для молодых сайтов, только начинающих свое продвижение.

Проверка индексации сайта в Яндексе и Google с помощью операторов

Проверка индексации сайта в Яндексе

Проверка индексации страницы сайта в Яндексе достаточно проста. Для проверки количества находящихся в индексе поисковика страниц используются такие операторы:

-

«site». Его задача – поиск и выведение полностью всех страниц, находящихся в базе данных поисковика;

-

«host». Он нужен для получения сведений о страницах, прошедших индексирование, а также о документах с доменов и поддоменов сайта.

Рассмотрим применение этих операторов на примере нашего сайта sales-generator.ru. Сначала используем оператор «site». Нужно зайти в Яндекс и в строке поиска ввести: site:sales-generator.ru. Поисковик выдает следующий результат:

Источник: ya.ru

Затем нужно использовать оператор «host». Пример приведем опять на сайте sales-generator.ru. Снова нужно зайти в Яндекс и вбить в поиск host:sales-generator.ru. Результат проверки индексации представлен на скриншоте ниже:

Источник: ya.ru

Нельзя писать служебные слова с ошибками. К примеру, когда мы вбивали в строку поиска site :sales-generator.ru, Яндекс выдавал какую-то непонятную информацию. Оказалось, ошибка заключалась в написании пробела между служебным словом и адресом ресурса. Такого быть не должно, и всю фразу нужно писать слитно.

Обратите внимание, что проверяли домен мы без www, поскольку он является главным зеркалом. Можно провести проверку индексации с помощью операторов «site» и «host» c www.

На запрос с оператором «site» поисковик выдал следующий результат:

Источник: ya.ru

Вот результат запроса с оператором «host»:

Источник: ya.ru

Выводы: как бы вы ни писали запрос, в индексе находится 24 страницы. И они выводились при каждой проверке нами. Может возникнуть вопрос: почему оператор находит 24 страницы при введении «site: sales-generator.ru»? Ответ прост: для данного оператора характерен вывод всех страниц при любом вводе запроса (как с www, так и без www). А вот оператор «host» выводит только страницы домена без www.

Проверка индексации сайта в Google

Для проверки, сколько страниц находится в индексе поисковика Google, используют оператор «site». Он позволяет узнать число страниц домена в индексе поисковой системы. При написании домена с www Google выведет страницы только для этого случая, как и при написании домена без www. Этим проверка индексации сайта в Google отличается от таковой в Яндексе.

Приведем пример. В строке поиска Google вводим: site:sales-generator.ru.

Результат система выдает следующий:

Источник: google.com

Google нашел 58 страниц в отличие от 24, найденных Яндексом.

Вобьем в поиск домен с www: site:www.sales-generator.ru. Результат будет таким:

Источник: google.com

Как и ожидалось, ни одной страницы не найдено.

Проверка индексации страницы сайта

Самый простой способ проверить индексацию отдельной страницы в Яндексе – в самом поиске. Нужно ввести в строку поиска ее адрес. При наличии страницы в индексе будет выведен ее сниппет. В Google проверяют индексацию страниц так же.

Источник: ya.ru

Проверка индексации страниц сайта с помощью инструментов Яндекса и Google

Проверка индексации сайта в Yandex Webmaster

Проверку сделать несложно: нужно в вебмастере открыть проверяемый ресурс и нажать «Проверить URL». После этого следует ввести ссылку из строки адреса браузера требуемой страницы сайта (при этом в конце необходимо обязательно поставить слеш):

После того как вы введете адрес, сервис начнет обрабатывать запрос. На это уйдет немного времени. Затем появится ссылка «Готово», на которую нужно кликнуть.

Откроется страница, на которой будет содержаться детальная информация: был ли робот на данном сайте, индексирован ли его контент и другие сведения. В случае если робот уже был на странице, выведется сообщение: «Адрес страницы уже известен роботу, но в данный момент контент страницы ещё не проиндексирован». Наличие такого ответа позволяет вебмастеру быть спокойным: индексация контента будет проведена через 1 или 2 АПА (обновления базы поиска).

Также будет доступна такая информация: есть ли на проверяемую страницу внешние и внутренние ссылки, дату последнего обхода роботом, статус индексирования.

Если же ваша страница не посещается роботом в течение длительного времени, зайдите в раздел «Помощь». Может быть, Яндекс порекомендует эффективный способ сделать процесс индексации более быстрым.

Проверка индексации сайта в Google Webmaster

Порядок проверки следующий: зайдите в «Индекс Google» -> «Статус индексирования» и выберите «Расширенные данные»:

Там вы увидите информацию о количестве проиндексированных и заблокированных в Robots.txt страниц. Однако вывод данных задерживается, и их корректность не всегда гарантирована.

Проверка индексации сайта с помощью букмарклетов и плагинов

Плагины и букмарклеты (небольшие программы на языке javascript, сохраняемые в виде закладок браузера) позволяют автоматизировать процесс проверки индексации. Их использование не требует открытия поисковых систем и ввода запроса в строку поиска.

Эту задачу выполняют плагины и скрипты:

На картинке представлен скриншот плагина RDS bar для Google Chrome. Данный плагин для Mozilla Firefox еще лучше. Он позволяет провести проверку индексации отдельных страниц и всего ресурса в целом. Есть и минус – в бесплатных версиях постоянно выскакивает капча.

Букмарклет «Проверка индексации». Сохраните ссылку в закладках, затем перейдите на проверяемый сайт и откройте закладку. В новой вкладке Google выдаст вам результаты проверки.

3 лучших сервиса проверки индексации сайта

Если способы проверки, представленные выше, дают вам не всю необходимую информацию, можете работать с онлайн сервисами. Хотя результаты их работы не всегда хороши. Иногда наблюдается большая разница в получаемых данных.

Проверку индексации сайта онлайн провести очень легко, так как сервисов представлено большое количество. Остановимся на наиболее точных:

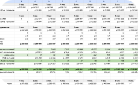

XSeo

Позволяет быстро узнать, сколько страниц содержится в Google и Яндекс. Преимущество сервиса в разделении индексов Google на главный и второстепенный (supplemental result).

Чтобы проверить сайт, нужно перейти по приведенной выше ссылке, ввести свой домен и нажать «Проверить». Результат будет такой:

PR-CY

Разработал этот сервис такой хороший и полезный форум, как PR-CY. Кроме проверки индексации можно узнать следующие параметры:

-

ТИЦ, PR;

-

находится ли сайт в каталоге Яндекса и Dmoz;

-

внешние ссылки.

Для получения результата после перехода по ссылке нужно ввести свой домен.

Сколько страниц есть в Google:

Сколько страниц в Яндексе:

Чтобы проверить нужные параметры, можно пользоваться данным сервисом. Он очень хорошо работает и прост в использовании.

Webmasters

Сервис разработан SEO-форумом. Качество его результатов хорошее. Преимущество сервиса – возможность единовременной проверки нескольких доменов. Чтобы проверить сайт, нужно совершить переход по ссылке и ввести адрес ресурса.

Почему не индексируется сайт в поисковиках

Несколько вероятных причин.

Ошибка 404

Нужно проверить действие скриптов при обнаружении ошибок. Если в сообщении скрипта об ошибке будет выдаваться код нормального завершения 200, то его индексация будет проведена. А в случае возврата скриптом кода 404 индексирования сообщения об ошибке не произойдет.

С обычными документами ситуация аналогична. Есть серверы, в настройках которых при обнаружении ошибки предусмотрено отправление сообщения, содержащего код нормального завершения 200. При этом робот не может провести удаление ссылки на сайт в базе данных. Современные серверы предусматривают возможность изменения стандартных сообщений об ошибках и исправления их кода.

Спам

Спам – это заголовки, ключевые фразы, состоящие из слов, формирующих наиболее частые запросы; объемные тексты, цвет шрифта которых совпадает с цветом фона, либо шрифт очень мелкий. Есть и другие виды спама. Их объединяет одна цель – обмануть посетителя с целью завлечь на свой ресурс.

Спамом не стоит пользоваться. Во-первых, потому что это нехорошо и посетителей сайта только раздражает. А во-вторых, потому что Яндексом предусмотрено отслеживание таких недобросовестных действий и снижение позиций документа в поисковой выдаче.

Также применение спама обусловливает увеличение размера документа, уменьшение контрастности слов в нем. Это тоже негативно сказывается на позициях его. Сайты и страницы злостных нарушителей Яндекс может вовсе исключить из базы.

Если одна страница перенаправляет пользователя на другую мгновенно (время перенаправления равно 0), то ее тоже исключат из индексирования.

Яндекс-поиск не помогает раскручивать сайты, его задача – удовлетворить потребности посетителей в нужных ему сведениях. Тем не менее, раскрутить сайт в Яндексе можно, разместив там рекламу.

Неправильные даты

Яндекс позволяет искать и сортировать материалы по датам, однако информация о дате изменения их правдива лишь в 80 % случаев. Сервер нужно настраивать правильно. Обеспечьте посетителям доступ к дополнительным сведениям и корректный показ своих страниц при поиске по датам.

Дополнительные данные высылаются в «заголовках HTTP» веб-сервером непосредственно с HTML-документом. Там может содержаться информация о том, когда был последний раз изменен документ (в заголовке "Last-Modified»). Наша настоятельная рекомендация – настройте ваш веб-сервер таким образом, чтобы эта дата высылалась им. Может быть, для этого понадобится немного исправить скрипты CGI или ISAPI, которые вы используете.

Неправильная кодировка

Помимо HTML-документа в сообщении веб-сервера содержатся дополнительные данные в «заголовках HTTP». К примеру, кодировка документа указывается в заголовке "Content-Type", параметр charset:

Content-Type: text/html; charset=windows-1251

или:

Content-Type: text/html; charset=koi8-r

Обязательно указание веб-сервером кодировки всех не англоязычных документов. В случае отсутствия кодировки потребуется ее установка в браузере самим пользователем, что влечет за собой неудобства. Если конфигурацию сервера исправить, он будет присылать кодировку.

Индексирование одинаковых документов в разных кодировках

Если web-серверы выдают одинаковые документы в разных кодировках, то расход ресурсов при их индексации очень большой. В базах данных отечественных поисковиков документы хранятся в одной кодировке. Рекомендуется использовать для индексации только одну кодировку.

Если выдача кодировок осуществляется по портам сервера, то на разных серверах/портах нужно выдавать разный robots.txt. То есть в каждом сервере/порту нужно дополнительно прописывать:

user-agent: *

disallow: /

Если выдача кодировок осуществляется по директориям, то понадобится единственный файл robots.txt, в котором следует написать:

user-agent: *

disallow: /alt

disallow: /mac

disallow: /koi

Индексирование одного сайта на разных серверах

Возникновение проблемы возможно при наличии у сервера зеркал либо в случае получения кодировок путем изменения префикса в имени хоста. К примеру, кодировки для хоста www.chto-to.ru могут быть следующими: win.chto-to.ru, koi-www.chto-to.ru, wwwmac.chto-to.ru и т.д. Определить, какой из этих адресов основной, робот не может. Он лишь видит, что есть два полностью совпадающих документа и проводит индексацию одного из них.

То есть не исключена ситуация, что индексирование вашего контента будет проведено на разных хостах. Чтобы проиндексировать ресурс по одному адресу, нужно задать соответствующий файл robots.txt. Через определенное время прошедшие индексацию документы будут ссылаться на нужный адрес.

Не рекомендуется открытие для роботов поисковых систем контента вашего ресурса под разными именами или портами. Добиться улучшения индексации вам не удастся. Сервер будет испытывать нагрузку, как и сеть. Это может привести к негативным последствиям.

К примеру, поисковикам не всегда понятно, какое из «зеркал» вашего сайта основное. Они могут остановить свой выбор на любом. В настройках некоторых поисковиков предусмотрено и вовсе удаление сайтов, контент которых идентичен.

Избежать этой проблемы можно, запретив при написании вашего сайта robots.txt индексировать любые адреса, не являющиеся основными.

Для выявления имеющихся ошибок рекомендуем провести аудит сайта. Мы проведем для Вас полный анализ ошибок внутренней и внешней оптимизации ресурса, а также предоставим 47+ рекомендаций по увеличению посещаемости и продаж с Вашего сайта.