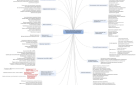

В статье рассказывается:

- Страница выпала из индекса - что это значит

- Выпадения страницы из индекса из-за некачественного контента

- Основные причины выпадения страниц из индекса Яндекса

- Другие 10 распространенных причин выпадения страницы из индекса поисковиков

- 7 неявных причин выпадения страницы из индекса

- Фичи, приводящие к выпадению страницы из индекса

- 4 способа вернуть статьи в индексацию Google и Яндекс

-

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Страница выпала из индекса поисковых систем – частое явление, от которого не застрахован ни один сайт. Причин может быть множество: от банальных технических ошибок в коде до злонамеренных действий конкурентов.

Чтобы понять, почему страница больше не индексируется, необходимо воспользоваться встроенными инструментами поисковиков. О том, почему страницы выпадают из индекса, и как снова вернуть «доверие» Гугла и Яндекса, вы узнаете из нашего материала.

Страница выпала из индекса – что это значит

Одним из наиболее важных этапов продвижения сайта является мониторинг процесса индексации. Регулярное отслеживание позволит вовремя заметить, что страницы перестали индексироваться, и, после выявления причины выпадения из индекса, предотвратить падение органического трафика.

Для начала разберемся, как устроены поисковые системы. Мы привыкли вводить запрос и получать мгновенный результат. Значит ли это, что поисковик за доли секунды обшаривает все ресурсы сети, чтобы найти релевантный ответ? Конечно, нет, он подбирает подходящие страницы из собственных баз данных – индексов. За их регулярное обновление отвечают поисковые роботы – специальные компьютерные алгоритмы, отслеживающие появление в сети новых материалов.

Если сайт недоступен для сканирования из-за пиковой нагрузки на сервер или по другой причинам, поисковый алгоритм может сделать вывод, что ресурс больше не существует, и сообщить об этом головному серверу поисковика. Чтобы данные о якобы неработающем сайте не занимали место, их удаляют из индекса.

Представьте, какие убытки ожидают интернет-магазин, если робот посчитает, что ресурс прекратил свое существование. За время простоя покупатели уйдут к конкурентам, и убедить их вернуться будет очень непросто.

Для некоммерческих сайтов выпавшие из ресурса страницы влекут за собой такие неприятные последствия, как уменьшение числа посетителей и проседание ресурса в поисковой выдаче. Если учесть, что на раскрутку сайта тратится немало сил и средств, скатиться вниз всегда обидно, восхождение к топовым позициям придется начинать с нуля.

Выпадения страницы из индекса из-за некачественного контента

Чаще всего причиной прекращения индексации становится контент низкого качества. Такие страницы попадают под фильтры АГС Яндекса и Panda Google.

Источник: Rawpixel.com / shutterstock.com

Санкции применяются к содержанию сайта, не отличающегося высокой уникальностью или нарушающему авторские права.

-

Даже если вы создаете материалы для своего ресурса самостоятельно, вы не застрахованы от выпадения из индекса за неуникальный контент. Дело в том, что ваши статьи и ролики могут быть украдены и размещены на сайтах, имеющих больший траст, в результате чего поисковый робот ошибочно считает такой ресурс первоисточником, а ваш удаляет из индекса за плагиат.

-

Использование материалов, защищенных авторским правом, – еще один повод для поисковика перестать индексировать страницы в ответ на жалобу законных обладателей прав.

-

Иногда вы сами являетесь виновником появления неуникального контента. Например, Wordpress генерирует дубликаты страниц с разными адресами. Для запрета их индексации применяют robots.txt или добавляют в раздел head страницы тег link с атрибутом rel=»canonical», указав адрес оригинала.

-

Неуникальность страниц и последующее удаление из индекса могут стать результатом использования идентичной структуры и содержания виджетов в сайдбарах на всех страницах, если при этом смыслового контента на них крайне мало. Для поискового алгоритма это повод убрать такой сайт из базы данных.

Поисковая система видит свое предназначение в максимально точном и быстром ответе на запрос пользователя. Наличие в индексе нескольких страниц с идентичным содержанием затрудняет этот процесс, поэтому лишние безжалостно удаляются. Если при создании контента вы пользовались источниками из сети, вы находитесь в зоне риска: робот может прекратить индексацию сайта с заимствованными статьями.

Проверка уникальности текстов перед их размещением на ресурсе – обязательный шаг, который позволит избежать неприятных последствий. Воспользуйтесь любым из доступных каждому сервисов:

-

text.ru

-

content-watch.ru

-

eTXT.ru

-

advego.ru

Показатели уникальности в пределах от 75 до 90 % сводят к минимуму риск попадания страницы под фильтр поисковика. Есть и другие уловки создателей контента, за которые можно выпасть из индекса:

-

искусственная генерация текстов при помощи синонимайзеров;

-

размещение материалов с большим количеством ошибок;

-

невидимый пользователям фрагмент текста.

Источник: GaudiLab / shutterstock.com

Рерайт статей, уже размещенных на других ресурсов, не запрещен, если в процессе работы над собственным вариантом не только соблюдены требования к высокой уникальности, но и серьезно изменена структура исходного текста.

Основные причины выпадения страницы из индекса Яндекса

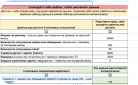

Поисковая система Яндекса может исключить сайт из своей базы данных вследствие разных факторов. Определить причины в каждом конкретном случае поможет переход в Вебмастер, где на странице Индексирование → Страницы в поиске надо выбрать Исключенные страницы.

|

Причина исключения страницы |

Решение |

|

Признание страницы малоценной или маловостребованной |

Поисковый робот посчитал, что такая страница не будет интересна пользователям, поскольку на ней нет контента или она является дублем страницы, включенной в индекс ранее. Решение алгоритма не является окончательным: при следующем автоматическом сканировании он может изменить свое мнение. |

|

Ошибка при загрузке или обработке страницы роботом — если ответ сервера содержал HTTP-статус 3XX, 4XX или 5XX |

Для выявления такой ошибки применяется инструмент Проверка ответа сервера. Убедившись, что страница доступна для робота, проверьте: есть ли информация о страницах в файле Sitemap; закрывают ли запрещающие директивы Disallow, noindex и HTML-элемент noindex от индексирования только служебные и дублирующие страницы в файле robots.txt. |

|

Индексирование страницы запрещено в файле robots.txt или с помощью метатега с директивой noindex |

Запрещающие директивы необходимо удалить. Если запрет в файле robots.txt выполнен не вами, для выяснения обстоятельств придется обратиться к хостинг-провайдеру или регистратору доменного имени Кроме того, убедитесь, что не истек срок регистрации доменного имени, следствием чего является его блокировка. |

|

Робот перенаправляется на другие страницы |

Проверьте, должна ли исключенная страница перенаправлять пользователей, при помощи инструмента Проверка ответа сервера. |

|

Страница дублирует содержание другой страницы |

При ошибочном присвоении странице статуса дубля следуйте указаниям в разделе Дублирование страниц. |

|

Страница не является канонической |

Убедитесь, что страница действительно должна перенаправлять робота на URL, указанный в атрибуте rel="canonical". |

|

Сайт признан неглавным зеркалом |

Если сайты объединены в группу по ошибке, следуйте рекомендациям в разделе Расклейка зеркал сайта. |

|

На сайте обнаружены нарушения |

Чтобы исправить их, перейдите в Вебмастере на страницу Диагностика → Безопасность и нарушения. |

Как и другие поисковые системы, Яндекс время от времени вносит изменения в работу своих алгоритмов. В результате выдача по одному и тому же запросу может стать принципиально иной, чем до обновления. Естественно, на полное внедрение изменений потребуется время.

Резкое проседание сайта в выдаче – не повод для паники. Вполне возможно, что Яндекс улучшает алгоритм поиска, поэтому происходит переоценка рейтинга ресурсов. Информацию об этом можно найти на специализированных форумах для вебмастеров, например, Searchengines и MFC.

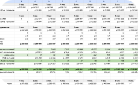

из разных ниш с ростом

от 89% до 1732%

Если страница выпала из индекса Яндекса по причине перестройки поискового робота, помогут следующие действия:

-

Определить, в чем заключается изменение алгоритма;

-

Понять, что именно не понравилось ему на вашем сайте;

-

Посмотреть, какие ресурсы выходят в топе выдачи по вашим основным ключевым словам;

-

Изучить сайты из топ-списка и подкорректировать свой контент.

Извещать веб-мастеров о том, что в работу алгоритма внесены изменения, Яндекс не считает нужным. Вы можете сделать соответствующие выводы, опираясь на косвенные признаки или почерпнув информацию на специализированных форумах.

Исключенные из поиска страницы регулярно сканируются роботом, и перед каждым обновлением базы специальный алгоритм оценивает возможность их возврата в индекс. Установив причину, по которой ваш сайт был перестал индексироваться, оправьте страницы на переобход, тем самым проинформировав робота о внесении изменений.

Другие 10 распространенных причин выпадения страницы из индекса поисковиков

Дубли страниц

Конструкция site:vashsite.com позволит вам проверить, сколько ваших идентичных страниц, расположенных по разным адресам, видит Яндекс.

Причин появления дублей может быть несколько. К примеру, несколько вариантов сайта:

-

http://vashsite.com/url-stranitsy/ и https://vashsite.com/url-stranitsy/;

-

http://vashsite.com/url-stranitsy/ и http://vashsite.com/url-stranitsy (без слэша в конце);

-

http://vashsite.com/url-stranitsy/ и http://www.vashsite.com/url-stranitsy/.

Вторая причина – изменение URL страницы при сохраненном предыдущем, с которого не проставили 301 редирект. Иногда добавляется, изменяется или удаляется префикс категорий, вследствие чего в индексе фиксируются варианты адреса:

-

http://vashsite.com/kak-sdelat-krovlyu и http://vashsite.com/kak-sdelat-kryshu;

-

http://vashsite.com/remont/kak-sdelat-krovlyu и http://vashsite.com/kak-sdelat-krovlyu.

Наиболее распространенные причины дублирования страниц мы назвали, но иногда приходится сталкиваться с более сложными случаями.

Дубли могут появиться в процессе использования CMS (системы управления содержимым сайта). Для избавления от них рекомендуется:

-

Настроить CMS так, чтобы исключить дальнейшее генерирование дублей.

-

Настроить 301 редирект со страницы-дубля на основную страницу.

-

Добавить дублю метатег (в блок <head>), ведущий на основную страницу: <link rel="canonical" href="https://URL сайта/1.html"/>.

Процесс накапливания дублированных страниц может быть довольно продолжительным, и пока их немного, Яндекс не придает поэтому большого значения. Однако в один «прекрасный» момент вы можете отметить сильное проседание своего сайта из-за большого количеств дублей.

Использование неуникальных сниппетов

Частая ошибка веб-мастеров – отсутствие уникального сниппета. Проблема особенно актуальна для интернет-магазинов, агрегаторов и автонаполняемых сайтов, где вместо дескрипшна и уникального тайтла подтягивается Title или Description главной страницы.

Источник: GaudiLab / shutterstock.com

Поначалу Яндекс может это игнорировать, но с увеличением числа таких страниц возрастает риск того, что сайт попадет под фильтр или просядет в выдаче. Решается проблема запретом на подтягивание мета-данных главной страницы.

главным признаком того, что страница выпала из индекса по этой причине, служит потеря позиций по основным запросам. После замены текущего описания на уникальное можно надеяться на исправление ситуации.

При отсутствии возможности прописать уникальный тайтл или дескрипшн их можно подтягивать: Title – из заголовка H1, а Description – из начала статьи или описания товара. Для SEO это не лучший вариант, но такое решение избавит вас от риска попасть под фильтр.

Переоптимизация

Продвижение сайта требует качественной SEO-оптимизации, однако очень часто в стремлении нарастить трафик создатели ресурса забывают о пользователях – главных «потребителях» контента. Если в текстах есть явный перекос в сторону ориентации под интересы поисковых систем, сайту грозят санкции от фильтров Баден-Баден Яндекса и Panda Google. Чтобы свести вероятность прекращения индексирования по этой причине, ключевые слова используют только в теле статьи, по возможности избегая их попадания в метатеги.

Если страница выпала из индекса из-за переоптимизации, перепроверьте контент, чтобы обнаружить переспам, и внесите коррективы в те места, где ключи вписаны грубо, с нарушением логики предложения или абзаца.

Конечно, запросы пользователей иногда выглядят очень коряво, и употребить их в статье так, чтобы они полностью растворились в ткани текста, под силу только очень хорошим копирайтерам.

Некачественные обратные ссылки

Польза некоторых обратных ссылок довольно сомнительна, и нередко именно некачественный ссылочный профиль является причиной того, что страницы выпадают из индекса. Не секрет, что количество и качество обратных ссылок для поисковой системы служит один из параметров для определения авторитетности сайта. Чтобы улучшить показатели, SEO-специалисты нередко накручивают ссылки, но Яндекс и Google давно разработали средства борьбы с этим явлением – фильтры Минусинск и Penguin.

Более частым последствием злоупотребления обратными ссылками становится ухудшение позиций сайта в поисковой выдаче. Тем не менее, работа с линкбилдингом требует аккуратности и умеренности.

Ошибки в robots.txt

Основная функция это файла – показать поисковому краулеру, какие директории или страницы следует индексировать, а какие нет. Ошибки веб-мастеров в robots.txt приводят к выпадению ресурса из базы данных. Чтобы понять, где находятся недочеты, зайдите в Яндекс.Вебмастер: Индексирование => Структура в поиске => Исключенные страницы. Текст «При обращении к странице роботу не удалось получить ее содержимое» подтверждает, что страница исключена из индекса по причине ошибок в файле robots.txt.

Источник: Gorodenkoff / shutterstock.com

Не лишним будет проверить метатеги. Причина удаления сайта из базы может крыться в HTML-тегах. Например, тег Meta Refresh плохо отражается на индексировании страниц в Google.

Смена URL

При смене URL страница перестает индексироваться по старому адресу. Если ниша высококонкурентная, на возврат страниц на прежнюю позицию может потребоваться много времени, поэтому, меняя URL, позаботьтесь о настройке 301 редирект со старого адреса на новый.

Аффилированность

Еще одной причиной выпадения из индекса может быть признание сайта аффилиатом. Поисковые системы придерживаются принципа разнообразия выдачи и не допускают присутствия в ней двух сайтов одной и той же компании, которые продвигаются по идентичным ключевым словам. Признаком аффилированности являются в том числе одинаковые контактные данные.

Продажа ссылок

Накрутка SEO-параметров в любой форме жестко пресекается всеми поисковыми системами.

Источник: Gorodenkoff / shutterstock.com

Часто страницы выпадают из индекса из-за агрессивной продажи ссылок, которой злоупотребляют новички. Начинающие веб-мастера стремятся заработать на свежем сайте, н невольно создают угрозу его уничтожения.

Бесконтрольное размещение ссылок на посторонние ресурсы чревато санкциями поисковых систем, вплоть до удаления страниц из базы данных.

Продажа ссылок на молодых сайтах, которые созданы не более 6 месяцев назад, приводит к тому, что такие ресурсы быстро попадают под фильтр Яндекса АГС.

От риска остаться с единственной страницей в индексе не застрахованы и «старые» сайты, на которые ссылаются многие авторитетные ресурсы. Агрессивной продажей считается появление за неделю хотя бы по одной внешней ссылке на 50 % страниц ресурса.

Для выхода из-под этого фильтра понадобится много времени, при этом нельзя быть уверенном в 100-процентном результате. Выход один – не размещать на сайте платные ссылки. Если это необходимо, закройте ее атрибутом nofollow.

Страница может вернуться в индекс только после полного очищения от продажных ссылок.

Вредоносный код на сайте

Поисковик не разбирается, как именно появился на сайте вредоносный код, в результате взлома или по воле веб-мастера. Санкции будут наложены в любом случае.

Некачественный хостинг

Поводом для удаления сайта из выдачи может послужить частое появление ошибки 404. Чаще всего в этом виноваты хостинг-провайдеры, предоставляющие некачественные услуги. Следите за скоростью загрузки страниц и доступностью для их сканирования поисковым роботом.

7 неявных причин выпадения страницы из индекса

-

Злоумышленные причины

Неуникальный контент, переспам, покупка и продажа ссылок – все это может стать поводом для санкций поисковых систем, но относится к числу решаемых проблем. Гораздо хуже, когда против вашего сайта ополчились конкуренты. Их происки способны довести до полного бана, когда ресурс будет навсегда удален из базы данных.

Источник: vectorfusionart / shutterstock.com

Например, соперники обращаются за помощью к хакеру, чтобы тот взломал сайт и установил однопиксельные ссылки на его страницах, незаметные ни для посетителей, ни для владельца ресурса. При этом поисковая система обнаруживает, что на сайте ведется активная торговля ссылками, и удаляет его из индекса.

Объектом хакерских атак может стать и сервер хостинг-провайдера, вследствие чего на ресурс не могут попасть ни роботы, ни посетители.

-

Сайт не обновляется

Страницы выпадают из индекса, если на них редко заходят пользователи или если контент давно не обновлялся. Такой ресурс считается заброшенным, поэтому поисковик считает нецелесообразным тратить на него драгоценное место в базе данных.

-

Глюки поисковых систем

Поисковые машины постоянно совершенствуются, что не мешает появлению серьезных сбоев в их работе минимум раз в полгода. Заметив проблемы с индексацией сайта, посетите специализированные форумы, где такие ситуации обычно активно обсуждаются. Как правило, через несколько дней все приходит в норму.

В службе поддержки Яндекса и Google можно узнать, по какой причине выпала страница из индекса, однако обращаться к ним слишком часто не стоит.

Есть специальные пинг-сервисы, благодаря которым владелец сайта мог своевременно узнать о прекращении индексации. Эти службы регулярно мониторят состояние ресурса и оповещают собственника при помощи email или SMS.

-

Накрутка поведенческих факторов со стороны

Начиная с марта 2020 года владельцы многих ресурсов стали фиксировать рост переходов из социальных сетей и с других сайтов. Особенность трафика заключается в том, что пользователи приходят со страниц, принадлежащих:

-

банкам;

-

государственным организациям;

-

крупным СМИ;

-

учебным заведениям.

При этом никаких ссылок на ваш сайт там не содержится, речь идет о накрутке поведенческих факторов. Методы борьбы с этим явлением пока не определены, каждый собственник ресурса ищет собственные пути выхода из ситуации. Накрутку сайта можно определить, изучив переходы по ссылкам и из соцсетей.

Источник: ilikeyellow / shutterstock.com

Взрывной рост трафика не из поисковых систем говорит о том, что ваши страницы атакованы недоброжелателями. Результатом накрутки поведенческих факторов (ПФ) может стать резкое снижение позиций сайта, в том числе вылет из топ-10. Яндекс предпринимает такие меры, заподозрив ваш ресурс в:

-

искусственной накрутке ПФ;

-

в скупке ссылок;

-

падении показателей ПФ (высокий процент отказов, небольшое время и глубина просмотра).

Если самостоятельно разобраться в причинах проседания в выдаче Яндекса или Google, стоит обратиться за помощью к специалистам.

-

-

Неправильное SEO-продвижение

Пользуясь сленгом специалистов, SEO-продвижение сайтов бывает белым, серым и черным. Понятно, что рекомендуется применять исключительно белые методы, разве что с небольшим серым оттенком.

-

Белое SEO (White Hat SEO) – продвижение сайта, при котором не используются никакие запрещенные технологии;

-

Серое SEO – методики, допускающие манипуляции с выдачей, но не влекущие наложение санкций со стороны поисковика;

-

Черное SEO (Black Hat SEO) – способы, дающие кратковременный результат, но чреватые отправкой вашего сайта в долгий бан.

От использования серых методик лучше тоже отказаться: вполне возможно, что очередное обновление алгоритмов или усовершенствование фильтров Баден-Баден и Минусинск переведет их в черную категорию.

Черное SEO – любимый вариант веб-мастеров, не настроенных на длительное и успешное продвижение, а стремящихся к максимуму трафика за ограниченный период. Этими методами грешат SEO-агентства второго эшелона, которые хотят продемонстрировать заказчикам быстрый результат.

-

-

Порноссылки

Если страница выпала из индекса, и это сопровождается появлением большого количества внешних ссылок, в первую очередь определит источники переходов. Ваши конкурентов могли разместить ссылки на ваш сайт на порнографических ресурсах. Модераторы на таких площадках не утруждают себя работой, поэтому в комментариях можно писать все что угодно.

Советуем обратиться в поддержку Яндекса, к Платону Щукину, с просьбой снять санкции с вашего сайта вручную. Возможно, на это потребуется время, но результат гарантирован.

-

Манипуляция капчой

Капча повсеместно применяется при вводе данных, однако можно встретиться и с ее использованием для накрутки поведенческих факторов. Хотите увидеть изображение или перейти на следующую страницу – вводите капчу.

Источник: Tero Vesalainen / shutterstock.com

Все дело в том, что поисковые системы выше оценивают ресурсы, на которых пользователи совершают какие-либо действия. Captcha – наименее затратный для веб-мастеров способ заставить посетителя сайта взаимодействовать со страницей.

Мгновенные санкции за применение капчи не наступят, но с временем ресурс может серьезно просесть в выдаче. Для реального, а не фиктивного улучшения поведенческих факторов стоит поработать над контентом, чтобы вызвать у пользователей желание контактировать с сайтом без принуждения.

-

Push-уведомления

Реклама при помощи пуш-уведомлений уже не так эффективна, как несколько лет назад, но некоторые ладельцы сайта не отказываются от этого способа получить дополнительный доход. Яндекс относится к push нейтрально, но при отдельных нарушениях к ресурсу могут быть применены санкции. Это происходит в следующих случаях:

Источник: Elle Aon / shutterstock.com

-

Согласие на получение уведомлений получено не вполне законно;

-

Пользователь теряет доступ к сайту, пока не оформит подписку на пуш;

-

Владелец ресурса проявляет излишнюю настойчивость, многократно направляя предложение о подписке.

Если вы обнаружили, что на вашем сайте включена система push-уведомлений, причем сделано это без вашего ведома, скорее всего, речь идет о взломе. Это один из распространенных способов внедрить вредоносный код. Для его поиска и удаления воспользуйтесь одним из плагинов защиты от вирусов и вредоносного ПО. Не получается решить эту проблему самостоятельно – обратитесь к специалистам.

-

-

Неправильная реклама

В целом Яндекс ничего не имеет против рекламы, хотя среди сеошников бытует мнение, что ее избыток негативно сказывается на ранжировании сайта. Доля правды в этом есть, но если рекламные блоки размещены правильно, их большое количество не становится причиной снижения позиций в выдаче.

Это не значит, что можно смело вставлять рекламный баннер после каждого абзаца. Такая навязчивость не понравится пользователям, они будут покидать страницы, тем самым ухудшая поведенческие факторы ресурса.

Можно выделить несколько рекламных форматов, из-за активного использования которых сайт может потерять топовые позиции. Это:

-

PopUnder – когда одновременно со страницей открывается отдельное окно с рекламой, расположенное за окном браузера;

-

ClickUnder – реклама или сайт открываются в новой вкладке браузера, после клика пользователя в текущей вкладке;

-

PopUp – всплывающее в той же вкладке окно с рекламой.

Злоупотребление такими рекламными форматами может стать причиной выпадения страницы из индекса. При том, что формального запрета на их применение нет, алгоритм Яндекса относит PopUnder, ClickUnder или PopUp к назойливым способам продвижения товаров и услуг. Кроме того, запрет на индексацию сайта может быть наложен асессорами вручную.

Владельцы ресурсов, размещая рекламу в таких форматах, должны быть готовы к внезапному обвалу позиций в выдаче. Это может произойти спустя несколько месяцев безнаказанного применения PopUnder, ClickUnder или PopUp в результате попадания под фильтр алгоритма или плохого настроения одного из асессоров.

-

-

Майнинг криптовалюты

Идея использовать мощности посетителей для добычи криптовалюты появилась пару лет назад и одно время была очень популярной. Многие начали устанавливать на сайтах криптомайнеры – специальные программы, позволяющие заработать на генерировании криптомонет.

Надежным и высокоприбыльным такой вид заработка назвать сложно, однако отдельные порталы до сих пор не отказываются от использования криптомайнеров. Google относится к ним нейтрально, а вот позиция Яндекса однозначна: майнинг криптовалюты – это обман посетителей сайта, и за это надо наказывать.

Установить скрипт на ваш сайт можно и без вашего ведома. Частые варианты:

-

встраивание майнера администратора сайта;

-

внедрение через обнуленный и сомнительные плагины;

-

путем взлома сайта.

-

-

Кликджекинг

Еще одна мошенническая технология, благодаря которой от пользователя добиваются совершения действий без его ведома. Речь может идти о вступлении в сообщества и группы соцсетей, о передаче персональных данных, оформлении подписок и совершении покупок.

Борьба с кликджекингом ведется Яндексом с 2016 года. Если ваш сайт заподозрен в применении этой технологии, вы получите соответствующее уведомление в Вебмастере, а позиции ресурса резко упадут. Это особенно неприятно, если вы не имеете никакого отношения к обману, а просто получили скрипт одним из возможных способов:

-

через зараженные темы и плагины;

-

вместе со скриптами сторонних разработчиков;

-

от вирусов и вредоносного ПО;

-

в результате прямой установки на FTP-сервер.

-

-

Вирусы и малвер

Ни один сайт не застрахован от риска подхватить вирус. Кроме того, недоброжелатели могут внедрить вредоносные файлы и скрипты. Для Яндекса любой заражение – сигнал к понижению позиций такого ресурса.

Поймать вирус можно одним из трех способов:

-

через компьютер администратора;

-

в результате хакерской атаки;

-

из-за уязвимости в темах, плагинах, ядре WordPress.

Плагины безопасности серьезно снижают риск заражения, поэтому их использование обязательно.

-

-

Ложная тревога

Яндекс может принять за вирус или вредоносную программу совершенно безопасный код, применяемый в некоторых плагинах. Для робота это железный повод применить фильтр и убрать страницу из индекса. Например, такое случается с плагином показа изображений.

Чтобы выявить плагин, послуживший причиной наложения санкций, скачайте сайт на свой компьютер и просканируйте Aibolit (https://revisium.com/ai/). Анализ покажет место нахождения потенциально зараженных файлов, а также их принадлежность к определенному плагину или теме.

Далее выбираете одно из возможных действий:

-

отказ от плагина;

-

его откатка до предыдущей безопасной версии;

-

ожидание обновления плагина.

-

-

Информация и коммерция

Для поисковой системы Яндекс все ресурсы делятся на два типа – информационные и коммерческие. При формировании ленты выдачи алгоритм учитывает специфику запроса. Если вы на своем сугубо информационном сайте разместили статью под ключ типа «купить кирпич в Саратове», ранжироваться она будет ниже, чем такие же материалы с коммерческих сайтов.

Иногда Яндекс самостоятельно принимает решение о переводе ресурсов из информационных в коммерческие и наоборот. Например, вы открыли интернет-магазин товаров для сада и одновременно ведете блог, в котором даете рекомендации по ландшафтному дизайну. Алгоритмы Яндекса могут определить в качестве основного информационное направление вашего ресурса и ранжировать его исходя из этого решения.

С определением таких изменений возникают трудности. Придется тщательно мониторить позиции сайта отдельно по коммерческим и информационным запросам. В результате можно обнаружить, что ресурс гораздо лучше ранжируется как информационная платформа, хотя ваша главная цель – продавать. Следовательно, необходимо уделить больше внимания коммерческой направленности сайта, чтобы Яндекс поменял свое решение.

-

Присутствие в индексе аналогичной статьи автоматически приведет к тому, что алгоритм поисковика именно ее будет считать первоисточником, а вашу, вылетевшую из базы, - копией.

-

Статье придется проходиться индексацию и ранжирование заново. Никто не гарантирует, что она вернется на те же позиции, которые занимала до санкций.

-

Изменение адреса

Не секрет, что поисковики лучше индексируют свежий контент. Самый простой способ, надо вернуть в индекс единичную страницу, – присвоение ей нового адреса и установка редирект 301 со старого адреса, чтобы сохранить нормальную работу ссылок и передачи веса с внешних ресурсов.

-

Корректировка содержания

Полностью переписывать статью не надо, достаточно добавить одно предложение, чтобы движки изменили значение оператора modified, а поисковики получили сигнал к повторной проверке материала. Для робота это будет совершенно другая статья, которую он проиндексирует ранжирует.

Далее расскажем о том, как вернуть статью в Яндексе и Гугле по отдельности. Дело в том, что страницы крайне редко выпадают сразу из обеих поисковых систем. Кроме того, методы возврата серьезно отличаются.

-

Возврат страницы в индекс Яндекса

Берем сервис GetBot и присылаем быстробота Яндекса на сайт. Спустя 10 минут статья появится в индексе от быстробота, а через пару недель – в основном индексе. Других вариантов нет. Правда, можно купить ссылку на супертрастовом ресурсе и организовать по ней несколько переходов (с хорошей активностью).

-

Возврат страницы в индекс Google

Если фид настроен, никаких мер предпринимать не придется. В противном случае займемся настройкой фида. Статья с новым адресом автоматически будет отправлена куда надо и через 2–3 дня появится в основной выдаче.

-

Ссылки должны быть сугубо тематическими. Пишете про рыбалку – не размещайте ссылки бьюти-тематики, как бы хорошо за них не платили. Это чревато снижением траста и может спровоцировать удаление страниц из индекса.

-

Добавляйте ссылки в статьи объемом не менее 2 тысяч символов. При этом очень важно, чтобы ее текст был релеванте анкору ссылки. Недопустимо писать о строительстве дома своими руками, а ссылаться при этом на «как похудеть за неделю без диет».

-

Избавьтесь от дублей, используя robots.txt. Помните, что статьи со ссылками не слишком хорошо воспринимаются поисковиками, а наличие дублей еще больше портит ситуацию.

-

Не забывайте о перелинковке страниц. Это помогает всегда держать их в поле зрения робота, о они не будут погружаться в нижние уровни вложенности.

-

Чередуйте статьи со ссылками и без них. Это положительно скажется на трасте.

Фичи, приводящие к выпадению страницы из индекса

4 способа вернуть статьи в индексацию Google и Яндекс

Итак, вы столкнулись с резким падением позиций и обнаружили, что страница выпала из индекса. Для начала важно уяснить, что:

Источник: fizkes / shutterstock.com

На самом деле авторство закрепляется за сайтом, впервые опубликовавшим спорный контент. Но будет ли робот разбираться, какой из идентичных материалов стоит размещать выше другого в выдаче, – большой вопрос.

Теперь поговорим о непосредственном возвращении страниц в индекс.

Напоследок несколько слов о том, как защитить свой ресурс от выпадения страницы из индекса поисковых систем:

Чтобы вам не пришлось постоянно констатировать, что ваши страницы выпадают из индекса, уделяйте достаточно внимания технической стороне работы над сайтом и вовремя устраняйте обнаруженные недочеты. Информационным ресурсам можно посоветовать с осторожностью использовать рекламные блоки, а платформам для электронной коммерции лучше вообще обойтись без них. Забудьте о таких методах, как клоакинг, дорвеи и кликджекинг – рано или поздно поисковик применит санкции. Единственно верный путь – наполнять сайт качественным востребованным контентом, ориентированным на людей.

Изображение в шапке статьи: McLittle Stock / shutterstock

Оставить комментарий

Оставить комментарий