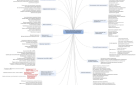

В статье рассказывается:

- Как происходит индексация сайта в поисковых системах

- Что необходимо сделать для начала индексации нового сайта

- Как ускорить индексацию сайта

- Еще несколько советов по ускорению индексации сайта и не только

- Анализ индексации сайта

- Проверка индексации сайта в «Яндексе»

- Проверка индексации сайта в Google

- Подробнее о Google-индексации сайта

- 3 эффективных инструмента проверки индексации сайта

- Почему сайт не индексируется

- 14 распространенных ошибок, мешающих быстрой индексации сайта

-

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Чек-лист: Как добиваться своих целей в переговорах с клиентамиСкачать бесплатно

Каждая поисковая система создает свой индекс – собственную базу данных, в которую помещает все сайты и новые страницы. Появлению html-документа в поисковой выдаче предшествует его анализ роботом и внесение в индекс. Переход на каждую страницу осуществляется исключительно по ссылке. Индексация сайта заключается в том, что поисковая система признает его отвечающим своим требованиям, чтобы в дальнейшем предлагать пользователям.

Как происходит индексация сайта в поисковых системах

Суть индексации сайта состоит в сканировании вашего ресурса роботами-поисковиками для сохранения всей имеющейся на нем информации, включая изображения, тексты, видео и ссылки, в базе системы – индексе. Чтобы пользователи могли находить в результатах поиска ваш сайт, он предварительно должен быть одобрен роботом.

Именно поисковые роботы являются главными действующими лицами процесса индексации сайта. Они представляют собой программы автоматизированного получения данных, которые постоянно прочесывают Сеть, отыскивая ссылки на нужную информацию. Общение робота с серверами, где расположены страницы сайтов, осуществляется по протоколу HTTP, в ответ на запрос поисковик получает тело страницы. Файл robots.txt в корневой папке сервера содержит указания, какие страницы поисковик не может индексировать. Для робота эти предписания являются незыблемыми, он беспрекословно подчиняется им.

Когда документ обработан модулями поисковика, наступает очередь его анализа html-парсером, в результате остается только то, что имеет значение для поиска: оформление, текстовый контент, адреса и ссылки. Эти составляющие влияют на ранжирование страницы.

Обработанный парсером документ готов к индексированию. В этом процессе задействованы алгоритмы морфологического анализа. В результате происходит инверсия и включение в основной индекс. Управлять роботом-поисковиком можно в очень ограниченных пределах, а именно запретить ему индексировать некоторые страницы. На остальные аспекты его деятельности, включая частоту посещения сайта, можно влиять только косвенно.

Частота посещения одной страницы роботом зависит от того, с какой периодичностью ее содержимое подвергается изменениям. Если обновление происходит регулярно и через малые промежутки времени, поисковик может заходить на нее несколько раз в день. В случае более редкого внесения изменений количество «визитов» сокращается до одного-двух в неделю. Есть и такие странички, которые длительное время не подвергаются переработке. Робот на них тоже заходит, но не больше раза в неделю.

За каждое посещение поисковиком запрашивается ограниченное число страничек (20−30 штук). Делается это во избежание перегрузки сервера. Если страниц на сайте очень много, робот наносит несколько «визитов», захватывая за один раз указанное выше количество.

Мы не случайно столько внимание уделяем роботу, ведь это тот элемент, без которого невозможно функционирование поисковой системы, в том числе индексация сайтов. Робот – главный «добытчик» информации, из которой состоит индексная база, оказывающая непосредственное влияние на качество поиска.

За массовую индексацию сайтов отвечает определенный робот, именуемый «пауком». В его обязанности входит исследование страниц, переход по ссылкам и сбор информации. Заходить на ресурс он может как с главной, так и с любой другой страницы. Это может быть статья, содержащая соответствующую ссылку, или карточка с описанием товара в каталоге.

В зависимости от того, как робот попал на сайт, будет изменяться процесс индексации. Если заход был совершен на главную страницу, «паук» приступает к изучению ссылок и к осуществлению переходов по ним внутри этого же ресурса. Оказавшись на этих страницах, робот сохраняет их содержимое в индексе и ищет новые ссылки для перемещения. Так в двух словах и выглядит схема поисковой индексации сайта. Иначе говоря, это деятельность робота по пополнению системы данными, которые впоследствии можно использовать для ответа на запросы пользователей.

Для каждого поисковика характерна своя политика глубины индексации страниц сайта. Под этим подразумевают, на сколько уровней последовательно опускается робот, посещая веб-страницы одного ресурса. Если эта глубина не ограничена поисковой системой, робот вполне может проанализировать все страницы сайта, даже при максимальном уровне вложенности. Но, как правило, система разрешает роботу погружаться до определенной «метки», по достижении которой он покидает ресурс. Естественно, что при таком подходе изучаются верхние уровни, а содержание вложенных страничек остается для поисковика загадкой.

Точкой отсчета для глубины индексации может служить главная страница сайта. Это значит, что в базу попадут те странички, которые находятся на заданном «расстоянии» от нее. Но бывает, что робот попал на ресурс через страницу со статьей, находящейся далеко от главной. Глубина индексации при этом будет считаться с уровня этой страницы.

Зачем нужно подобное ограничение, почему нельзя позволить роботу анализировать весь сайт вдоль и поперек? Ответ прост: в таком случае он задержится там надолго, особенно если ресурс содержит большое количество вложенных уровней. Роботу придется изучать очень много файлов, затрачивая на это массу средств. А это противоречит самой сути поисковых систем, которые созданы отнюдь не для благотворительности. К тому же для веб-мастеров индексация сайтов ничего не стоит, хотя и может приносить им весомую прибыль.

Вывод напрашивается сам собой: если вы хотите добиться оптимальной индексации сайта всеми поисковыми системами, стремитесь свести количество уровней к минимуму. Это позволит роботу без труда анализировать их содержимое и включать в базу, то есть индексировать, а вам – получать максимальное число посетителей.

Что необходимо сделать для начала индексации нового сайта

Чтобы поисковые роботы начали индексировать сайт, необходимо:

-

Убедиться, что индексация открыта в robots.txt.

Это довольно распространенная ошибка: новый сайт не открывают для индексирования в robots.txt. Эта опция по умолчанию присутствует в большинстве систем управления ресурсами.

Закрытый от индексации сайт можно узнать по наличию звездочки:

Удаление этого значка делает сайт доступным для поисковых роботов.

Строка Disallow позволяет скрыть служебные разделы и прочие страницы, которые не требуют индексации.

-

Добавить сайт в поисковые системы.

Проще всего «открыть» сайт для поисковых систем – это добавление через формы, а также в Google webmaster tools и «Яндекс.Вебмастере».

-

Поставить ссылки с других сайтов.

На новый сайт должны вести индексируемые ссылки с других ресурсов. При наличии уже работающего собственного сайта переходы обеспечиваются с него, а при создании самого первого ссылки покупаются на специальных биржах. Оптимальным вариантом будет задействование авторитетных ресурсов, которые регулярно обновляются.

Отличной индексацией могут похвастаться блоги и сайты СМИ. Ссылочные биржи – простой и надежный способ разместить на этих ресурсах ссылки, ведущие на новый сайт, тем самым способствуя его изучению поисковиками и включению в индекс.

-

Ссылки из социальных сетей.

Положительно отражаются на индексации сайта прямые ссылки из соцсетей. Twitter, Facebook, Google Plus, YouTube – эти и многие другие площадки помогут «познакомить» поисковые системы с вашим ресурсом.

Источник: shutterstock.com

Для ожидаемого результата необходимо следить, чтобы ссылки были обязательно прямыми. Редирект, который задействован в социальной сети «Вконтакте», не позволит добиться индексации сайта.

-

Добавление сайта в социальные закладки.

Ситуация со ссылками из социальных закладок, которые еще несколько лет назад были отличным вариантом, сегодня слегка изменилась, но не для всех сервисов.

К социальным закладкам относятся такие сайты, как: bobrdobr.ru, memori.qip.ru, moemesto.ru, mister-wong.ru и сотни подобных им. Их несомненное достоинство в том, что благодаря им ваш ресурс будет быстро обнаружен поисковыми роботами.

Конечно, индексация сайта в поисковиках будет максимально успешной, если одновременно применять все способы.

Оптимизация сайта – очень важный этап раскрутки, но все меры по продвижению не принесут успеха, если ресурс не индексируется поисковыми системами, поэтому этот вопрос необходимо решить в первую очередь.

Как ускорить индексацию сайта

Как помочь поисковым роботам находить ваши страницы и добавлять их в индекс?

Быстрая индексация сайта вполне возможна. Для этого нужно:

-

обеспечить доступ на любые страницы с главной не более чем в три перехода. Бывает, что структура ресурса не позволяет этого достичь, в таком случае поможет создание карты сайта, и проблема будет решена;

-

избегать ошибок, которые допускают очень многие веб-мастера. Индексация сайта затрудняется, если использовать идентификаторы сессий. Навигация через скрипты требует обязательного дублирования ссылок обычным способом, это объясняется неумением поисковых роботов читать скрипты;

-

не забывать, что объем индексируемого текста ограничен 100−200 Кб. Если вес страницы больше, робот проанализирует только ее начало. Хотите, что все содержание попало в индекс, – ограничьтесь указанным объемом контента.

Для управления поведением поисковых роботов можно использовать файл robots.txt, с помощью которого разрешают или запрещают индексацию тех или иных страниц. Более того, специальный тег «NOINDEX» позволяет скрывать от роботов даже части страниц, но работает он только с отечественными поисковиками.

Записи в базе данных поисковых систем не находятся в неизменном состоянии, они исчезают, появляются вновь, поскольку роботы постоянно бороздят просторы Сети и отражают актуальную на данный момент картину.

Иногда успешно проиндексированные страницы пропадают из базы из-за того, что поисковик не смог получить доступ к серверу. Как только его работоспособность восстанавливается, сайт спустя некоторое время занимает свое место в индексе.

На скорость переиндексации влияет и количество внешних ссылок: чем их больше, тем быстрее проходит процесс.

Еще несколько советов по ускорению индексации сайта и не только

Раскроем секрет быстрой индексации в Google. Свяжитесь с администрациями авторитетных сайтов с высокой посещаемостью, близких по теме вашему ресурсу. Ваша задача – получить согласие на размещение ссылок у них на страницах, взамен предложив аналогичную услугу.

При высоком показателе PageRank «донорского» ресурса, на индексацию вашего сайта может потребоваться всего несколько суток.

Для ускорения попадания в индекс «Яндекса» существует несколько способов, но в целом принцип тот же, что и в «Гугле». Если на ваш сайт будут вести ссылки с раскрученных ресурсов, которые посещает большое количество пользователей, индексация пройдет быстро.

К простым и действенным вариантам ускоренной индексации сайта можно отнести использование сервисов типа «вопрос – ответ» от Mail.ru и Google. Ответив на вопрос пользователя по теме вашего ресурса, оставьте ссылку на свою страницу.

Если у вас есть веские причины избегать индексации сайта поисковиками, потребуется в файле robots.txt прописать соответствующую инструкцию:

-

User-agent: *

-

Disallow: /

Это не позволит поисковой системе вносить ваш ресурс в базу данных.

Анализ индексации сайта

Перед тем как приступать к продвижению сайта, стоит убедиться, что все его страницы включены в индексы поисковых систем – «Гугла», «Яндекса» и других. Почему это важно?

-

Не прошедшая индексацию страница не видна пользователям, и все ваши затраты, и временные, и материальные, будут напрасными. Только те страницы, которые попали в индекс, приносят вам посетителей и соответствующую выгоду.

-

Отсутствие страницы в базе поисковой системы может быть признаком технических проблем, таких как дублирование контента и внутренние глюки ресурса или хостинга.

-

Если на странице размещены платные ссылки, а в индексе ее нет, она выпадает из схемы перелинковки, следовательно, вы не получите ожидаемой прибыли.

Предлагаем подробно ознакомиться с ручными и автоматизированными способами, позволяющими проверить индексацию всего сайта и отдельных страниц в «Яндексе» и Google.

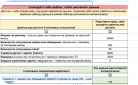

Для того чтобы узнать количество страниц на сайте, применяют несколько методов:

-

Скорее всего, используемая вами система управления сайтом достаточно современна, а значит, количество страниц можно узнать в административной части.

-

Второй вариант практически универсален (и бесплатен, если число страниц не превышает 500). Это сервис , при помощи которого можно строить xml-карты сайта. Одновременно он определяет, сколько страниц содержит ресурс. На примере это выглядит так:

-

Есть еще один способ – воспользоваться программой Xenu, найти которую в «Яндексе» не составит труда. В результате полного сканирования сайта она выдает список страниц, перечень битых ссылок и другие необходимые сведения. Однако, чтобы разобраться с тем, как она работает, понадобится время.

Итак, число страниц на сайте нам известно. Проверим, какое количество из них внесено в индекс Google и «Яндекса».

Речь идет о том, сколько страниц всего проиндексировано поисковиками. Для чего нам нужна эта информация? Чтобы сравнить общее количество страниц с числом внесенных в базу данных поисковых систем. Оптимальный вариант – полное соответствие этих значений. Если эти числа не совпадают, придется разбираться, какие страницы не проиндексированы, а какие имеют дубли.

Проверка индексации сайта в «Яндексе»

Сделать это можно различными способами:

-

Проверить индексацию сайта «Яндексом» вручную, чтобы получить приблизительный результат. Вводим в строке поиска следующую комбинацию: url:адрес-вашего-сайта*. Звездочка в конце – обязательный элемент. Для нашего сайта это выглядит следующим образом: url:sales-generator.ru*.

-

Другой вариант − использование «Яндекс.Вебмастера» . Если ваш сайт еще не подключен к такому сервису, настоятельно рекомендуем это сделать. В результате вы будете знать, сколько страниц проиндексировано, а также получать массу других нужных сведений.

Не удивляйтесь, если в итоге двух этих проверок получите разные результаты. Объясняется это просто: конструкция url:ваш-сайт считает все файлы, включая doc, xls, jpg и т. п., а «Яндекс.Вебмастер» – только сами страницы.

Проверка индексации сайта в Google

Как и в «Яндексе», для этого существует два способа:

-

Ввод комбинации site:ваш сайт вручную. Результат будет идентичен тому, что получен в «Яндексе».

-

Применение инструментов Google для веб-мастеров (аналог «Яндекс.Вебмастера»).

Подсчитав, какое количество страниц из существующих вошло в индекс поисковой системы, можно получить три варианта:

-

Число страниц на сайте и проиндексированных поисковиками идентично. Это значит, что ваш ресурс в отличном состоянии.

-

В индекс вошло меньше страниц, чем содержит сайт. Это признак того, что есть определенные проблемы, скорее всего – статьи с низкой уникальностью или недостаточно информативные.

-

Проиндексировано больше страниц, чем размещено на ресурсе. Причина – дублирование страниц, то есть к одной и той же есть доступ с разных адресов. Это отрицательно сказывается на продвижении сайта, поскольку размывается статический вес страниц и некоторые из них содержат одинаковый контент.

Чтобы продолжить диагностику, придется определить, какие именно страницы попали в индекс, а какие нет.

Необходимость в этом появляется при желании проверить конкретную (например, только что опубликованную) страницу на своем ресурсе или на чужом, где вами куплена ссылка, и вы ждете, когда страничка будет проиндексирована.

Ручной способ. Скопированный адрес страницы помещаете в поисковую строку «Яндекса» или Google. Внесенная в индекс займет верхнюю позицию в поисковой выдаче:

Автоматический способ. В этом случае используется плагин «RDS бар». С его помощью можно узнать, прошла ли индексацию страница, на которой вы находитесь в данный момент.

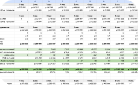

Затем определим на включение в индекс одновременно все страницы сайта. Это позволит понять, какие конкретно страницы не проиндексированы в поисковике.

Для этого потребуется не только знать, сколько страниц фактически находится на сайте, но и иметь список их адресов (url). При генерировании карты сайта создается и список страниц, однако адреса из него необходимо извлекать при помощи какой-либо программы по обработке данных.

Список всех страниц сайта получим, используя программу для Windows, функция которой – генерирование карты сайта, это Sitemap Generator (.

Настройка параметра Exclude Patterns предваряет сбор ссылок, чтобы исключить попадание ненужных. К примеру, адреса, указывающие на комментарий к странице, нам не нужны. Их можно исключить, используя маску *replytocom*.

Следующий шаг – запуск сбора url программой, по окончании которого осуществляем переход на вкладку Yahoo Map/Text, чтобы оттуда скопировать адреса (в бесплатной версии программы кнопка «Сохранить» не активна).

В итоге мы получили адреса всех страниц.

Для следующего этапа требуется программа YCCY (.

Запускаем программу и добавляем в список исходных url тот перечень адресов, который мы получили ранее. Возможности программы таковы, что проверить индексацию сайта в поисковых системах «Яндекс» и «Гугл» не составит труда, достаточно выбрать одну из них и начать процесс.

Результатом проверки станет перечень страниц, не включенных в базу данных. Наша цель – разобраться, что стало причиной. Если технических проблем нет, то индексации страницы может поспособствовать закупка ссылок на нее или ретвитов с прокачанных аккаунтов.

Проверка индексации сайта в поисковиках – очень полезная процедура, которая повысит продуктивность вашей работы с системами и поможет определить, какие проблемы присущи вашему ресурсу.

Подробнее о Google-индексации сайта

Какие страницы попали в индекс Google, нетрудно узнать при помощи оператора «site:». Один нюанс: Google индексирует сайты исходя из географического положения, это приводит к отличию в количестве страниц в google.ru и google.com.

К оператору «site:» без пробела дописываем требуемый url:

site: google.ru

Также есть возможность искать по всему домену и по конкретному подкаталогу:

site: google.com/ webmasters

Чтобы искать более избирательно, исключаем ненужные страницы, проставляя перед оператором знак «-». На примере это выглядит следующим образом:

site:google.ru -site: adwords. google.com

В результате такого поиска мы увидим все вошедшие в индекс страницы в домене google.ru, кроме страниц adwords. google.ru.

Следующий запрос позволит сделать обзор ресурсов со ссылкой на ; при этом помните, что первый вариант выдает большее количество результатов:

link:google.ru или link:www

Помимо перечисленных способов, целенаправленный поиск ссылок на конкретные страницы осуществляется по запросу:

link:google.ru/webmasters

Информацию об архивированной копии страницы, вошедшей в индекс Google, выдает оператор «cache:». Например, cache:google.ru способен воссоздать последнюю версию главной страницы сайта, проиндексированной «Гуглом», а кроме того, предоставить информацию о том, когда создан кэш. Для понимания того, как робот Googlebot может увидеть страницу, это очень удобно.

Команда «метатег noarchive» ограничивает доступ пользователей к кэш-версии страницы, которая в то же время будет проходить сканирование и индексацию Google:

<meta name="robots" content="noarchive">

Для поиска ресурсов, близких по тематике, существует оператор «related:» .

В Google доступен к применению целый ряд показателей для определения идентичности, при этом качество возвращаемых сайтов абсолютно не отражается на индексации страниц этой поисковой системой. Желающие изучить этот вопрос подробнее могут ознакомиться со статьями о дополнительном индексе Google, в котором содержатся страницы, отсутствующие в основной базе.

3 эффективных инструмента проверки индексации сайта

Хотите убедиться, что страница, которой вы придаете особое значение, проиндексирована поисковиками? Предлагаем несколько распространенных среди SEO-специалистов способов проверки.

Напомним, что суть индексирования – это добавление сведений о сайте в базу данных. Когда в систему поступает запрос, она осуществляет поиск среди страниц, которые уже находятся в ней. Поэтому следует разделять индексирование и сканирование.

Для того чтобы просканировать сайт полностью, много времени роботу не нужно. А индексация страниц может происходить достаточно медленно, некоторые не будут добавлены, а некоторые могут быть удалены из базы.

Проверьте индексацию в панели веб-мастеров

Этот способ проверки считается основным для веб-мастера или владельца сайта.

Google. Заходим в Search Console и на вкладке «Индекс Google» выбираем «Статус индексирования».

Yandex. После авторизации в «Яндекс.Паспорте» переходим в «Яндекс.Вебмастер» и идем по пути «Индексирование сайта» — «Страницы в поиске». Другой способ: «Индексирование сайта» — «История» — «Страницы в поиске». Так можно узнать динамику изменения количества страниц в поиске.

Для применения этого варианта проверки необходимо иметь определенный уровень доступа в панель веб-мастера.

Хорошее индексирование сайта выглядит примерно так. Качественных страниц все больше, и все они попадают в индекс.

Сайт с закрытой индексацией в файле robots.txt наглядно демонстрирует наличие проблем:

Используйте плагины и букмарклеты

Плагины и букмарклеты (небольшие javascript-программы, которые сохраняются в качестве браузерных закладок) позволяют автоматизировать процесс проверки. Вам не придется открывать поисковик отдельно и вводить в поисковую строку какие-либо комбинации.

Плагины и скрипты справляются с этим без вашего участия:

Так выглядит плагин RDS bar для Google Chrome. Еще больше возможностей у RDS bar для Mozilla Firefox. Вы можете осуществить проверку индексации текущей страницы и сайта полностью. Минусом бесплатных версий, несомненно, является капча.

Чтобы запустить букмарклет «Проверка индексации», необходимо перенести ссылку из открытого файла на панель закладок. Затем открываете нужный сайт и жмете на эту закладку. В ответ получите доступ к новой вкладке с Google или «Яндексом» и искомыми данными.

Установите сервисы для проверки индексации

Существует масса незаменимых помощников SEO-специалистов, один из них – Netpeak Spider.

Преимущество таких сервисов для массовой проверки индексации сайтов заключается в том, что вам доступна информация о количестве прошедших индексацию страниц, их список, а также масса дополнительных сведений: канонический адрес, код ответа, метатег роботс, название, заголовки, редиректы, метаописания, robots.txt, внутренние и внешние ссылки и тому подобное. Кроме того, если в данных есть ошибки, вы тоже узнаете об этом.

Почему сайт не индексируется

-

Новый сайт. Наберитесь терпения. Иногда приходится ждать несколько месяцев, прежде чем в индексе окажутся все страницы сайта.

-

Нет карты сайта (sitemap). Роботам гораздо проще сканировать ресурс, снабженный качественной картой. Хотите сократить время индексации сайта – добавьте ссылку на карту в панель веб-мастеров.

-

Ошибки на сайте. Оповещения об ошибках регулярно появляются на панелях веб-мастеров. Чтобы ускорить индексацию сайта в «Яндексе» или Google, отслеживайте найденные роботом ошибки и устраняйте их.

-

Ошибка с метатегом robots. Распространенная ошибка, возникающая в результате несознательного изменения настроек CMS или хостинга. В коде страниц сайта появляется следующая строка:

-

Ошибка с robots.txt. Нередко можно услышать совет прятать в robots.txt все ненужные элементы. Специфика этого файла в том, что добавлением единственного символа вы можете закрыть сайт от индексации. И даже если вы сознательно маскировали часть страниц, ненароком могли задеть те, которые расположены глубже и требуют индексации. Удостовериться, что сайт не будет добавляться поисковиком в индекс, можно по следующей конструкции в robots.txt:

User-agent: * Disallow: /

Другими причинами проблем с индексацией могут стать:

-

дубли страниц;

-

низкая уникальность контента;

-

проблемы с доступностью и скоростью загрузки.

14 распространенных ошибок, мешающих быстрой индексации сайта

Расмотрим самые распространенные ошибки, которые допускают специалисты.

Тестовая версия сайта не закрыта от индексации

Создание копий сайта для тестирования на них вносимых изменений – довольно распространенная практика, как и сохранение старой версии после редизайна. Как правило, разработчики скрывают служебные копии от индексации в robots.txt, однако в результате ошибок они все-таки могут быть включены в базу.

Чем грозит. Поисковик может признать тестовые страницы дублями продвигаемых, что негативно скажется на позициях сайта. Тестовый сайт может быть признан основным зеркалом.

Как исправить. То, что на служебные версии необходимо наложить запрет индексации сайта, понятно всем, однако полностью исключить вероятность ошибки нельзя. Советуем дополнительно к описанным мерам применять пароль для доступа к таким страницам, чтобы свести к минимуму риск попадания в индекс.

Ошибочное использование атрибута Disallow в robots.txt

Удаляя из индекса дубли или служебные страницы, можно по ошибке исключить нужные.

Чем грозит. Полезные страницы просто исчезнут из индекса, а вместе с ними позиции и трафик. Здесь требуется особое внимание, поскольку всего одна неверная директива может запретить индексацию сайта в целом.

Как исправить. Произведите проверку файла на ошибки при помощи «Анализ robots.txt». Он располагается в панели «Яндекс.Вебмастер», вкладка «Инструменты».

Убедитесь, что основные типы страниц вашего ресурса доступны для индексации. Чтобы это сделать, адреса, требующие проверки, добавляются в блок «Разрешены ли URL?» и нажимается соответствующая кнопка.

Использование этого инструмента полезно при внесении в robots.txt любых изменений.

Отсутствие закрывающего тега noindex

Для того чтобы исключить попадание служебной части текста в базы данных поисковых систем, в «Яндексе» существует тег <noindex>. Когда тег по ошибке не закрыт, индексации не будут подвергаться не только служебные страницы, но и нужные.

Чем грозит. Помеченный тегом <noindex> контент не анализируется роботом, а это приводит к отрицательным результатам при позиционировании.

Как исправить. Ограничьте частоту использования тега. Для алгоритмов «Яндекса» и так не составляет труда отличить основной контент от вспомогательных страниц. В ходе применения тега во избежание ошибок необходимо убедиться, что:

-

число закрывающих тегов noindex совпадает с числом открывающих;

-

закрывающий тег находится сразу по окончании блока со служебной информацией.

Неправильное использование тега noindex

Очень распространена ошибка, вызванная неправильным использованием тега в стремлении оптимизировать сайт.

Обычный тег запрещает индексацию прописанного в нем фрагмента текста, а метатег noindex, прописанный в коде, не разрешает включать в индекс всю страницу.

Чтобы сконцентрировать внимание поисковика на содержании страницы, от индексации закрываются ее важные элементы: шапка сайта с контактной информацией, навигационные блоки, фильтры, информация о доставке, ссылки на соцсети, отзывы.

Чем грозит. Возможны затруднения с ранжированием по продвигаемым запросам. Робот, сканируя страницу, определяет, в какой мере она отвечает на запросы пользователей. Скрывая дополнительную информацию от «Яндекса», вы рискуете понизить качественную оценку страницы.

Как исправить. Сделайте блоки с информацией, которая может быть интересна пользователям, доступными. В качестве эксперимента можете для начала сделать это только на некоторых страницах.

Заполнение метаданных и заголовков только для продвигаемых страниц

Title и Description необходимо создавать не только для страниц, продвижению которых вы уделяете особое внимание, но и для сайта в целом, включая разделы типа «Контакты», «О нас», «Доставка». Надеемся, что о том, как важна уникальность заголовков и их релевантность контенту, напоминать не нужно.

Чем грозит:

-

снижается общая оценка качества ресурса;

-

происходит потеря дополнительного поискового трафика, который мог бы поступать с неоптимизированных страниц.

Как исправить. Напишите Title и Description для каждой страницы сайта. При большом количестве применяйте шаблоны.

Использование заглавных букв в метаданных

Стремясь привлечь внимание пользователей к сниппету, некоторые оптимизаторы пишут метаданные и заголовки заглавными буквами. Такое не оправданное правилами русского языка применение регистра может восприниматься как спам.

Чем грозит. На позициях страницы в поисковой выдаче это может сказаться крайне негативно. Если эта ошибка не единственная и есть другие поводы заподозрить сайт в попытке спама, к нему могут быть применены санкции.

Как исправить. Привести написание в соответствие правилам русского языка.

Дублирование страниц из-за ошибок в структуре сайта

Эта ошибка характерна для интернет-магазинов, где карточка одного и того же товара размещается в нескольких разных разделах каталога.

Например:

site.ru/страна/производитель/товарная карточка-25

site.ru/каталог/раздел/товарная карточка-25

Чем грозит:

-

снижается скорость индексации сайта;

-

конкуренция между страницами в поисковой выдаче затрудняет продвижение.

Как исправить. Есть три варианта решения:

-

Поместив в одну папку все товарные карточки, можно избавиться от того, что одна из них привязана к разным разделам. Вне зависимости от пути поиска пользователь будет приходить на один и тот же адрес.

Пример: site.ru/товары/товарная карточка-25

-

Второй вариант оптимален для сайтов со значительным числом подкатегорий. В этом случае карточки будут находиться на пятом и далее уровнях вложенности.

Один адрес страницы остается основным, а с карточек настраивается 301 редирект на него. От проблемы дублирования это поможет избавиться, но приведет к запутыванию пользователей, которые будут переадресовываться из одной категории в другую.

-

Третий способ – один адрес страницы остается основным, а на всех карточках она указывается в качестве канонической. Это удобнее для пользователей и помогает решить проблему с дублями.

Дубль на первой странице пагинации

Не менее распространена и такая проблема с дублированием. Основная страница и первая страница пагинации должна быть доступна по одному и тому же адресу, по сути это одна и та же страница. Но в результате ошибок разработчиков появляются дубли.

Пример дублирования:

-

ru/каталог/раздел/

-

ru/каталог/раздел?page1

Чем грозит:

-

расходуется краулинговый бюджет сайта, ухудшается его индексация;

-

дубль затрудняет продвижение основной страницы.

Как исправить:

-

убедиться, что первая ссылка в пагинации ведет на основную страницу;

-

при наличии дубля требуется не только исправить ссылку, но и настроить 301 редирект.

Не стоит думать, что ошибки, связанные с дублированием страниц, исчерпываются описанными двумя. К сожалению, проблем такого типа гораздо больше, и чтобы рассмотреть их все, нужна отдельная статья.

Ошибка в использовании канонических адресов

К часто встречающимся ошибкам относится указание адреса как канонического для всех страниц сайта, не смотря на то, требуется их индексация или нет. Это бывает, когда программист выполняет задачу по прописыванию канонических адресов без предварительной сверки со справкой Google или «Яндекса».

Чем грозит. Дублирующие страницы сохраняются на сайте, в результате чего он хуже индексируется и продвигается.

Как исправить. Воспользоваться рекомендациями «Яндекса» или советами Google и устранить погрешности настроек.

Нелишним будет при указании канонических адресов ознакомиться со списком частых ошибок, подготовленным специалистами Google.

На сайте настроен 302 редирект вместо 301

Для корректного «склеивания» страниц сайта необходим 301 редирект, который свидетельствует о смене адреса страницы навсегда. Однако нередко на сервере по умолчанию включен 302 редирект (временное перемещение сайта по другому адресу).

Чем грозит. Поисковик может выдавать в результатах предыдущую версию страницы, к тому же есть риск утратить параметры старой версии.

Как исправить. Настроить 301 редирект.

Внутренние ссылки на сайте работают через редирект

Это происходит, если на сайте настроен редирект на версию страницы со слешем на конце, а внутренние ссылки – на страницы без слеша. Пользователь, кликнувший по ссылке, сначала попадает на страницу без слеша и только потом перенаправляется по нужному адресу. Для людей этот внутренний редирект остается незамеченным, но для роботов это важный показатель.

Чем грозит. Создается лишняя нагрузка на сервер и «съедается» часть краулингового бюджета сайта.

Как исправить. Проследить, чтобы все внутренние ссылки приводили на запрашиваемые адреса без дополнительных переходов.

Как правило, такая ошибка встречается не на всех страницах, а в отдельных блоках или разделах. Для нахождения таких ссылок потребуется полный анализ сайта. Сервисы для этого представлены в Сети в большом количестве.

Сайт часто недоступен

От таких проблем не застрахован ни один проект, но здесь важна частота и продолжительность периодов недоступности. Если на сайт нельзя зайти в течение получаса один раз в месяц, это не нанесет урона его продвижению. Когда доступа к ресурсу нет чаще и в течение длительных периодов, стоит вплотную заняться выяснением причин.

Чем грозит. Если сайт часто и подолгу недоступен, это негативно отражается на его авторитете с точки зрения поисковых алгоритмов, что с большой долей вероятности приведет к временному удалению страниц из индекса.

Как исправить. Прежде всего, проверить, как часто к сайту нет доступа, при помощи отчетов «Яндекс.Метрики»:

Отчеты -> Стандартные отчеты -> Мониторинг -> Результаты проверок

При регулярных проблемах с доступностью обратитесь в поддержку хостинга. Не удалось разрешить ситуацию – смените хостинг на более надежный.

Контактная информация в шапке в виде картинок

Особенность коммерческих сайтов заключается в том, что пользователям очень важно иметь легкий доступ к контактной информации, в идеале все способы связи должны находиться в шапке. Но корректное распознавание текста на картинках плохо дается поисковым алгоритмам, значит, сведения, значимые для пользователей, должны быть представлены в виде текста.

Чем грозит. Ошибка будет тормозить рост позиций по коммерческим запросам.

Как исправить. Изменить верстку шапки сайта – важную информацию представить в виде текста.

Отсутствие на продвигаемых страницах информации о цене

Сведения о стоимости товара имеют большое значение для ранжирования по коммерческим запросам. Просто добавив цены на страницу, вы сможете получить резкий скачок вверх.

Чем грозит. Отсутствие информации о стоимости товаров или услуг негативно сказывается на ранжировании по коммерческим запросам.

Как исправить. Изучите сайты конкурентов в выдаче по интересующим вас запросам. Это делается вручную или при помощи специальных сервисов. Например, подобный есть у SeoLib.

Оставить комментарий

Оставить комментарий