В статье рассказывается:

- Простой принцип индексации сайта

- Отличия индексации сайта от сканирования

- Отличия индексации в Google и «Яндексе»

- 2 варианта, как попасть в индекс поисковика

- 3 способа проверить индексацию сайта

- Особенности индексиования сайтов с разными технологиями

- Типичные проблемы индексации сайта

- Советы, как ускорить индексирование сайта

- 3 метода закрыть страницу или сайт полностью от индексации поисковика

Поисковая индексация сайта — это то, что нужно любому интернет-ресурсу. Без этой процедуры о вашей платформе не узнает ни один пользователь в Сети. Самостоятельно попасть в поисковик сайт не сможет — индексацию нужно подключить его владельцу. Сделать это нужно как минимум в двух системах — «Гугл» и «Яндекс». Остальные поисковики — на ваше усмотрение, принцип подключения везде одинаков.

Но мало отправить ресурс на индексацию — ее еще нужно и проверить, вдруг какие страницы не прошли проверку роботами. Если это так, то придется исправить обнаруженные ошибки. А если на сайте есть какая-то информация, о которой поисковикам не нужно знать, то ее можно легко скрыть от индексации. Об этом и многом другом мы подробно рассказали в статье ниже.

Простой принцип индексации сайта

Поисковая индексация сайта происходит так: специальный поисковый робот собирает информацию о контенте, который размещен на ресурсе. Он учитывает ключевые фразы, ссылки, фотографии — все, что есть на платформе. Все собранные сведения сохраняются в базе данных — поисковом индексе. Когда пользователи ищут какую-либо информацию в Интернете, в ответ на их запросы выдаются результаты из этой базы данных.

Ответ на любой запрос потенциально содержат тысячи адресов веб-ресурсов. Google или «Яндекс» знают этот ответ еще до того, как пользователь напечатал текст запроса в поисковой строке. Поисковую индексацию сайтов веб-роботы ведут постоянно, база данных все время пополняется новыми сайтами. И, когда пользователь что-то ищет в Интернете, фактически он ищет нужный индекс.

Дочерние страницы сайта — те, которые идут после главной, индексируются по одной. Когда робот осуществляет поиск по индексу, он находит все соответствующие запросу страницы, получая огромное количество результатов.

Google и «Яндекс» используют специальные алгоритмы, которые помогают дать наиболее точный ответ на любой пользовательский запрос. При индексации сайта в поисковых системах они учитывают несколько сотен факторов: число ключевых слов, релевантных словосочетаний, качество сайта, его удобство для пользователя, защищенность конфиденциальных данных, которую он гарантирует. Казалось бы, определение позиции сайта и отображение результатов поиска должны быть долгим процессом, но Google и «Яндекс» выполняют его в среднем за полсекунды.

В Интернете содержатся сотни миллиардов адресов, занимающих более 100 млн гигабайт. Каждый сайт получает назначение для индекса в соответствии со словами, из которых состоит его контент.

Источник: eamesBot/ shutterstock.com

Поисковые алгоритмы вычисляют, какой сайт больше всего подходит под запрос пользователя, и упорядочивают результаты в индексе. Специалисты Google и «Яндекса» неустанно совершенствуют работу своих алгоритмов. Их поисковые роботы умеют различать ключевые слова и опечатки, которые люди допускают при вводе запроса. Также они оценивают, насколько сайту можно доверять, достоверен ли его контент, каково качество ссылок, какие цели преследует пользователь.

Отличия индексации сайта от сканирования

Итак, мы разобрались, что такое индексация сайта в поисковых системах. Однако также существует термин «сканирование». Это не индексация страниц, а перемещение робота от одной страницы к другой.

Термин «сrawling» означает отправку бота на анализируемый сайт, индексирование — это процесс загрузки, обработки и сбора данных, после которого ресурс включается в индекс поисковой системы. Что касается сканирования, оно не означает, что адрес сайта был проиндексирован и будет выдаваться пользователям как результат их поисковых запросов.

Веб-адрес размещается в индексе после сканирования. Не каждая просканированная страница оказывается в индексе, но каждая проиндексированная изначально сканировалась.

Краулинговым бюджетом называется максимальный объем данных, которые поисковая система получает с домена в результате посещения роботом. Чтобы этот объем данных оказался как можно больше, нужно учесть два аспекта:

-

ограничение скорости сканирования;

-

ускорение индексирования сайта.

Поисковые роботы стремятся за одно посещение сайта просканировать как можно больше URL-адресов. Если скорость сканирования ограничена, они делают обход без перегруза сервера. Если же краулер будет загружать слишком большое количество страниц одновременно, сайт будет грузиться слишком долго. Пользователи могут просто уйти, не дождавшись окончания этого процесса.

Чтобы ограничить скорость сканирования, ранее указывали директиву crawl-delay в файле robots.txt. На данный момент она является устаревшей, потому что поисковые системы сами контролируют скорость. При слишком серьезной нагрузке на сервер сканирование прекращается автоматически. Если ваш веб-ресурс слишком много «весит», нужно оптимизировать его. Это позволит роботам тратить меньше времени и осуществлять полное сканирование.

Ускорить процесс поисковой индексации сайта можно, принудительно вернув робота на сайт. Как это делается? Обновленные страницы перенаправляются на повторное сканирование через панель веб-мастера. Имейте в виду, что сайты с высокой посещаемостью и ресурсы, где регулярно обновляется контент, обрабатываются чаще. Поисковые роботы замечают изменения и проводят работу. А прекращение работ по оптимизации ресурса приводит к понижению его позиции в выдаче.

Бюджетом индексации сайта называют число URL-адресов, которые поисковая система может и хочет проиндексировать. Единица его измерения — мегабайт (Мб).

Источник: BestForBest/ shutterstock.com

Каждый домен имеет свой ежедневный бюджет. Когда он израсходован, боты прекращают индексирование сайта. Далее они проверяют обновления на уже загруженных адресах. Если сайт имеет некачественную структуру, некоторые его страницы могут вообще не индексироваться.

При разработке сайта стоит в первую очередь думать не о его привлекательном виде, а об удобстве для пользователей с учетом дальнейшей оптимизации. Важные дочерние страницы должны иметь приоритет в иерархии структуры ресурса. Тогда индексация сайта в поисковых системах будет происходить должным образом.

Неизвестно, когда именно поисковый робот повторно придет на сайт, когда именно он прекращает сканирование и когда возвращается к нему.

Индексирование сайта происходит циклично. Вам следует регулярно обновлять контент, если вы хотите, чтобы ресурс занимал высокие позиции в результатах выдачи. После первого посещения роботы периодически наносят повторные визиты с целью проверить и проиндексировать изменения. Если они часто обнаруживают на вашем ресурсе полезный и актуальный контент, то будут возвращаться снова. И чем раньше сайт пройдет индексацию, тем скорее он появится в результатах поисковой выдачи.

Отличия индексации в Google и «Яндексе»

-

Индексация сайта в Google

Когда пользователь задает в Google запрос, поиск информации ведется по индексу поисковика, в котором хранятся сотни миллиардов страниц. При этом учитывается местоположение человека, язык, на котором он ввел запрос, тип устройства и т. д.

В 2019 году Google запустил Mobile-first, что полностью поменяло основной принцип поисковой индексации сайтов. Теперь в индексе Google хранятся мобильные версии страниц и именно они имеют приоритет при поиске, который ведет робот Googlebot для смартфонов. На новый способ индексирования переходят все веб-ресурсы. Их владельцы получают соответствующую информацию в Google Search Console.

Источник: PK Studio/ shutterstock.com

У Google есть и другие отличия индексации:

-

обновление индекса происходит регулярно;

-

сайт индексируется в срок от считаных минут до семи дней;

-

страницы, не отвечающие стандартам качества, понижаются в рейтинге, но остаются в индексе.

Все страницы, которые были просканированы, попадают в индекс, но пользователь по своему запросу видит лишь самые качественные. Поисковый робот проверяет релевантность каждого сайта по более чем 200 критериям.

-

Поисковая индексация сайта в «Яндексе»

Алгоритмы «Яндекса» производят индексирование сайтов примерно по тому же принципу. Поисковые роботы посещают сайт, обрабатывают контент и размещают страницу в индексе, чтобы впоследствии она попала в выдачу.

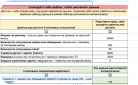

Важная информация про индексацию в «Яндексе»:

-

индекс поисковика обновляется во время обновлений поисковой базы, что происходит в среднем раз в три дня;

-

веб-страница индексируется в срок от 7 до 30 дней;

-

«Яндекс», в отличие от Google, удаляет некачественные страницы из индекса.

«Яндекс» выдает пользователям только сайты, наиболее полно отвечающие поисковому запросу, содержащие полезный контент и не представляющие сложности в использовании.

Каким образом поисковые роботы попадают на ваш ресурс? Это происходит несколькими способами.

2 варианта, как попасть в индекс поисковика

Чтобы поисковая индексация вашего сайта осуществилась, поисковики должны получить информацию о нем. Донести ее им можно следующими двумя способами:

-

Посредством инструментов поисковых систем

Большинство поисковиков имеет сервисы для веб-мастеров. У Google и «Яндекса» это Search Console и Яндекс.Вебмастер. При этом в сервисе «Яндекса» имеется специальный инструмент, который позволит отправлять от 20 ссылок в день на страницы, чья индексация является приоритетной.

Но, если речь идет об индексации ресурса в целом, а не отдельных его страниц, наибольший эффект даст его добавление в «Яндекс» и Google с указанием ссылки на карту сайта (файл Sitemap) в Search Console и Яндекс.Вебмастере. Если сделать так, поисковые роботы будут сами заходить на ваш сайт и его новые страницы и размещать их в индексе. Если вы не знаете, как составить карту сайта, то найдете эту информацию в руководстве Google. Скорость попадания сайта в выдачу будет зависеть от многих факторов, в среднем нужно будет подождать 1-2 недели.

-

Посредством ссылок с других сайтов

Чтобы привлечь внимание поисковых роботов к вашей веб-странице, выложите ссылки на неё на других сайтах, желательно на новостных. Поисковые алгоритмы часто проверяют такие сайты и расценивают найденные на них ссылки как полезные. Если вам повезет, то индексирование может случиться примерно за сутки.

Попадание страницы в поисковую выдачу зависит от контента. Если робот сочтет его релевантным, то проиндексирует её и страница появится в поисковой выдаче.

3 способа проверить индексацию сайта

Чтобы проверить, проведена ли индексация интересующего вас сайта в поисковых системах бесплатно, есть три способа:

-

Используйте Яндекс.Вебмастер и Search Console

В Яндекс.Вебмастере найдите инструмент «Проверить статус URL». Добавьте ссылку на интересующую вас страницу и в течение двух минут узнаете ее статус в поисковике. Иногда на эту проверку может уйти несколько часов.

Если вы используете Search Console, введите ссылку на страницу в поисковую строку, которую увидите в верхней части экрана. Откроется форма, которая покажет, индексировалась ли страница.

-

Используйте команду «site»

Есть специальная команда, которая даст вам возможность проверить все попавшие в индекс поисковиков страницы. Для этого наберите в поиске «Яндекса» или Google запрос вида «site:mysite.ru» (кавычки не ставьте). Проверка индексации сайта в поисковых системах будет проведена.

-

Используйте сервисы

Источник: BestForBest/ shutterstock.com

Чтобы проверить индексацию сайта в поисковых системах онлайн, можно использовать сторонние сервисы. Мы рекомендуем «Серпхант». С его помощью вы сможете проверить индексацию сразу 50 страниц в «Яндексе» и Google. Введите ссылки на поисковики в специальную форму (не забудьте начать с http:// или https://) и кликните на «Начать проверку». Порой результаты проверки по 1-2 позициям появляются не очень быстро, но для функциональности это не имеет серьезного значения.

Также можно использовать плагин RDS Bar для Chrome, Firefox и Opera. С этим сервисом вы получите информацию о том, была ли проиндексирована любая открытая в браузере страница.

Особенности индексирования сайтов с разными технологиями

-

AJAX

В современном мире мы все чаще видим JS-сайты с динамическим контентом. Загрузка таких сайтов происходит быстро, что делает их очень удобными для пользователей. Если такой сайт разработан на AJAX , то весь контент загружается одним сплошным скриптом. Разделения на страницы с URL нет, вместо этого используются страницы с хештегом #. Поисковые роботы не индексируют их. Получается, что вместо URL формата https://mywebsite.ru/#example алгоритм обращается к https://mywebsite.ru.

В этом случае поисковые роботы не могут считать весь контент сайта и это влечет за собой проблемы. Ведь поисковикам, чтобы оценить сайт как хороший, нужен текст, который они могут просканировать, а не интерактивное веб-приложение, игнорирующее суть веб-страниц с URL.

Еще пять лет назад провести SEO-индексацию такого сайта было очень сложно. Но сейчас Google и «Яндекс» знают, как без ошибок индексировать AJAX-сайты.

В 2019 году сайты на AJAX начали рендериться Google напрямую. Что это означает? Поисковые роботы сканируют и обрабатывают #! URL так, как это сделал бы человек. Это позволяет не прописывать HTML-версию страницы.

Однако убедитесь, что скрипты со стилями в вашем robots.txt открыты для индексирования поисковыми роботам. Чтобы это сделать, добавьте в robots.txt следующие команды:

User-agent: Googlebot

Allow: /*.js

Allow: /*.css

Allow: /*.jpg

Allow: /*.gif

Allow: /*.png

Что касается «Яндекса», его алгоритмы тоже могут осуществлять поисковую индексацию AJAX-сайтов, но только в том случае, если у каждой страницы есть HTML-версия. Информацию о том, как поставить робота в известность о наличии HTML-версии страницы, вы найдете в справочнике «Яндекса».

-

Флеш-контент

Компания Adobe 20 лет назад разработала технологию Flash, которая позволяет создавать для сайта интерактивный контент с анимацией и звуком. Эта технология имеет немало недостатков — она создает серьезную нагрузку на процессор, приводит к проблемам в работе флеш-плеера и ошибкам при индексировании контента поисковиками.

Роботы Google не индексируют флеш-контент с 2019 года. Роботы «Яндекса» индексируют только текст во Flash-документах, размещенный в блоках DefineText, DefineText2, DefineEditText, Metadata.

Чтобы не затруднять индексацию сайта в поисковых системах, не используйте Flash или хотя бы сделайте и текстовую версию ресурса. Ее смогут использовать люди, у которых не установлена программа отображения Flash, пользователи мобильных устройств (на них невозможно смотреть flash-контент), и алгоритмы «Яндекса».

-

Фреймы

Фреймом называется HTML-документ, в котором нет собственного контента и элемента body. Он состоит из разных областей с отдельными страницами.

Поисковые алгоритмы не могут найти полезный контент для сканирования, поэтому страницы с фреймами индексируются плохо, в ходе их обработки роботами возникают ошибки.

Как поисковики работают с такими сайтами? «Яндекс» индексирует содержимое тегов <frameset> и <frame>, игнорируя документы, подгружаемые в тег <iframe>. Роботы Google могут индексировать контент внутри встроенного фрейма iframe. Он позволяет избежать применения тега <iframe>.

Учтите, что теги <frame>, <noframes>, <frameset> устарели и уже не поддерживаются в HTML5. Не стоит использовать их на сайтах. Даже если алгоритмы проиндексируют страницы с фреймами, у вас все равно будут сложности с их продвижением.

Типичные проблемы индексации сайта

- Новизна ресурса. Если ваш сайт только создан, наберитесь терпения. Поисковая индексация сайта может произойти через несколько месяцев.

-

Отсутствие карты сайта (sitemap). Если ее нет, поисковым роботам сложнее просканировать и проиндексировать ресурс. Создайте карту сайта и добавьте ссылку в панель веб-мастеров и файл robots.txt.

-

Ошибки на сайте. Панели веб-мастеров информируют о них владельцев сайтов. Если вы столкнулись с проблемами при индексации, то проверьте, есть ли ошибки, и исправьте их.

-

Ошибка с метатегом robots. Эта ошибка случается при несознательном изменении настроек CMS или хостинга. Когда она допущена, в коде страниц сайта появляется вот такая строка: <meta name=”robots” content=”noindex, follow” />

-

Ошибка с X-Robot-Tag.X-Robots-Tag — это HTTP-заголовок, который находится в файле конфигурации сервера. С его помощью веб-мастер закрывает сайт, чтобы внести какие-либо изменения, но он может забыть удалить этот заголовок. Проверить, имеет ли место такая ситуация, можно в Netpeak Spider или в консоли разработчика.

-

Ошибка с robots.txt. Файл robots.txt имеет такую особенность — даже один лишний символ может помешать сканированию вашего сайта. Проверьте, есть ли у вас в robots.txt такая конструкция: User-agent: * Disallow: /

Что еще может вызвать проблемы с поисковой индексацией сайта:

-

дубли страниц;

-

контент, повторяющий информацию с других сайтов;

-

низкая скорость загрузки.

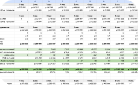

Советы, как ускорить индексирование сайта

Вопрос о том, как сделать индексацию сайта в поисковых системах быстрой, волнует всех владельцев веб-ресурсов. Ведь чем быстрее поисковые алгоритмы проверят новый контент, тем быстрее страница появится в поисковой выдаче и привлечет пользователей, которые будут заказывать товары и оставлять заявки на услуги.

Источник: bsd studio/ shutterstock.com

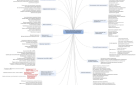

Скорость индексации сайта зависит от следующих факторов:

-

Авторитетность и востребованность у пользователей.

-

Отсутствие ошибок в процессе индексации.

-

Частота появления новой информации и ее качество.

-

Наличие ссылок: внутренних и внешних.

-

Вложенность страниц.

-

Корректное заполнение файлов sitemap.xml и robots.txt.

-

Верно выставленные ограничения в robots.txt.

Чтобы ускорить индексацию сайта в поисковых системах, сделайте следующее:

-

Подберите надежный и быстрый хостинг.

-

Поставьте сайт на индексацию в поисковики «Яндекс» и Google.

-

Настройте robots.txt, запретив посещение технических и служебных страниц, а также просмотр информации, не представляющей пользы для посетителей.

-

Создайте файл карты sitemap.xml и сохраните его в корне сайта. Поисковые роботы используют его, чтобы проверить структуру страниц и обновление контента.

-

Проверьте код всех страниц на наличие ошибок и дублей.

-

Убедитесь, что в текстах нужное количество ключевых слов.

-

Регулярно публикуйте полезный контент. Если вы настроите внутреннюю перелинковку между статьями и страницами, то вовлеченность пользователей повысится и сайт будет занимать более приоритетные позиции в выдаче.

-

Настройте навигацию сайта. Сделайте так, чтобы доступ к нужной странице с главного меню требовал не более трех кликов. К удобству использования сайтов сегодня предъявляются повышенные требования. От этого зависит, как поведут себя посетители ресурса. Если им придется более десяти раз кликать, чтобы получить нужную информацию, 90 % человек уйдут с сайта.

-

Разместите ссылки на ресурс на различных площадках, откуда можете получить трафик, например в соцсетях и на тематических форумах.

Также помните о том, что вес картинок на сайте лучше уменьшить. «Тяжелая» графика замедляет загрузку страниц, что негативно влияет на поисковую индексацию сайта, а значит, и на его продвижение в выдаче.

3 метода закрыть страницу или сайт полностью от индексации поисковика

Бывают ситуации, когда нам нужно узнать не как настроить индексацию сайта в поисковых системах, а, наоборот, как избежать внимания роботов. Служебные страницы вашего сайта и те, которые еще в разработке, не должны попадать в выдачу. Запретить их индексацию можно тремя способами:

-

С помощью команды Disallow в файле robots.txt.

Файл robots.txt содержит правила для поисковых роботов. В зависимости от того, что там будет прописано, они смогут индексировать какие-то страницы, а к другим у них не будет доступа. Чтобы закрыть страницу от роботов, используйте команду Disallow. Более подробную информацию о работе с файлом robots.txt вы найдете в руководстве «Яндекса».

-

Добавьте тег noindex в HTML-код страницы.

Если вы хотите помешать алгоритмам проиндексировать определенную страницу или ряд страниц, пропишите этот тег в HTML-коде страницы.

-

Прибегните к авторизации.

Личный кабинет на сайте и страницы, находящиеся в разработке, можно закрыть от индексации, использовав форму авторизации. Этот способ является самым действенным. Помните про него, потому что страницы, индексацию которых вы запретили в robots.txt или директивой noindex, все равно могут оказаться в выдаче, если на них ведут ссылки с других страниц.

Алгоритмы проведут поисковую индексацию сайта с любым количеством страниц. Объем индекса Google превышает 100 млн гигабайт ― это сотни миллиардов проиндексированных страниц, и с каждым днем их становится все больше.

Но учитывайте, что успешность индексации вашего сайта во многом зависит от вас. Если вы понимаете принципы этого процесса, то не совершите неверных действий. Корректно заполните файл robots.txt, создайте карту сайта, выполните технические требования поисковиков, наполните сайт качественным контентом ― и все получится.

При этом помните, что главное для продвижения сайта ― не просто его попадание в поисковую выдачу. Важно, сколько и каких страниц там окажется, какой контент на них будет просканирован и каковы будут его позиции в выдаче. Судьба вашего ресурса в ваших руках!

Оставить комментарий

Оставить комментарий